简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

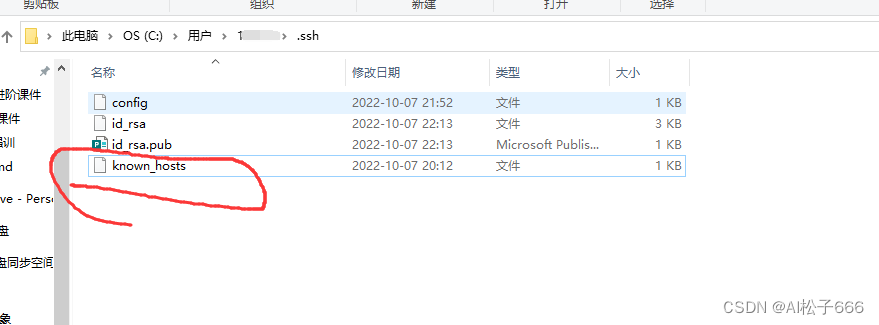

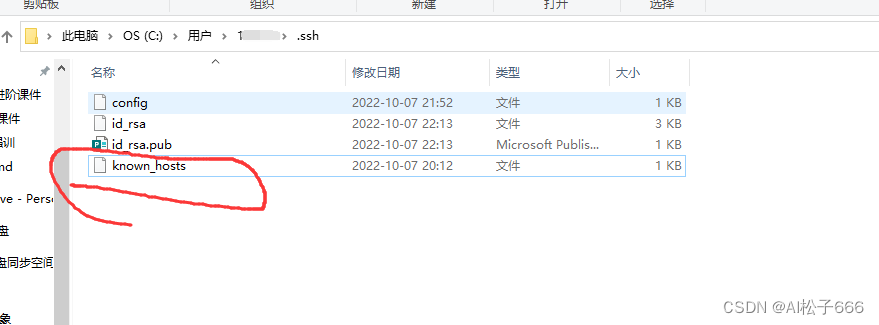

即使在远程主机添加了本地的公钥也不行。直接报错:Could not establish connection to…这是因为vs code在连接和ssh终端连接类似,由于之前连过该ip对应的服务器,多次异常退出了服务端,可能导致后续vscode链接服务器时循环输入密码无法连接;最近通过vscode一直使用腾讯云的服务器作为远程开发环境,以前一直很好用。,就连接失败了,本质上是vscode的阻止行为

一、综述1.1概述:3D目标检测目前主要的应用场景就是自动驾驶,自动驾驶车不仅仅需要识别障碍物的类型,还需要识别物体的精确位置和朝向。以提供信息给规划控制模块,规划出合理的线路。3D目标检测旨在通过多传感器数据如LIDAR、Camera、RADAR等,使得自动驾驶车辆具备检测车辆、行人、障碍物等物体的能力,保障行驶安全,是自动驾驶领域要解决的核心问题之一。普通2D目标检测并不能提供感知环境所需要的

前言虽然业界有很多的争论,但是LiDAR在目前的L3/L4级自动驾驶系统中依然是不可或缺的传感器,因为它可以提供稠密的3D点云,非常精确的测量物体在3D空间中的位置和形状,而这是摄像头和毫米波雷达很难做到的。那么相应的,基于LiDAR点云的感知算法也就成为了近年来自动驾驶研发的重点之一。与图像的感知算法类似,LiDAR点云的感知算法也分为物体检测(包括跟踪)和语义分割两大类。这篇文章主要关注基于L

一、综述1.1概述:3D目标检测目前主要的应用场景就是自动驾驶,自动驾驶车不仅仅需要识别障碍物的类型,还需要识别物体的精确位置和朝向。以提供信息给规划控制模块,规划出合理的线路。3D目标检测旨在通过多传感器数据如LIDAR、Camera、RADAR等,使得自动驾驶车辆具备检测车辆、行人、障碍物等物体的能力,保障行驶安全,是自动驾驶领域要解决的核心问题之一。普通2D目标检测并不能提供感知环境所需要的

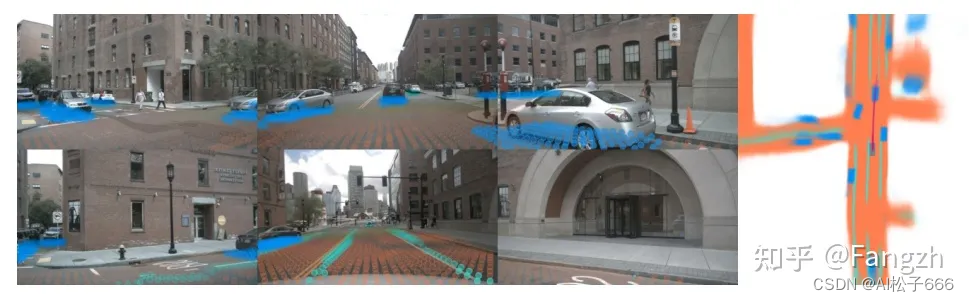

LSS是一篇发表在ECCV 2020上有关自动驾驶感知方向的论文,具体子任务为object segmentation and map segmentation。论文和官方repo如下:论文:https://link.zhihu.com/?官方repo:https://link.zhihu.com/?目前在自动驾驶领域,比较火的一类研究方向是基于采集到的环视图像信息,去构建BEV视角下的特征完成自动

背景:部署fast-reid工程环境的时候报出ModuleNotFoundError: No module named 'apex’的错误纯粹记录一下 no module named ‘apex’ 的解决方案:1.官方安装方法(我没能成功)git clone https://github.com/NVIDIA/apexcd apexpip install -v --no-cache-dir --g

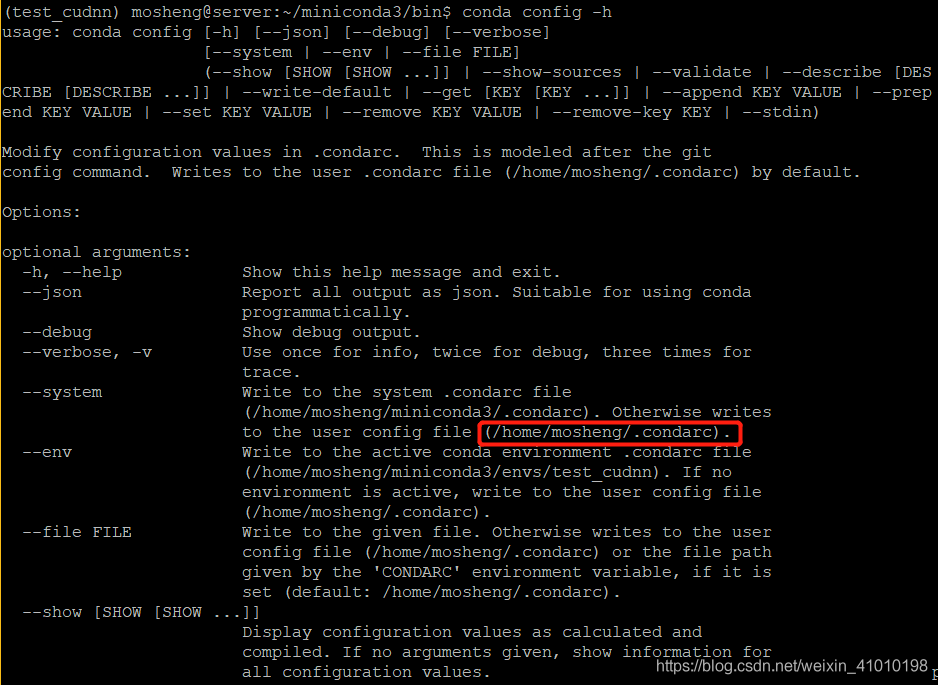

一、连接超时原因连接超时一般是由于网络的原因,还有默认的下载源是在国外的服务器,所以一般下载速度回比较慢,在下载比较大安装包就会出现下载中断的现象。二、解决conda下载超时的两种办法1、添加下载镜像地址1.pip解决超时添加超时参数 ‘–timeout’添加镜像源地址参数-i一般我们用pip下载超时,可以添加下载超时参数,也可以加 -i 然后在后面加上国内的镜像地址,下载速度就会提升很快,常用的

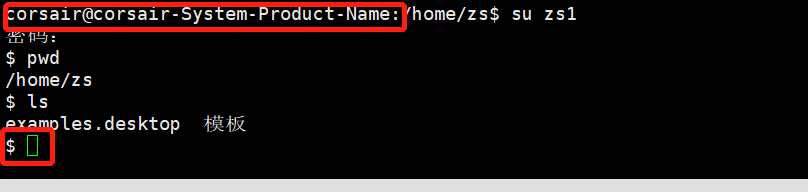

服务器新建用户:创建用户、设置密码、修改用户、删除用户:useradd testuser创建用户testuserpasswd testuser给已创建的用户testuser设置密码说明:新创建的用户会在/home下创建一个用户目录testuserusermod --help修改用户这个命令的相关参数userdel testuser删除用户testuserrm -rf testuser删除用户tes

即使在远程主机添加了本地的公钥也不行。直接报错:Could not establish connection to…这是因为vs code在连接和ssh终端连接类似,由于之前连过该ip对应的服务器,多次异常退出了服务端,可能导致后续vscode链接服务器时循环输入密码无法连接;最近通过vscode一直使用腾讯云的服务器作为远程开发环境,以前一直很好用。,就连接失败了,本质上是vscode的阻止行为

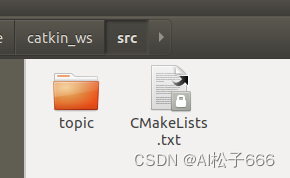

一、新建一个ROS工作空间并创建功能包二、创建一个msg消息三、发布话题四、订阅话题Ubuntu18.04ROS Melodic执行完毕后建立了工作空间catkin_ws,并创建了功能包topic。在topic包的目录下创建msg文件夹并在msg文件中添加消息成员填入以下内容:header是消息头,包含了序列号,时间戳,frame_id,一般每个消息都有这个成员,其他的成员可以根据需要随便取。编辑