简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在使用Ollama进行AI模型管理时,有时需要根据实际需求更改模型文件的存储路径。本文将详细介绍如何在Linux系统中更改Ollama模型的下载路径。在新的路径/data/ollama/models下,会看到生成了blobs和manifests文件夹,这表明模型路径已经成功更改。进入默认的模型路径/usr/share/ollama/.ollama/models,会发现models文件夹已经消失。在

MCP,即Model Context Protocol(模型上下文协议),是由Claude的母公司Anthropic在2024年底推出的一项创新技术协议。在它刚问世时,并未引起太多关注,反响较为平淡。然而,随着今年智能体Agent领域的迅猛发展,MCP逐渐进入大众视野并受到广泛关注。今年2月,Cursor宣布正式支持MCP功能,这无疑为MCP的推广按下了加速键,使其迅速走进了众多开发人员的视野。从

这些工具的结合将为你的AI项目提供强大的支持,无论是模型训练、推理还是交互式应用,都能轻松实现。DeepSeek R1是其最新版本,支持多种AI模型的本地部署,能够满足不同场景下的需求。进入ollama的模型库,选择deepseek-r1,就能够看到里面的各种安装命令了,可以选择不同大小的模型进行本地部署,但也是需要与自己电脑的配置相适应,否则GPU容易出问题。4. 验证安装:打开浏览器,访问ht

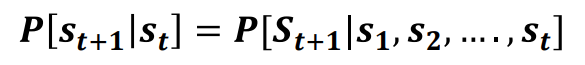

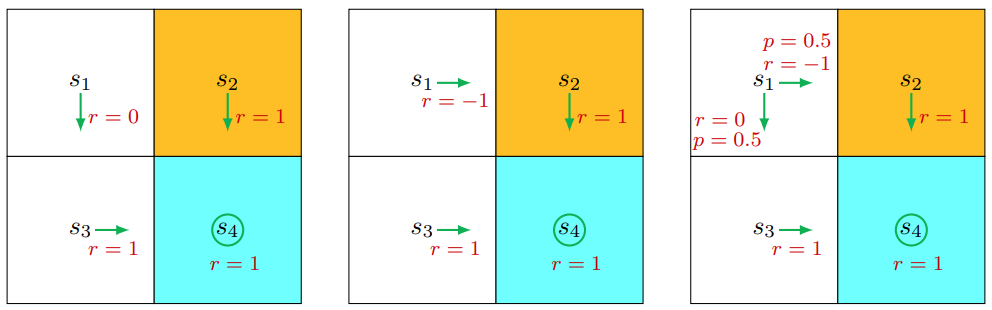

马尔科夫过程:通过状态转移概率的实现的过程,马尔科夫过程是一个****,S是有限状态集合,P是状态转移概率。马尔可夫过程是指一个满足马尔可夫性质的随机过程。一个马尔可夫过程由状态空间SSS和状态转移概率矩阵PPP组成。状态转移概率矩阵PPP表示了从一个状态转移到另一个状态的概率。马尔科夫奖励过程:马尔可夫奖励过程是在马尔可夫过程的基础上增加了奖励的概念。一个马尔可夫奖励过程由状态空间SSS、状态转

这一次来由浅入深认识一下价值函数以及动态规划解决优化问题首先我们要理解一下状态价值函数,这是bellman equation的第一次正式推导。

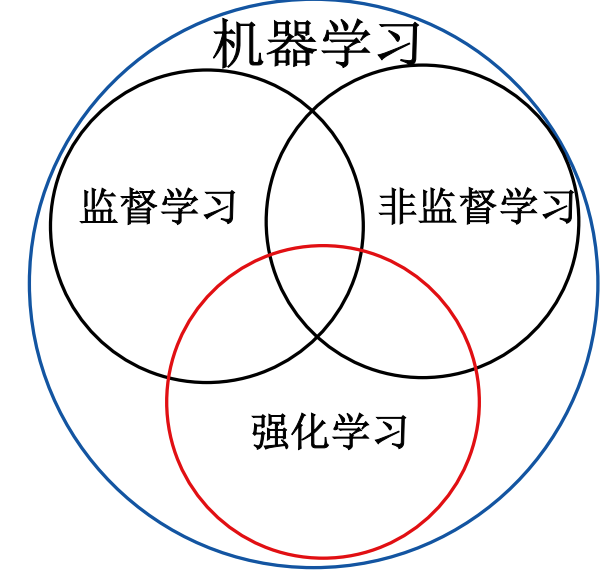

强化学习是机器学习的一种,是一种介于监督学习和非监督学习的机器学习方法。学习二字就很形象的说明了这是一种利用数据(任何形式的)来实现一些已有问题的方法,学习方法,大致可以分为机器学习,监督学习,非监督学习和强化学习。机器学习:机器学习是用数据或以往的经验,以此优化计算机程序的性能标准。 监督学习:已知数据和其一一对应的标签,训练一个智能算法,将输入数据映射到标签的过程。 非监督学习:已知数据不

回归任务常用指标包括:MSE(平方误差均值,对大误差敏感)、MAE(绝对误差均值,抗异常值)、RMSE(MSE开方,单位一致)和R²(模型解释力)。分类任务主要指标有准确率、精确率(查准率)、召回率(查全率)和F1-Score(精确率与召回率的调和平均)。多分类任务中,每个类别可单独计算精确率和召回率,通过混淆矩阵分析预测结果。

另外Ubuntu中调用gpu是不是太发热了。——Windows把风扇攻略调大。注意:这里如果用pip安装的python-opencv最后也不行。yolov+TensorFlow搭建时遇到一些问题。根本就找不到TensorFlow的版本。

回归任务常用指标包括:MSE(平方误差均值,对大误差敏感)、MAE(绝对误差均值,抗异常值)、RMSE(MSE开方,单位一致)和R²(模型解释力)。分类任务主要指标有准确率、精确率(查准率)、召回率(查全率)和F1-Score(精确率与召回率的调和平均)。多分类任务中,每个类别可单独计算精确率和召回率,通过混淆矩阵分析预测结果。

PPO是一种策略梯度方法,简单的策略梯度对每个样本(或者一组样本)进行一次梯度更新,对单个样本执行多个梯度步骤会导致一些问题,因为梯度偏差太大,从而产生错误的策略。PPO允许我们在每个样本中进行多次梯度更新,方法是尽量使策略与用于采样的策略保持一致(所以看起来还是一种off-policy,只是用了某些方式让它on-policy了),如果更新后的策略与用于采样数据的策略不接近,则通过削减梯度流来实现