简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

他打开监控面板,查看日志,翻阅 Wiki,逐步排查——连接池耗尽、上游服务限流、数据库慢查询......两小时后终于定位:**Redis 集群发生了主从切换,客户端连接池未及时刷新**。

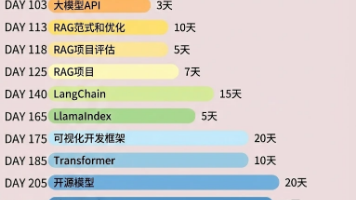

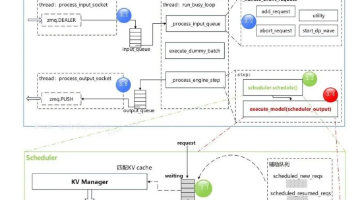

作为vLLM源码的开发者、框架的使用者,刚接触vLLM框架时会有这样的问题“如何快速地了解vLLM全貌?”。推荐的一个学习步骤:先大致了解整体运行流程,接着理解关键模块逻辑,然后学习关键特性。同时,逐步理解源码。

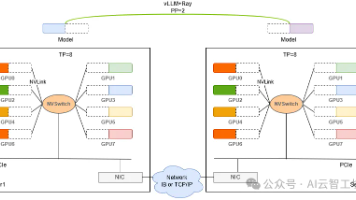

对于小模型,单机单卡或者单机多卡就能满足推理的部署需求,比如Qwen-32B,模型权重文件大概64G,单个H20的显存有96G,所以单卡就可满足。

去年6月份,我做了一个连自己都觉得疯狂的决定:裸辞,All in AI。

想快速上手 AI 应用开发?这个仓库收录了近 80+ 个精选项目,涵盖 RAG、AI Agents、多智能体协作等核心技术,从入门到实战,一网打尽。

多数人把AI用不好,不是因为不会写提示词,而是因为把底层概念混在一起用了。老王给一个反常识判断,决定你能不能把AI用成稳定生产力的关键,不是问出一句漂亮提问,而是能不能分清生成能力、记忆边界、事实可靠性、工程约束这四层逻辑。

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。(全套教程文末领取哈)

与(a)数据驱动的视觉指令微调相比,(b)视觉强化微调(Visual-RFT)在有限数据下更具数据效率。(c)成功地将RFT应用于一系列多模态任务,并在底部展示了模型的推理过程示例。

Goose 是由 Block 发布的开源、可扩展的「工程/企业向 AI agent 平台」,侧重把企业既有工具(通过 MCP 扩展)与本地执行能力结合,解决工具碎片化、隐私合规、多 agent 编排与工程效率提升等问题。该报告整合了源码架构要点、关键模块解读、能切中行业痛点的能力、产品定位、竞品对比与可执行落地建议。

随着生成式 AI 模型的快速演进,超长上下文窗口技术让“将整个图书馆塞进 Prompt”变成了现实。行业内随之出现了一种声音:当模型能够处理百万级甚至更多 Token 时,检索增强生成(RAG)是否已失去存在的意义?