简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

全面覆盖了治理管控、性能监控、云原生平台、能力开放平台、微服务架构等多个关键领域。通过精心设计的架构图,展示了如何整合ESB与API引擎构建统一SOA平台,实现微服务全生命周期管理,以及构建云原生技术平台。同时,还深入探讨了能力开放平台的功能域划分、遗留系统微服务化迁移策略、大数据平台架构设计,以及企业数字化转型的整体能力框架。这些架构图体现了技术层面的深度整合,支撑企业业务价值链的全面提升。

在 Transformer 模型中,自注意力机制的内存需求、计算量与序列长度成二次方关系,导致序列比较长时可能存在明显瓶颈。在 [2105.13120] Sequence Parallelism: Long Sequence Training from System Perspective 中,作者提出了序列并行(Sequence Parallelism),这是一种内存高效的并行方案,可以帮助突破

知识图谱是信息检索等应用中基本的数据结构,通过主谓宾三元组表示实体之间的关系。然而,许多现有的KG存在不完整性,缺乏实体之间的众多关系,这对下游任务如KG嵌入和基于图的推理造成了挑战。KGGen通过利用LLM从纯文本中提取主谓宾三元组,构建密集且全面的KG,从而缓解数据稀缺和不完整性的问题。

我们介绍过很多语音合成的模型,比如ChatTTS,微软语音合成大模型等,随着大模型的不断进步,其合成的声音基本跟真人没有多大的区别。本期介绍的是字节跳动自家发布的语音合成模型Seed-TTS。Seed-TTS 推理包含四个功能模块:(1) 语音标记器从参考语音中学习标记信息。(2)自回归语言模型根据条件文本和语音生成语音标记。(3) 扩散变换器模型以从粗到细的方式生成语音标记的连续语音表示。(4)

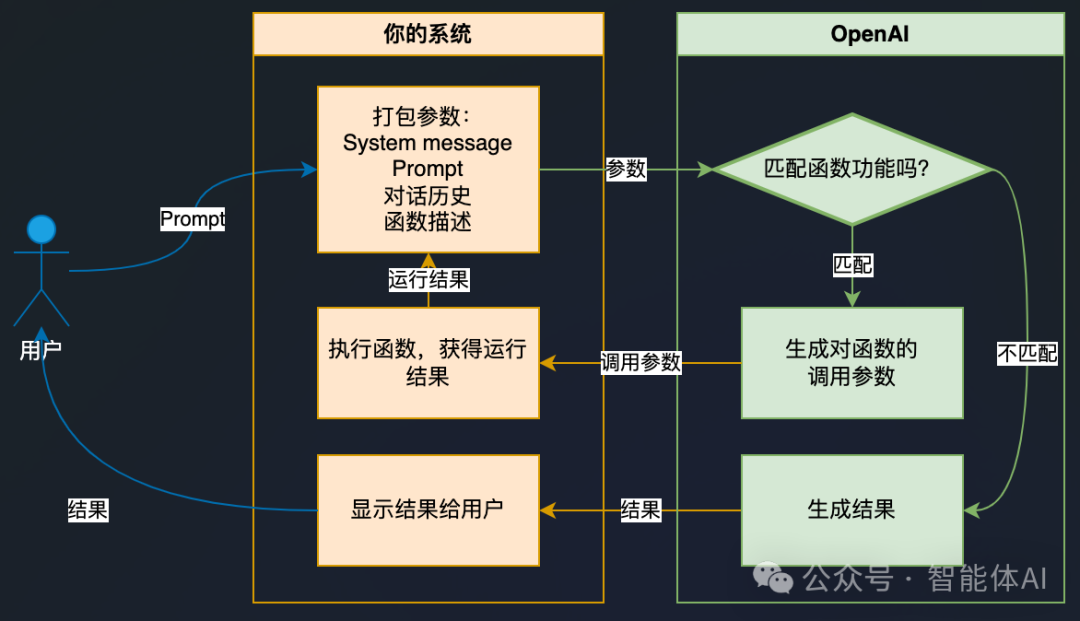

LLMs通过训练海量数据生成高级语言模型,从最初的GPT-3到如今的GPT-4,这些模型在理解和生成自然语言文本方面取得了显著进步,被广泛应用于自动化内容创作、聊天机器人、语言翻译等多个领域。Function Calling是一种使LLMs能够与外部系统、API或自定义函数进行交互的新兴技术。通过解析用户请求并自动选择和调用适当的外部功能,Function Calling实现了更复杂和动态的交互。

如果未对齐的多模态医学图像能够在一个统一的框架内通过单阶段方法同时对齐和融合,不仅可以实现双任务的相互促进,还能帮助减少模型的复杂性。然而,该模型的设计面临特征融合和对齐需求不兼容的挑战。为了解决这一挑战,作者提出了一种未对齐医学图像融合方法,称为双向逐步特征对齐与融合(BSFA-F)策略。为了减少模态差异对跨模态特征匹配的负面影响,作者将模态差异无特征表示(MDF-FR)方法融入BSFA-F中。

Transformer 模型的核心在于其自注意力机制和多头注意力机制,通过这些机制,模型能够有效地理解并处理序列数据中的复杂关系。虽然其公式和实现细节可能略显复杂,但 Transformer 提供了一种强大而灵活的框架来处理各种自然语言处理任务。

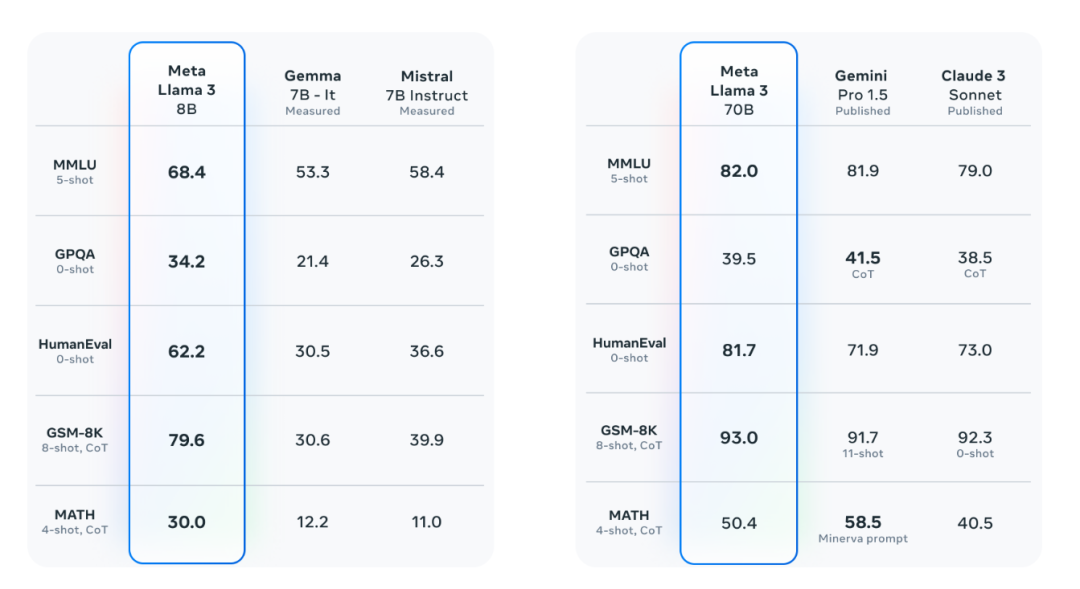

本文教你在本地电脑上使用LLama3+ComfyUI+OpenWebUI搭建一个多模态AI会话助理,轻松使用AI生成图象。

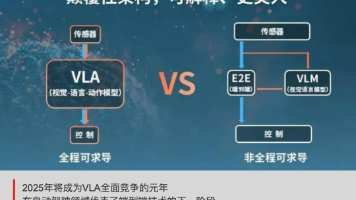

视觉-语言-动作模型(Vision-Language-Action,简称 **VLA**)**是一种将视觉感知、自然语言理解与动作控制统一到同一框架的人工智能模型,在自动驾驶领域代表了端到端技术的下一阶段。

随着多模态大语言模型(Multimodal Large Language Model, MLLM)的迅速发展,基于 MLLM 的多模态智能代理(agent)正在逐步应用于各种实际场景。这种技术的进步让利用多模态 agent 作为手机操作助手成为了现实,通过视觉感知和多模态交互,智能化地完成复杂任务。本文将为您解读一项最新研究——,该研究展示了如何借助多模态 agent 实现 AI 自动操作手机的技