简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

企业一谈AI转型,通常第一反应是:我们要不要上一个更强的大模型(LLM)?要不要换成最新的大模型?好像谁用的模型更大、更先进,谁就站在了时代的风口。但说句实在话,LLM 很重要,却不是企业智能化的核心竞争力。

政府机构是复杂的关系网络,传统数据库难以捕捉数据间的关联性。图技术通过显式建模实体关系,为AI提供必需的上下文,使其从概率性回答转向精准的、可追溯的决策支持。本文探讨图数据库如何成为智能代理系统的知识引擎,助力政府机构实现任务驱动的智能化转型 。

在知识图谱构建完成后,GraphRAG会使用社区检测算法(如Leiden算法等)来识别图谱中紧密相关的实体组(社区)。

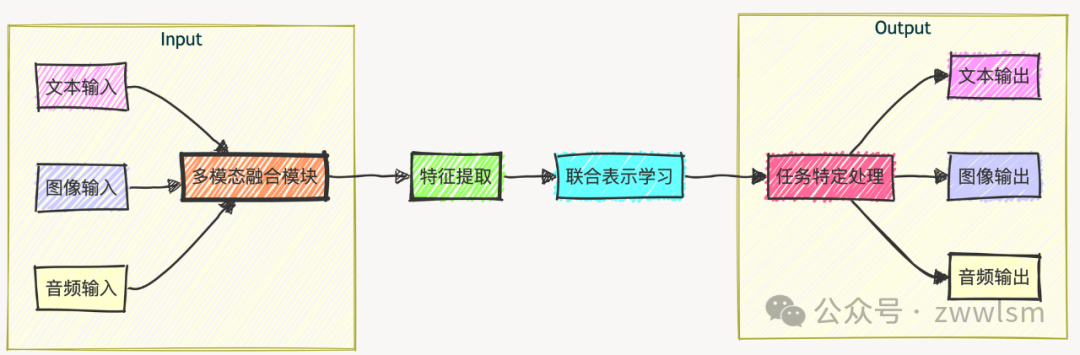

多模态提示技术为我们开启了一个令人兴奋的新领域,使AI能够更全面地理解和处理复杂的真实世界信息。通过本文介绍的技术和最佳实践,你应该能够开始构建强大的多模态AI应用。然而,多模态AI仍然面临着许多挑战,需要我们不断创新和改进。随着技术的进步,我们期待看到更多令人惊叹的多模态AI应用,这些应用将帮助我们更好地理解和交互with我们的复杂世界。

今天想和大家聊一篇来自伦敦帝国理工学院、Meta AI和NatWest AI Research的最新研究,这篇论文发表在NeurIPS 2025上。他们提出了一种名*MoME(Mixture of Matryoshka Experts)的新框架,巧妙地解决了大语言模型在音视频语音识别(AVSR)应用中的一个核心痛点:计算量大、效率低。

针对电商行业商品识别效率低、仓储分拣自动化不足、个性化推荐精准度差等痛点,京东云计算有限公司自研了众智标注平台与言犀、ViTAE大模型,并构建“标-训-推”一体化数据处理模式,覆盖商品内容生成、智能仓储、数据治理等核心场景。实现了电商全链路降本增效,累计节省内容审核成本超千万元,带动近百亿GMV(商品交易总额)增长。同步建成宿迁数据标注基地,形成百亿级数据产业集群,为行业提供“技术+产业+人才”三

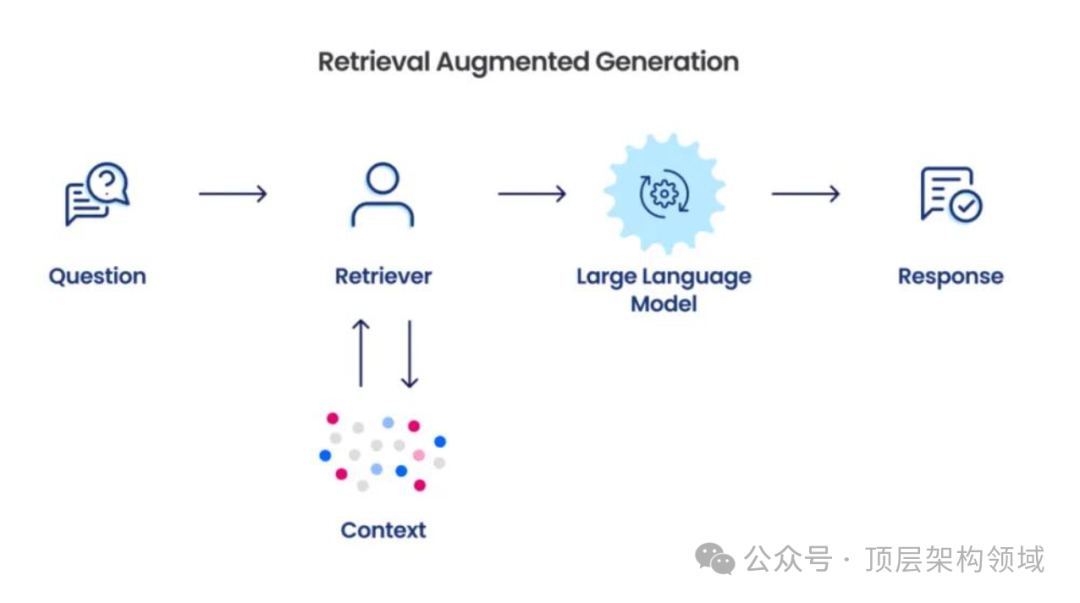

在AI知识检索领域,传统chunk+embedding(将分块后的文本片段映射到高维向量空间)的RAG方式已应用多年,但始终面临效率低、调优繁琐、资源消耗大等痛点,而Anthropic提出的Skill作为agent领域行业标准,正重构AI知识检索的逻辑。面对这一新型检索方式,我们不妨先思考几个核心问题,读懂Skill的真正价值——

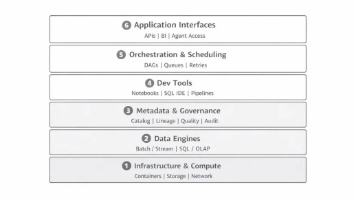

2024 年后,AI Agent 进入企业内的速度远超预期,带来两个新变化:一是使用方式变化——从传统工具调用变为任务驱动、自动拆解与多轮交互;二是平台需求变化——从能力组件堆叠转向对数据、计算、链路、权限、资源的综合编排。

本质上,目前的LLM只是一个无状态的函数。输入,计算,输出,结束。每一次交互,对它来说都是初见。

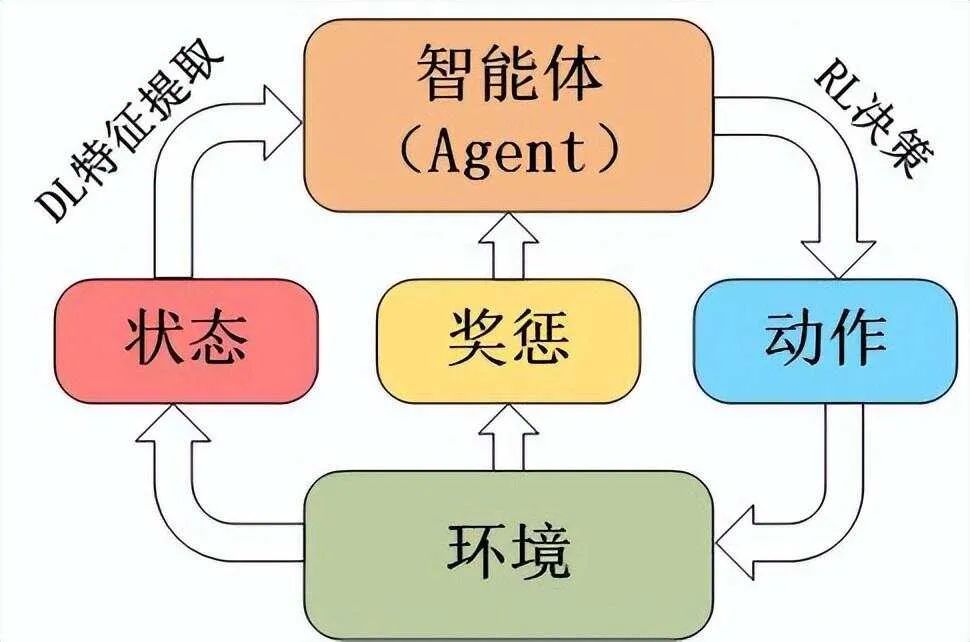

Q值函数,也称为动作价值函数(Action-Value Function),是一种特殊的价值函数,它估计了在给定状态下采取特定动作的预期回报。Q-Learning算法通过迭代更新Q值来逼近最优Q函数。算法流程包括初始化Q表、选择动作、执行动作、更新Q值等步骤。