简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

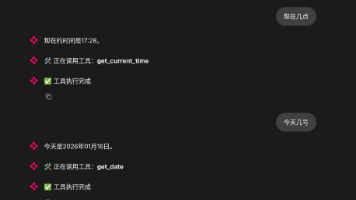

随着大模型能力的提升,单纯的对话已经无法满足实际工程需求。越来越多的场景需要模型具备调用外部工具、访问系统能力、执行复杂任务的能力。提供了一种统一、标准化的方式,让模型可以通过协议调用外部工具;LangGraph则用于构建可控、可追踪的 Agent 推理流程;Chainlit提供了一个轻量但功能完整的 Web Chat UI,非常适合 Agent 场景。支持 MCP 多工具调用支持 Ollama

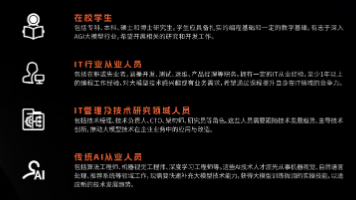

先说我的经历,传统后端开发入职阿里,工作一年后转大模型应用层。两年Agent、RAG经验,拿到字节超30%涨幅Agent开发岗位offer。**第一阶段:**了解LLM能干啥,当API使用,Agent探索,这阶段提示词怎么写很值得学习,吴恩达的课程讲的很好推荐去学。**第二阶段:**了解LLM模型大致原理,Transformer模型基本原理,注意力机制,SFT,模型微调,Pytorch这种框架使用

这篇文章介绍了小傅哥耗时7个月开发的基于Spring AI框架的AI Agent智能体项目,包含38节课程(视频+文档),涵盖前后端+DevOps技术栈。项目从RAG到MCP,实现了企业级可编排的AI Agent智能体,提供可视化链路编排、多种执行设计模式、RAG和MCP开发能力等技术点。适合希望提升AI应用能力、增强核心竞争力的开发者,项目已部署上线并提供完整源码。❝沉淀、分享、成长,让自己和他

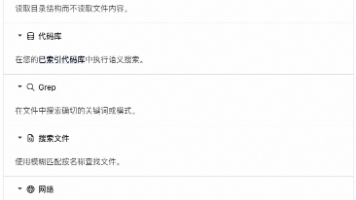

文章系统介绍了AI编程工具(如Cursor、Claude Code)的底层机制,包括Token计算、工具调用、代码库索引与Merkle Tree等技术,并提供了提升对话质量的方法和实际应用场景。文章还分享了结合AI的编码最佳实践,包括规则设置、渐进式开发、文档规范和安全合规,旨在帮助不同经验水平的开发者真正掌握AI编程工具,提升开发效率。本文从原理到实践系统地分享了如何高效使用AI编程工具。

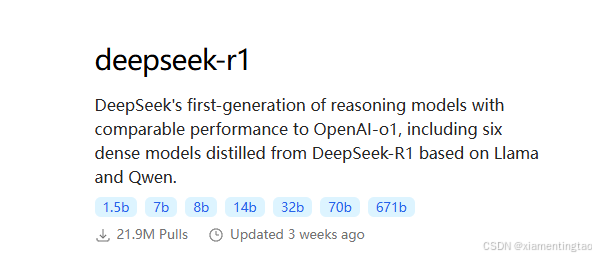

今天尝试在pycharm上接入了本地部署的deepseek,实现了AI编程,体验还是很棒的。下面详细叙述整个安装过程。本次搭建的框架组合是一般情况下,我们选择安装deepseek-r1:1.5b或者7b,可以支持我们普通配置(消费级显卡或者无显卡)的电脑、笔记本,适合个人开发者或者边缘计算设备。接下来,我们具体开始安装本地版deepseek.1. 安装pycharm:可以装专业版(Professi

前端有模板,后端用框架,算法靠开源,业务代码用AI……2025年的程序开发,卡点已经不是懂不懂,而是知不知道。”个人开发者赵泽明近日在朋友圈感慨。赵泽明是信息挖掘工具wiseflow的主要作者,这一开源项目在Github收获了超过6600个星,他对第一财经表示,项目大概有60%的代码都是用AI写的。**“多看五年,程序员或许就跟当年的打字员一样,从独立工种变为通用技能了,”**但他补充称,这绝对不

如今,随着大语言模型技术的飞速发展,AI Agent已经从实验室走向了企业的生产环境。特别是谷歌在2025年9月15日最新发布的这份《Startup Technical Guide: AI Agents》白皮书,为整个行业提供了一份极具价值的技术路线图。这份指南的核心论点是:构建真正有价值的AI Agent,早已超越了模型选型和提示词工程的范畴,它是一门新兴的、跨领域的工程学科。

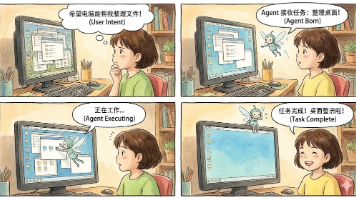

什么是GUI Agent?简单来说,就是一个能够"看懂"屏幕(mobile/pc/web)并进行自动操作的AI Agent。比如用户发送指令“整理文件”,PC GUI Agent就可以基于纯GUI界面理解页面内容,进行逐步决策&操作,直到完成用户任务。随着GUI Agent的应用前景逐渐明朗,GUI Agent在25年的发展很迅猛,其中一个比较明显的新趋势是,通用大模型也在训练GUI上的能力:因此

近年来,随着计算能力的增强和数据量的爆炸式增长,大模型进入了快速发展的新阶段,展现出强大的语言理解和生成能力。同时,大模型的应用也带来了数据、计算和伦理等挑战,要求我们在享受技术进步带来的便利的同时,也要关注其可能带来的风险和影响。其次,大模型推动了数据预处理和模型训练技术的创新,使得模型在复杂任务上的表现显著增强。大模型在图像识别、目标检测、图像分割等方面展现出卓越的性能,如用于自动驾驶的车辆识

通用大模型技术快速发展,但很多传统行业推进得并不快。对企业而言,大模型应用需要综合考虑专业性、数据安全、持续迭代和综合成本等多种因素。针对这些现实情况,腾讯集团提出重点发展行业大模型的理念。本文基于一线大量实践反馈,做出系统归纳总结,呈现行业大模型发展真实情况,厘清关键争议和困惑问题。真正解决用户需求、距离场景和数据更近的企业,将拥有大模型的未来。