简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文主要是介绍了语音中最常见的数据集(包含各个语种),及其格式等。

源码用的是 :ultralytics_yolov5-master第一步源码可以运行。第二步:将detect.py中parse_opt中读取照片改为读取本地摄像机。这个位置改为修改后再运行detect.py就会出现这样:我看别的博主有修改datasets.py,新版本的不用,读取摄像头的程序,文件中都有写好。......

在多模态任务中,有一种方法时在单模态中先各自提取各模态的特征,然后进行融合,本文主要实现各模态特征的提取。

在多模态任务中,有一种方法时在单模态中先各自提取各模态的特征,然后进行融合,本文主要实现各模态特征的提取。

本文主要是介绍了语音中最常见的数据集(包含各个语种),及其格式等。

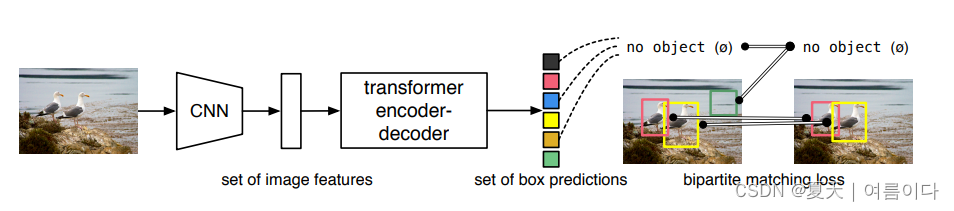

我们提出了一种将对象检测视为直接集合预测问题的新方法。我们的方法简化了检测方式,有效地消除了对许多手工设计的组件的需求,例如非最大抑制过程或锚点生成,这些组件明确地编码了我们关于任务的先前知识。新框架的主要成分称为DEtection TRansformer或DETR,是基于集合的全局损耗,通过二分匹配强制进行独特的预测,以及transformer编码器 - 解码器架构。给定一组固定的学习对象查询,

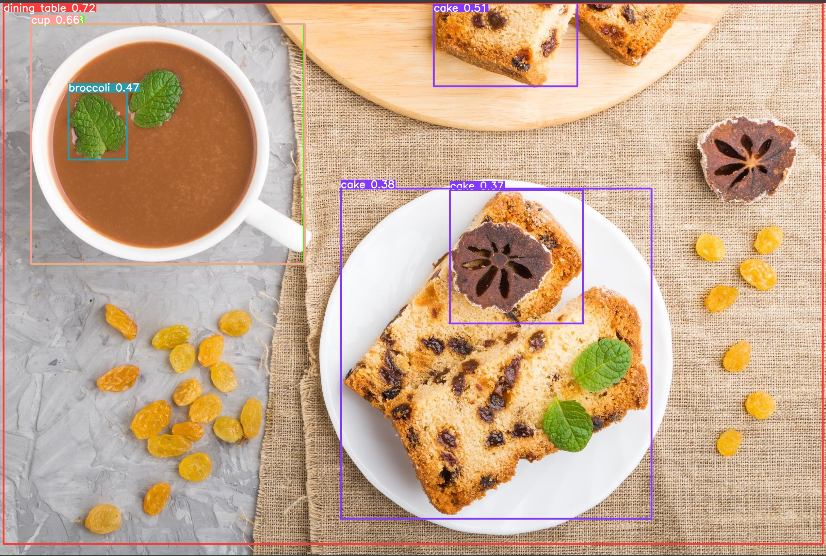

YOLOv8是Ultralytics最新的基于YOLO的目标检测模型系列,提供最先进的性能。

arXiv【1】(X依希腊文的χ发音,读音如英语的archive)是一个收集物理学、数学、计算机科学、生物学与数理经济学的论文预印本的网站,始于1991年8月14日。截至2008年10月,arXiv.org已收集超过50万篇预印本;至2014年底,藏量达到1百万篇。截至2016年10月,提交率已达每月超过10,000篇。在arXiv上发表,并没有专业的审稿人,所以也不是学术性期刊,相当于占位。因为

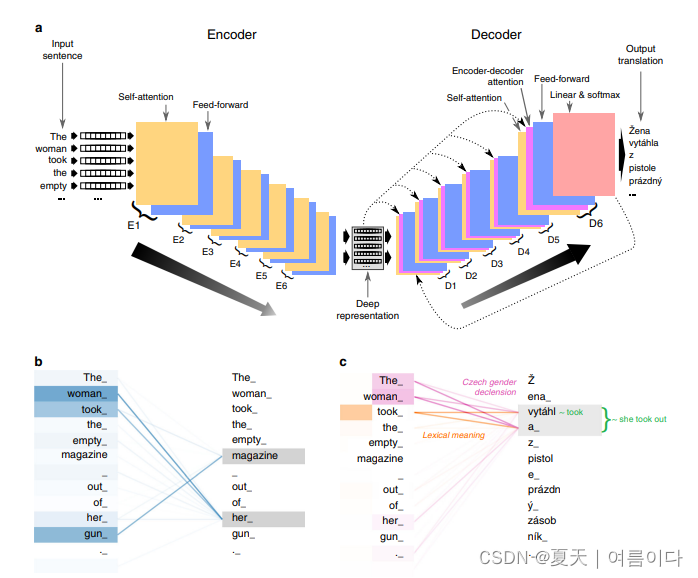

长期以来,人们一直认为人类翻译的质量对于计算机翻译系统来说是无法实现的。在这项研究中,我们提出了一个深度学习系统CUBBITT,它挑战了这一观点。在人类法官的上下文感知盲测评估中,CUBBITT在保留文本含义(翻译充分性)方面显着优于专业机构的英语到捷克语新闻翻译。虽然人工翻译仍然被评为更流畅,但CUBBIT被证明比以前最先进的系统更流畅。此外,翻译图灵测试的大多数参与者都很难将CUBBITT翻译

源码用的是 :ultralytics_yolov5-master第一步源码可以运行。第二步:将detect.py中parse_opt中读取照片改为读取本地摄像机。这个位置改为修改后再运行detect.py就会出现这样:我看别的博主有修改datasets.py,新版本的不用,读取摄像头的程序,文件中都有写好。......