简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

循环神经网络(RNN)是一种专为处理序列数据设计的神经网络。与传统神经网络不同,RNN的节点之间形成了环形连接,使得网络能够保持对先前信息的记忆。这种设计让RNN在每个时间步都能考虑到之前时间步的信息,从而实现对序列数据的有效处理。

将在本节深入探索机器学习的根本原理,包括基本概念、分类及如何通过构建预测模型来应用这些理论。

在我们的日常生活中,人工智能已经成为一种无处不在的力量,从智能家居到在线助手,再到高度个性化的服务和推荐,它无声地改变着我们的生活方式和习惯。随着技术的不断进步和普及,人工智能正以前所未有的速度和规模渗透到我们生活的每一个角落,开启了一个全新的智能时代。

近年来,大模型(Large Language Models,LLMs)在人工智能领域迅猛发展,从GPT-3到GPT-4、Claude、Gemini、文心一言、GLM等模型相继发布,大模型已逐渐走出实验室,迈向产业落地。本文将从技术原理、模型架构、训练技巧、推理优化到实际应用进行系统剖析,帮助读者深入掌握大模型相关知识,全面提升AI实战能力。

当我们回望这场大模型浪潮,会发现它既是一场技术革命,也是一场认知误导。我们看到了语言的奇迹,却忽略了理解的幻觉;我们沉醉于AI的流畅表达,却忘记它仍是一台概率机器。真正的危险,不在于AI有多聪明,而在于我们有多愿意相信它聪明。

同样的模型、不一样的答案,差距往往发生在一行 Prompt 里。本文围绕五大高频实战场景,给出可直接复制的 DeepSeek 提问框架,并穿插《DeepSeek 行业应用大全》中 66 个行业模板精华,帮助读者迅速跑赢 ChatGPT。🌟

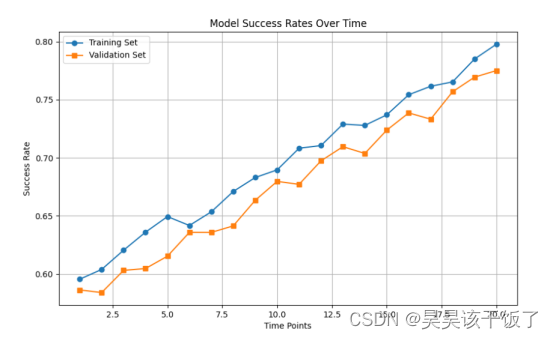

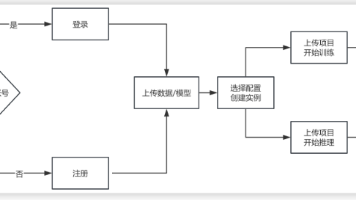

在自然语言处理(NLP)领域,文本生成任务广泛应用于问答系统、智能摘要、内容创作等方向。本文将带领读者使用GpuGeek平台,从注册、上传数据到实例部署与训练,完整构建一个基于GPT2模型的文本生成系统,实战掌握AI模型的云端开发流程。

随着大语言模型(LLM)在自然语言处理各领域取得突破性进展,越来越多开发者和企业开始关注模型的微调方式。然而,全参数微调不仅成本高昂、资源要求极高,还容易引发过拟合与知识遗忘等问题。为此,LoRA、QLoRA、PEFT 等轻量级微调技术迅速崛起,成为大模型落地实践的热门选择。

DeepSeek 作为定位「国民级 AI」的大语言模型,正试图让中文人工智能能力触手可及。很多读者第一次打开网页却卡在注册、提示词或插件配置细节。本篇将以全流程拆解方式,帮助大家十分钟上手并完成首轮高质量对话,为后续深度应用打下基础。文末有重磅推荐!!!

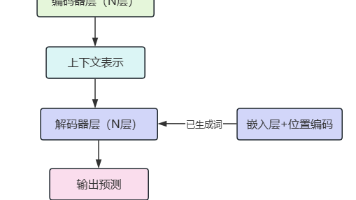

Transformer是现代深度学习的核心架构之一,广泛应用于自然语言处理、计算机视觉等领域。本文将从Attention原理讲起,逐步拆解Transformer架构,结合BERT、GPT等主流模型,通过实战示例讲透大模型训练的完整流程。