简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

最近几年,大模型在技术领域的火热程度属于一骑绝尘遥遥领先,它已经深刻地影响了“编程”领域,且正在各个领域迅速渗透。与此同时,普通开发者也变得非常地焦虑,因为实实在在感受到了它强大的威力,担心哪天自己就被取代。与其担忧,我们不如主动拥抱这种技术变革。

最近 AI 实在是太火了🔥,不是以前那种火在互联网上,而是火到互联网公司里头。之前是铺在 AI 算法上,现在是扎进 AI 应用里。一天天我们都下班了,`AI Agent 应用项目组的小伙伴还在加班`!🤨

有人发帖分享自己找工作过程中对市场的感知,并立即调整求职策略,从Java后端开发岗转投AI应用开发岗。

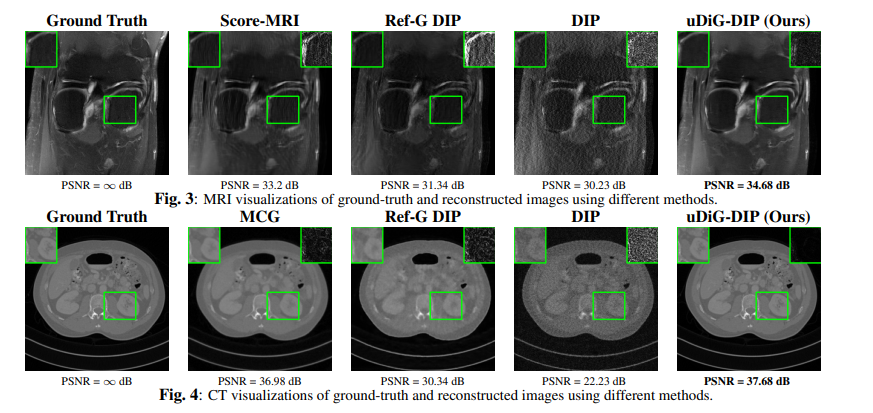

今天,我想向大家介绍一个在医学图像处理领域极具潜力的研究方向——这个领域因其在多个应用科学与人工智能的交叉点上的重要性而备受关注,尤其是在医学图像分析中。技术通过整合不同类型的图像数据,能够克服单一成像技术的不足,为我们提供更全面和精确的医学信息,从而显著提升诊断的准确性和治疗的效率。在这个领域中,有许多细分的研究领域值得关注,包括但不限于的分割、分类、合成、融合以及特征提取等。为了方便大家寻找研

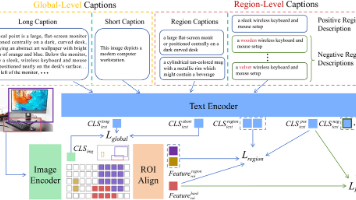

对比语言图像预训练模型 (CLIP) 在图像文本检索和零样本分类等多模态任务中表现出色,但由于其侧重于粗粒度的简短标题,在细粒度理解方面存在不足。 为了解决这个问题,我们提出了细粒度 CLIP (FG-CLIP),它通过三个关键创新增强了细粒度理解能力。 首先,我们利用大型多模态模型生成 16 亿对长标题图像对,以捕捉全局语义细节。 其次,我们构建了一个高质量的数据集,包含 1200 万张图像和

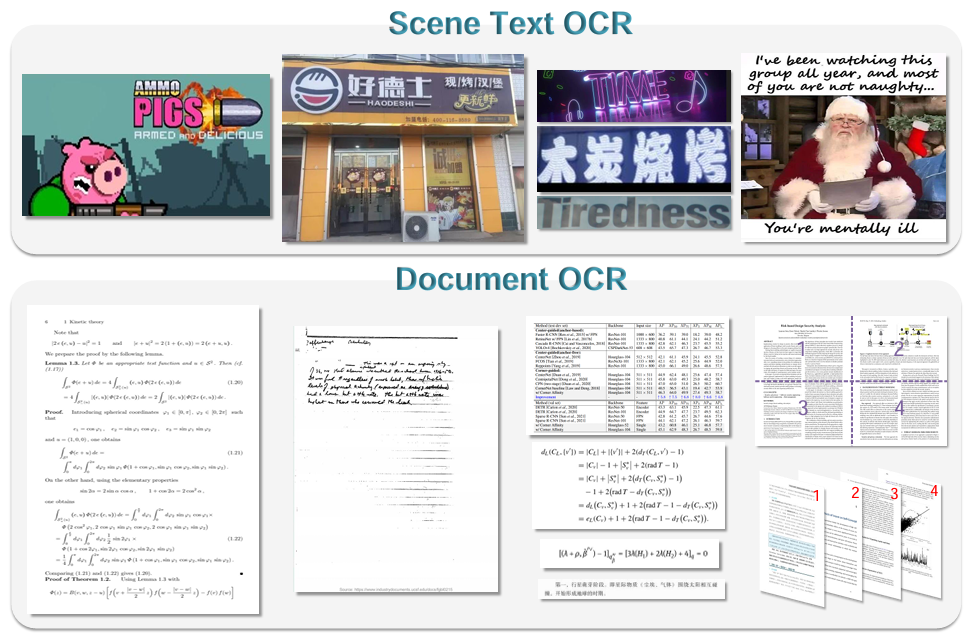

学字符识别 (OCR) 广泛用于从图像中提取数据。传统的 OCR 模块化架构面对更智能的数字化需求暴露了众多局限性,例如。大型视觉语言模型 (LVLM) 具备了卓越的文本识别能力,针对 OCR 特定功能进行优化,提升诸如高密度文本或特殊字符的识别成为可能。籍此,来自阶跃星辰、旷视科技、中科院大学和清华的研究人员提出 GOT (General OCR Theory) 的新型 通用OCR模型。

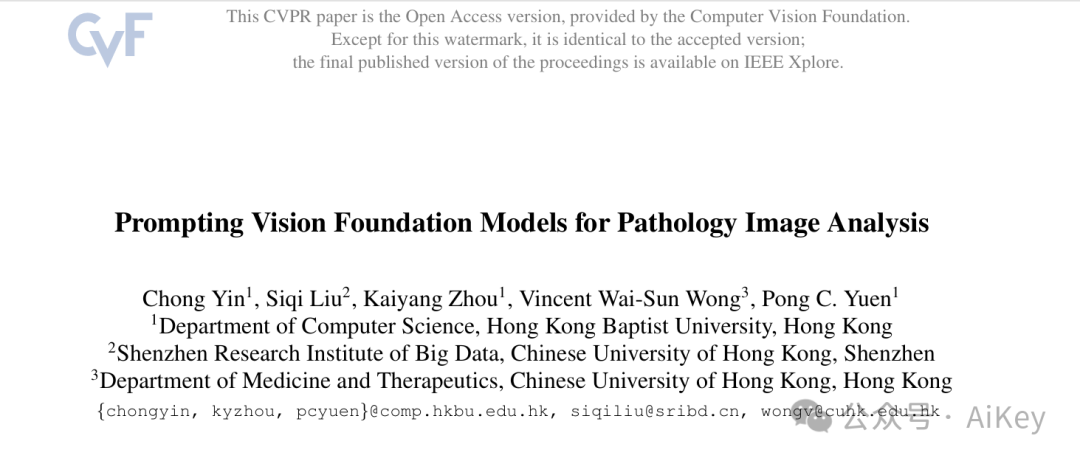

论文提出了一种新的方法,Quantitative Attribute-based Prompting (QAP),用于肝脏病理图像分析。QAP基于两种定量属性:K-function-based空间属性和直方图形态学属性,旨在对组织状态进行定量评估。通过条件性提示生成器将这些实例特定的属性转化为视觉提示。在三个不同的任务上进行的广泛实验表明,该任务特定的提示方法在诊断性能和可解释性方面都取得了更好的

大型视频语言模型(LVLM)的最新进展推动了旨在评估基于视频任务的认知能力的基准的发展。然而,大多数现有的基准严重依赖于网络收集的视频与人类注释或模型生成的问题,这限制了对视频内容的控制,并且在评估涉及符号元素和抽象概念的高级认知能力方面存在不足。为了解决这些限制,我们引入VCBench,一个可控的基准来评估LVLM的认知能力,涉及不同难度水平的符号和抽象概念。通过使用基于Python的引擎生成视

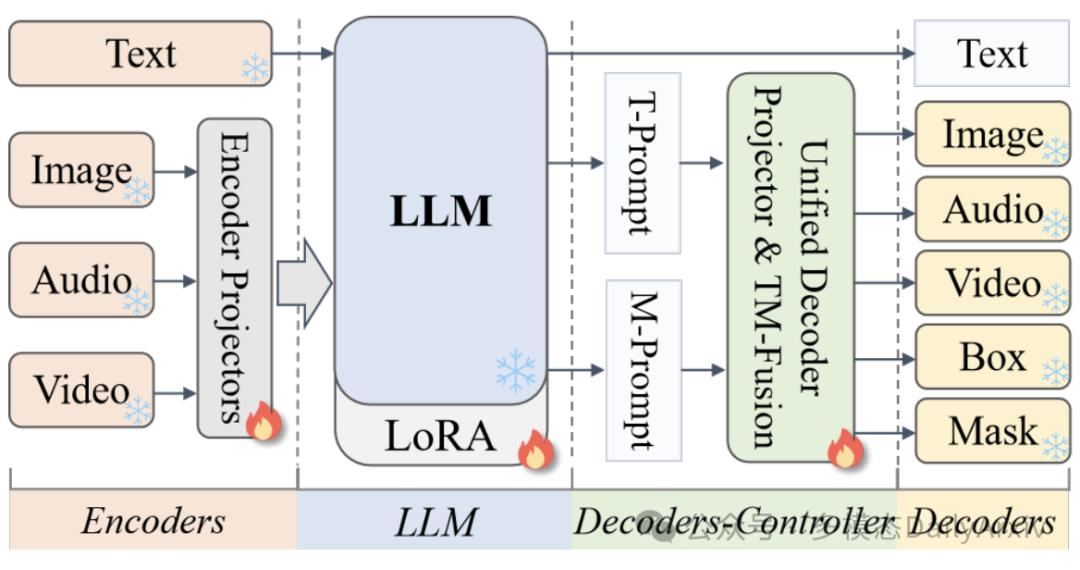

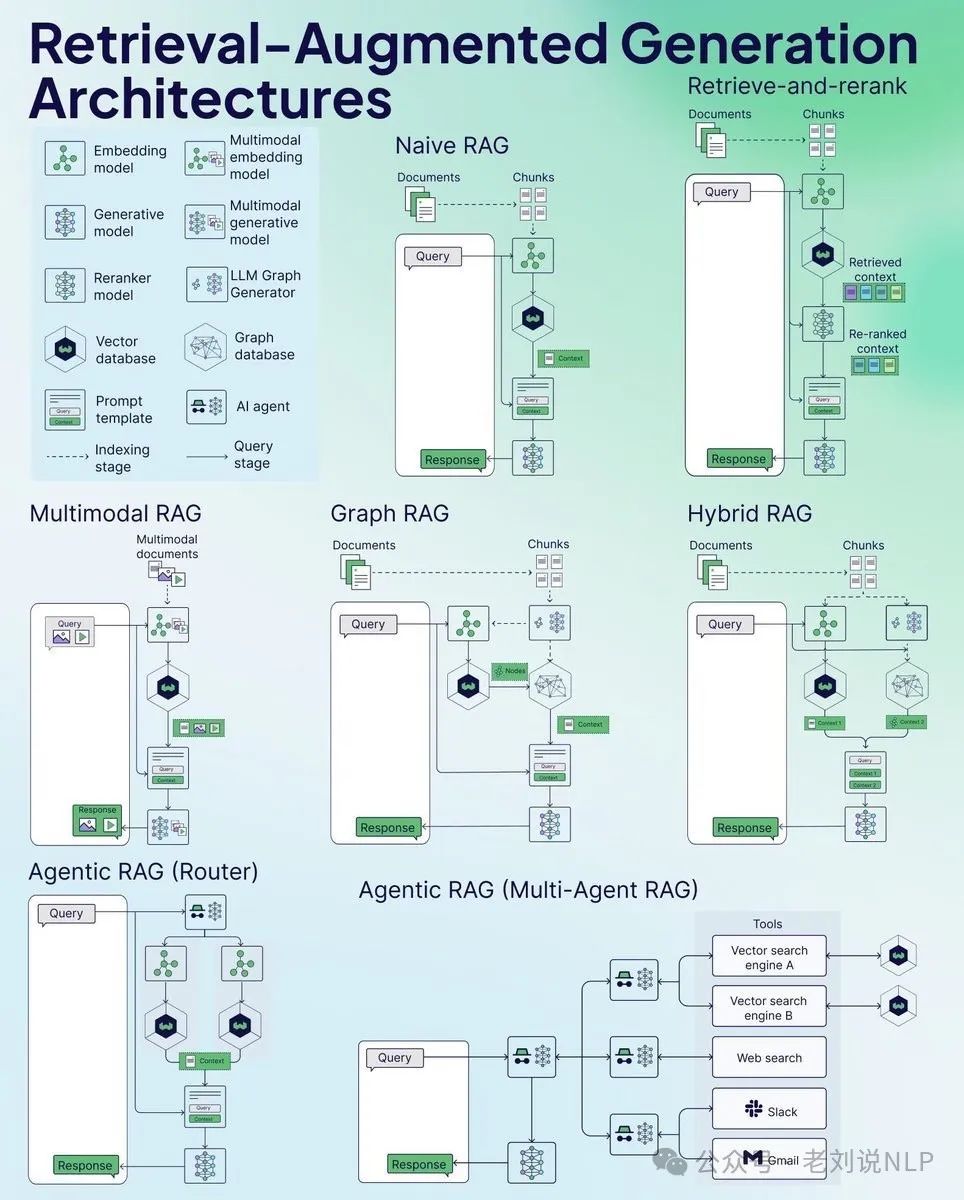

今天,我们继续来总结RAG,看4张图,一个是RAG的三张图:从模式、痛点到最佳实践。一个是再回首大模型时代工程开发相关工具,这些比看理论要好得多;

(abstraction),前者指的是减少视觉令牌数量,后者则指的是对视觉语义概念的抽取(如属性、实体等)。在转入作者分析阶段之前,我们直接给出作者在本文的结论:观察1:底座LLM本身可以从原始视觉特征中进行有效的语义提取。观察2:压缩型的连接器从视觉块中提取的视觉语义信息会存在折损。结论:Q-Former这种同时进行压缩和摘要的连接器,由于本身已经进行了有损的压缩和摘要,而底座LLM又会进行进一