简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

最近爆火的国产AI大模型Deepseek详细大家都不陌生,不过除了在手机上安装APP或者官网在线体验,我们其实完全可以在自己的Windows电脑上本地进行部署,并结合cpolar内网穿透工具轻松实现远程交互,带来更方便快捷的体验。之前就和大家分享过本地运行 AI 模型具有很多优势,比如隐私安全:你的所有数据都保留在你自己的机器上,不存在共享敏感信息的风险。快速响应:官方及三方访问量过大,延迟非常高

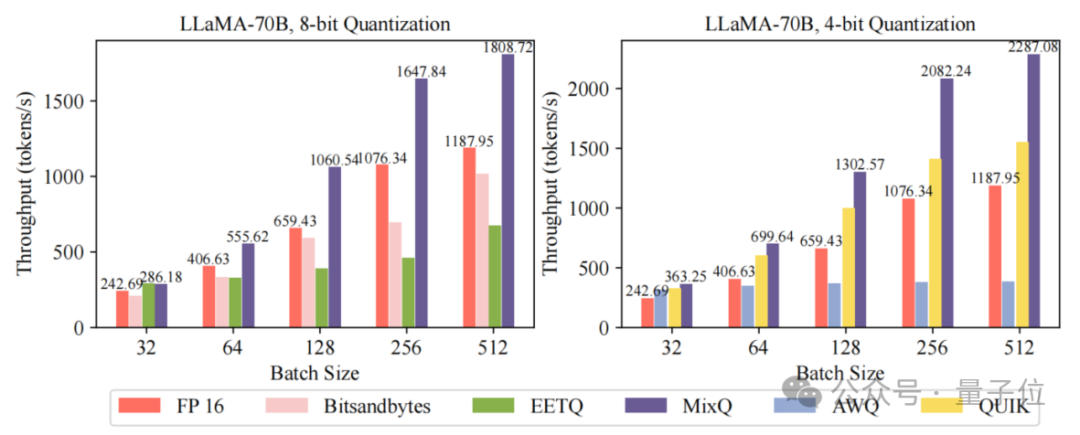

量化的主要技术路线有两条,第一条是权重量化。权重量化的理论加速比是16/量化的比特数。例如,将模型压缩成为4bit,那么理论加速比为16/4=4倍。然而,当服务商面临大量的用户同时访问时,权重量化的系统吞吐会低于FP16的吞吐,其主要原因是权重量化计算过程中将低精度权重恢复成FP16然后计算,这导致权重量化并不使用低精度算力,当场景表现为compute bound的时候,性能较低。△。

支持结构化精准提取复杂PDF文件内容!完美识别中英文文档、模糊扫描件与复杂表格!本地部署与实际测试全过程!医疗法律行业必备!轻松应对企业级PDF批量转换需求!

在数字化转型的浪潮下,企业内部的信息管理面临着很大的挑战。传统的信息管理系统往往存在数据分散、检索效率低下、缺乏智-能化支持等问题。尤其是在面对海量非结构化数据时,企业难以快速提取有价值的信息,导致决策效率低下。有没有一款软件能够处理这些痛点?今天我们将为大家介绍一款开源工具——Dify,它能够通过整合先进的AI技术和本地知识库管理能力,帮助企业实现高-效的内部信息管理。Dify是一个开源的 LL

人工智能技术已经深入到社会的各个角落,极大地改变了普通老百姓的生活。在医疗领域,人工智能医疗器械将在未来扮演重要角色,成为一个重要的产业增长点。临床研究阶段作为关键枢纽,将在人工智能医疗器械的发展中发挥至关重要的作用。医疗器械是指用于人体的仪器、设备、器具、材料或其他物品,无论单独使用还是组合使用,包括所需要的附件和配件,其目的是用于疾病的诊断、预防、监护、治疗或缓解,或用于损伤的诊断、监护、治

Deepseek 在企业各个系统中的应用,全方位提升了企业的运营效率。它为企业决策提供海量数据支持,让决策更加科学精准;通过智能化客户关系管理,提高了客户满意度和忠诚度;优化供应链管理,实现了供应链的协同高效运作;在产品创新方面,借助数据分析助力企业开发出更具竞争力的产品;同时,还能实时监测风险,增强企业的风险管理能力,使企业在市场竞争中脱颖而出。不过,AI 大模型在企业应用中也面临一些挑战。数据

如果将人工智能按照用途进行简单分类的话,AI其实要被划分为两类:决策式AI和生成式AI。判别式AI:专注于分析情况并做出决策。它通过评估多种选项和可能的结果,帮助用户或系统选择最佳的行动方案。例如,在自动驾驶车辆中,就是通过决策式AI系统决定何时加速、减速或变换车道。生成式AI:专注于创造全新内容。它可以根据学习到的数据自动生成文本、图像、音乐等内容。例如,你可以将几篇论文发给生成式AI,他可以生

雅意信息抽取大模型:基于百万级人工构造的高质量信息抽取数据,进行指令微调,由中科闻歌算法团队研发的统一信息抽取模型,支持多领域和多语言的结构化信息抽取。

什么是知识蒸馏知识蒸馏(Knowledge Distillation)本质上是一场深度学习的""革命。在真实的业务场景中,我们常常面临这样的矛盾:一个在超算集群上训练出的千亿参数BERT模型虽然准确率惊人,但根本无法部署在边缘设备的128MB内存中;或者一个基于ResNet-152的图像识别系统虽然效果卓越,但10秒/张的推理速度完全不符合产线质检的实时性要求。这时候,。这项技术的核心在于。

大模型的本质,是一种能够处理特定类型任务的数学模型**”**现在大模型可以说是人工智能的代表,但目前的大模型还只是一种基于数学逼近算法的概率统计模型。因此,其需要大量的训练数据来让模型学习,找到其中的规律,然后就有了大模型。因此,也间接说明了训练数据的重要性。那么应该怎么收集训练数据呢?