简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

特性BPEWordPieceUnigram合并策略字符频率语言模型提升概率剪枝拆分唯一性✅ 是✅ 是❌ 否多语言支持中等较弱✅ 强实现复杂度简单中等较复杂常见应用模型GPT/QwenBERTT5/mT5/UL2BPE、WordPiece 和 Unigram 是构建高效、泛化性强的 tokenizer 的三种主流方法。它们在子词构建逻辑、鲁棒性、语言兼容性方面各有优势。在实际使用中,我们应结合模型类

方向表现数学与逻辑推理显著优于多数开源模型多语言支持支持 55 种语言代码与 Agent 能力在 LiveCodeBench、BFCL 上领先可控性与可解释性强化学习 + 规则奖励机制提升输出质量数据质量与多样性提升更优模型架构设计(如压缩、长上下文扩展)强化学习系统升级(特别是 Agent-based 学习)开放更多模型权重供社区研究使用(Apache 2.0 协议)📌。

本文系统解析了大语言模型微调中的四种强化学习算法:PPO、DPO、KTO和ORPO。PPO通过约束策略更新实现稳定优化,DPO直接利用人类偏好数据避免奖励建模,KTO在DPO基础上加入KL正则项,ORPO则专注于离线数据训练。文章详细介绍了各算法的原理、数据格式、数学公式和简化实现,并对比了它们的适用场景和特点。这些方法为LLM优化提供了不同路径,从传统的在线策略优化到更高效的离线偏好学习,帮助开

本文系统解析了大语言模型微调中的四种强化学习算法:PPO、DPO、KTO和ORPO。PPO通过约束策略更新实现稳定优化,DPO直接利用人类偏好数据避免奖励建模,KTO在DPO基础上加入KL正则项,ORPO则专注于离线数据训练。文章详细介绍了各算法的原理、数据格式、数学公式和简化实现,并对比了它们的适用场景和特点。这些方法为LLM优化提供了不同路径,从传统的在线策略优化到更高效的离线偏好学习,帮助开

YOLOX是旷视科技2021年提出的高性能单阶段目标检测模型,在YOLO系列基础上进行了多项创新:采用Anchor-Free模式、解耦头设计、SimOTA标签分配策略,并支持ONNX/TensorRT导出。其核心结构包括CSPDarknet53主干网络、PANet特征融合和解耦检测头。YOLOX通过SimOTA动态分配正样本,使用GIoU+L1损失优化边界框回归,结合Mosaic等数据增强技术,在

YOLOv4训练与推理流程详解:本文基于论文和开源实现,详细介绍了YOLOv4目标检测模型的完整工作流程。训练阶段包括数据预处理(Mosaic增强)、锚框分配、标签构建和CIoU损失计算;推理阶段涵盖图像预处理、多尺度预测输出和解码边界框过程。通过构造一个小型2类数据集(person和car),展示了YOLOv4从输入到输出的实现细节,包括特征图层级划分(20×20、40×40、80×80)和损失

vLLM是加州大学伯克利分校开发的高性能大语言模型推理框架,通过创新的PagedAttention技术(类比操作系统内存分页机制)显著提升推理效率。它解决了传统框架显存占用高、批处理效率低等问题,支持LLaMA、Mistral等主流开源模型,吞吐量比Transformers提升2.6倍,显存降低32%。vLLM兼容HuggingFace API,适用于本地推理、实时问答系统等场景,但不支持闭源模型

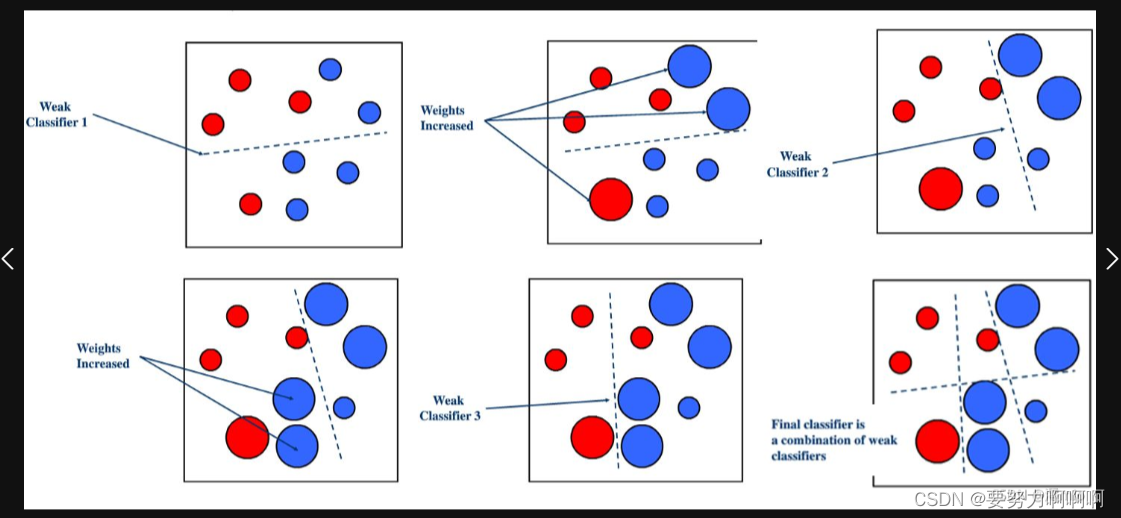

集成学习详细总结(不涉及数学理论部分)

本文系统解析了大语言模型微调中的四种强化学习算法:PPO、DPO、KTO和ORPO。PPO通过约束策略更新实现稳定优化,DPO直接利用人类偏好数据避免奖励建模,KTO在DPO基础上加入KL正则项,ORPO则专注于离线数据训练。文章详细介绍了各算法的原理、数据格式、数学公式和简化实现,并对比了它们的适用场景和特点。这些方法为LLM优化提供了不同路径,从传统的在线策略优化到更高效的离线偏好学习,帮助开