简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

更深层的问题在于,AI技术的落地不仅仅是技术问题,更是数字化基础设施的系统性挑战。数据孤岛严重:业务数据散落在Oracle、SAP、Excel、纸质文档等多个系统中,没有统一的数据治理体系API标准缺失:各业务系统间缺乏标准化的API接口,AI无法与现有系统打通安全合规约束:金融、医疗等行业对数据安全、模型可解释性有严格要求,很多"黑盒"AI方案无法通过合规审查组织变革阻力:AI自动化可能冲击现有

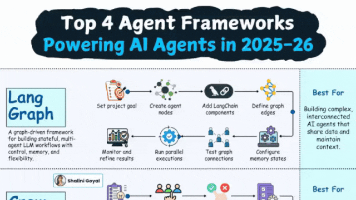

框架核心定位最适合人群/场景核心优势LangGraph状态图驱动的多Agent核心开发复杂互联、有状态的Agent系统的开发者控制精准、生态完善、稳定性高CrewAI角色化团队协作框架内容创作者、企业团队、低代码开发人员易用性高、企业级部署能力强AutoGen通信优先的对话式框架开发交互式AI助手、研究型Agent的开发者对话推理强、跨语言、工具丰富MetaGPT模拟创业团队的开发框架软件开发、原

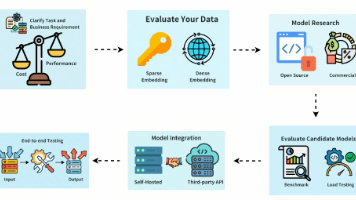

对于刚接触大模型的小白程序员,或是需要落地RAG、推荐系统的开发者来说,Embedding(嵌入)模型绝对是绕不开的核心技术——它通过将文本、图像等原始输入,转化为固定维度的高维向量来捕捉深层语义信息,不仅是构建RAG检索增强生成系统的核心支撑,在推荐系统、自动驾驶模型训练、语义匹配等场景中,也发挥着不可替代的作用。近年来,全球科技巨头纷纷加码Embedding模型研发,赛道竞争愈发激烈。Open

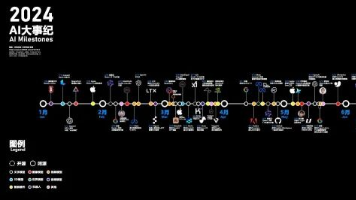

2024年已然落幕,于我而言,这不仅是打工路上的第三个年头,更是本命年里破局成长、实现赛道跃迁的关键一年。这一年,我先后切换了候选人与面试官的双重身份,有幸以大厂面试官的视角,窥见职场人才选拔的核心逻辑;也收获了学业与事业的双重突破——顺利发表小论文与专利,毕业论文中期答辩斩获优秀,更在2024年末成功转型,成为一名大模型算法工程师。大模型的浪潮,彻底改写了我的职场轨迹与生活节奏,也让我深刻意识到

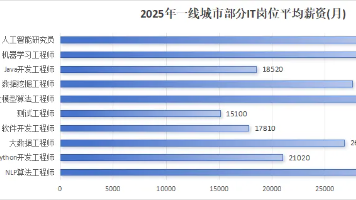

很多小白、程序员都问我:“现在转大模型,是不是更容易就业?能避开35岁焦虑吗?答案是肯定的,但有前提。大模型作为新兴技术,目前人才缺口确实很大,尤其是既懂技术、又懂业务的复合型人才,不管是大厂还是中小厂,都愿意开出高薪争抢。但想在这个风口站稳脚跟,不是靠“跟风”“速成”就行,你需要做好这3件事:先根据自身背景选对方向(小白优先数据方向,程序员优先平台/部署方向),避开“重模型轻问题”“追热点轻底层

大模型入门没有“门槛”,但需要“耐心”和“实操”。零基础小白无需害怕,按照“明确方向→夯实基础→核心技术→实战落地→职业规划”的路径,一步一个脚印,3-6个月就能实现从“新手”到“能落地项目”的突破;程序员可借助自身优势,快速进阶,拓展职业边界。

2025年,AI大模型彻底告别“实验室阶段”,正式迈入工业化应用爆发期,不再是遥不可及的技术概念,而是深度融入千行百业的生产力工具。其中,六大行业率先突破,成为大模型落地的核心前沿阵地,更是小白入门、程序员布局的关键赛道:教育领域破解“个性化-高质量-大规模”的不可能三角,让因材施教落地生根;医疗行业加速摆脱经验依赖,迈入数据智能驱动的新阶段;金融行业实现AI从边缘辅助到核心支撑的跨越;工业制造借

1.拒绝“技术焦虑”,按需选择架构:简单任务(如单一判断、文本总结),用纯LLM+提示词工程就足够;需要私有/实时数据,用RAG;标准化流程,用AI工作流;复杂多变、需要自主决策,再考虑AI Agent。\2.入门从简单开始,逐步提升复杂度:小白先从纯LLM的提示词工程练手,熟悉后再学习RAG搭建,然后尝试简单的工具调用和工作流,最后再挑战AI Agent,不要一开始就追求“高大上”,避免半途而废

核心模块小白/程序员/中小企业实战建议硬件选型小白首选RTX 4090(性价比高、易上手);企业首选二手A100;H100非刚需,不盲目追求框架生态最稳妥组合:HuggingFace(下载模型)+ FastChat/TGI(部署推理)+ TextGen WebUI(小白可视化操作)成本控制自建方案性价比远高于云租,回本周期短(通常2-3个月),长期零成本使用数据安全私有部署的最大优势:所有数据存储

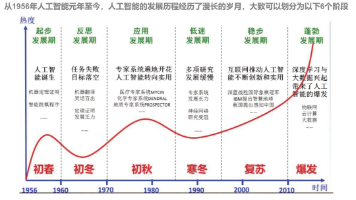

从概念提出到技术突破,人工智能的发展历程体现了人类探索智能奥秘的不懈努力。大模型时代的到来,标志着人工智能进入了新的发展阶段。这些强大的工具正在改变我们的生活方式,并为社会发展带来深远影响。展望未来,随着计算能力的持续提升和算法的不断优化,大模型将在更多领域展现出其独特价值。但同时我们也需要保持清醒认识,在技术创新的同时注重伦理规范,确保人工智能技术造福人类社会。