简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了YOLO26的安装配置与快速使用方法。YOLO26是Ultralytics发布的最新端到端视觉AI产品,在检测、分割、分类等任务上具有显著性能提升。文章详细讲解了创建Python虚拟环境、配置PyCharm编辑器、通过Pip或GitHub安装YOLO26的步骤,并提供了GPU版PyTorch的安装建议。安装完成后可通过"yolo help"命令验证安装成功。该教程帮助

如何更好地使用 DeepSeek,使之真正能成为生产力工具和个人专家助理。就DeepSeek 辅助博客写作提纲进行了对话和交流,结果确实令人震撼。

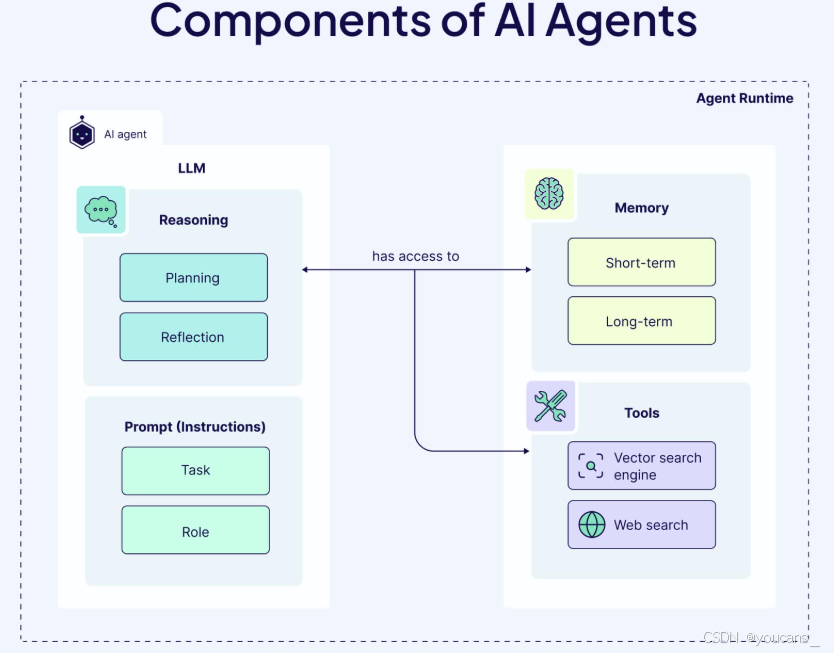

大语言模型的浪潮推动了 AI Agent 相关研究快速发展,AI Agent 是当前通往 AGI 的主要探索路线。大模型让 AI 会思考,而 Agent 让思考能落地"——这正是Deepseek等平台正在构建的下一代智能基础设施。

OpenAI 官宣:LIVE5TREAM(直播)将在 8月7日上午10点(太平洋时间),也就是北京时间 8月8日(周五)发布。

DeepSeek-Prover-V2 是由 DeepSeek 团队开发的开源大型语言模型,专注于形式化数学定理证明,尤其在 Lean 4 平台上的表现达到行业领先水平。该模型通过结合非形式化推理与形式化验证,实现了数学直觉与符号逻辑的双向对齐,标志着AI在数学推理领域的重大突破。

借助扣子Coze提供的可视化设计与编排工具,你可以通过零代码或低代码的方式,快速搭建出基于大模型的各类 AI 项目。本文详细讲解基于 Coze 快速搭建智能体的步骤。

本研究构建了首个中文ROP风险预测数据集CROP(993条早产儿入院记录),提出Affective-ROPTester评估框架,探究LLMs在ROP预测中的能力与偏差。研究发现:1)LLMs仅依赖内在知识预测效果有限,引入外部知识可显著提升性能;2)模型存在高估中高风险的固有偏差;3)积极情感框架能有效缓解预测偏差。该研究为医疗AI的风险预测提供了新基准,揭示了情感提示工程在提升诊断可靠性中的重要

『ChatGPT Prompt Engineering for Developers』是 吴恩达/DeepLearning.AI 为开发者准备的提示工程课程。本文对该课程内容的完整翻译和整理,完整 PDF 版已上传到 GitHub,详见内文。

本文详细解读 DeepSeek-V3.2 技术报告和 API 使用指南。DeepSeek-V3.2 新一代开源大型语言模型在推理能力和工具调用方面实现重大突破,模型已开源并更新至官方应用,为AI社区提供高性能开源选择。

「商汤」在技术交流日分享了以 “大模型+大算力” 推进 AGI(通用人工智能)发展的战略布局,公布了「商汤」的“日日新SenseNova”大模型体系,推出自然语言处理、内容生成、自动化数据标注、自定义模型训练等多种大模型及能力。