简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Python程序提供了其他技术无法比拟的交互性和可访问性,重要的是,在 Python 程序中实现语音识别非常简单。我们一起来了解python程序的:语音识别的工作原理、PyPI 支持哪些软件包以及如何安装和使用 SpeechRecognition 软件包(一个功能全面且易于使用的 Python 语音识别库),让你体验到用Python程序实现语音识别就是这么简单!(文末送读者福利)python语音识

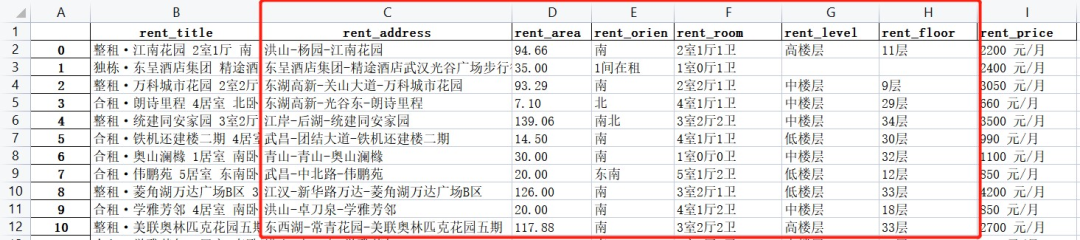

我们希望得到的效果是在地图上标注出各个房源的地点,具体地,使用经纬度与地图上的位置进行匹配,并用散点标记,点的大小表示房屋的面积rent_area,颜色表示楼层高度等级rent_level,房屋的户型、租金和楼层数在点的标签里进行展示。在jupyter notebook中的展示结果如下,我们可以滑动鼠标进行区域的放缩,也可以将鼠标移动至感兴趣的位置,查看对应的房源信息,这样房屋的地理位置、周围环境

代码:https://github.com/ltp1995/GPVL论文:https://arxiv.org/abs/2501.08861(Generative Planning with 3D-vision Language Pre-training)是一种端到端自动驾驶模型,旨在解决现有视觉基础模型在视觉理解、决策推理和场景泛化方面的挑战。GPVL 模型通过3D视觉语言预训练模块,将视觉感知与

本文系统综述了大模型工具学习的发展脉络与技术进展,剖析了工具对大模型能力的扩展,梳理了从上下文学习到微调训练的工具调用机制,探讨了工具调用性能优化、自适应工具生成等关键问题,并分析了大模型工具调用的测评方法。文章最后总结了当前工具学习面临的挑战并对大模型工具学习未来发展方向进行展望。作者:廖牛语,田沄,李岩松等来源:《计算机工程》期刊编辑:陈萍萍的公主@一点人工一点智能原文:https://www

Agent(智能体)作为连接大模型与实际业务场景的核心载体,正成为AI应用开发的重要方向。从简单的对话机器人到复杂的自主决策系统,Agent的核心价值在于实现感知-思考-行动的智能闭环,而大语言模型(LLM)则为Agent赋予了真正的“思考”能力。本文将从Agent的基础定义出发,理清其核心特征与发展演进,同时结合实战代码,讲解基于主流接口规范的大模型调用方法,为 Agentic 开发打下基础。能

中国AI大模型行业在短短三天内经历跃迁式发展,Seedance 2.0、Qwen-Image 2.0、MiniMax M2.5、DeepSeek百万Token模型及开源GLM-5等相继问世。厂商策略从参数竞赛转向解决实际问题,聚焦内容创作、效率提升与工程执行。国产大模型依托完善的产业链、算力平台、应用场景及政策支持,展现出从追赶走向突围的趋势,标志着AI技术正从实验室走向生产实际,为资源创造新价值

Python是一门功能强大的编程语言,不仅可以用于开发应用程序,还可以用于自动化测试。对于测试人员来说,掌握一些简单但实用的Python自动化测试脚本,可以提高工作效率并减少重复劳动。本文将介绍10个常用的Python自动化测试脚本,并提供实际接口自动化工作中的示例代码。

SuperCLUE评测通过数学推理、科学推理、代码生成等6大任务评估大模型能力,涵盖推理与应用。评测包含998道新题,测评34个模型,提供综合排名与智能指数。文章还分析了生成耗时与模型价格,帮助读者全面了解模型性能与经济性,是学习大模型应用的必备资料。| 前言SuperCLUE年度测评涵盖了数学推理、科学推理、代码生成、精确指令遵循、幻觉控制、智能体(任务规划)六大任务,其中数学推理、科学推理、代

数据集下载地址:训练集(train.csv)验证集(dev.csv)测试集(test.csv)34,3344,3163,861。

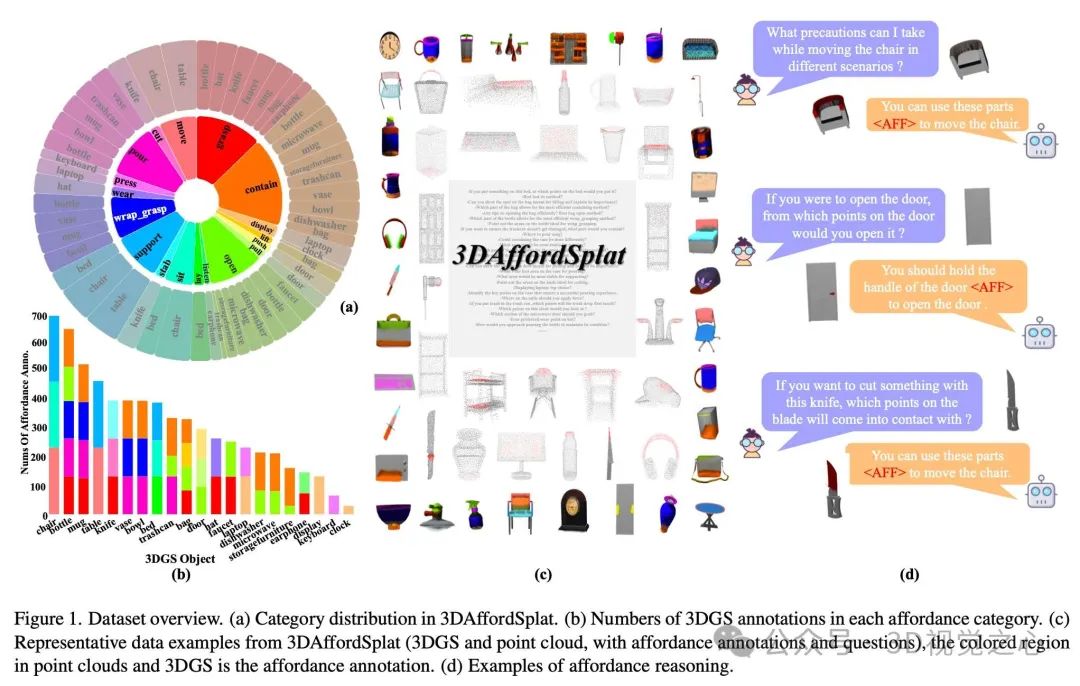

给定一个三维高斯泼溅(3DGS)表示 ,其中 表示高斯中心位置, 表示尺度参数, 表示旋转参数(统称为结构特征),以及不透明度 和基于球谐函数的颜色特征 (统称为外观特征)。我们假设物体的功能属性主要来源于局部结构特征,因此模型仅处理结构特征。对于给定的文本查询 ,模型输出文本响应 和对应的三维高斯功能掩码 ,其中 表示高斯数量。