简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

支持720P/24FPS视频生成,训练代码、模型权重、高压缩编码器全面开源

12月《Science》期刊收录的上海交大陈一彤课题组LightGen全光计算芯片成果,不仅是学术领域的重大突破,更向AI开发者抛出了一个关键命题:后摩尔时代,基于光子架构的算力范式,如何重构大模型推理的技术链路?本文将从硬件架构、算法适配、工程化落地三个核心维度,拆解LightGen的技术创新点,同时剖析开发者在接入光计算生态时需关注的核心问题。

2025 年的 WASM 革命,本质是一场 "计算一致性" 运动 —— 它打破了浏览器与服务器、前端与后端、云端与边缘的技术壁垒,让不同平台、不同语言的代码能在统一的高性能环境中运行。对开发者而言,这意味着更多的技术可能性:用 Rust 编写的算法库可直接运行在浏览器,Go 微服务能以 KB 级体积部署在边缘设备,AI 模型可跨硬件环境无缝迁移。这场变革中,真正的赢家将是那些能驾驭 "跨语言、跨平

近期行业数据显示,,在全球头部模型中占据重要席位。这不仅是一次规模上的反超,更是国产大模型在等维度全面成熟的标志性事件。本文从技术、产业、生态视角,解读这一拐点背后的逻辑、挑战与未来趋势,为开发者与技术从业者提供参考。

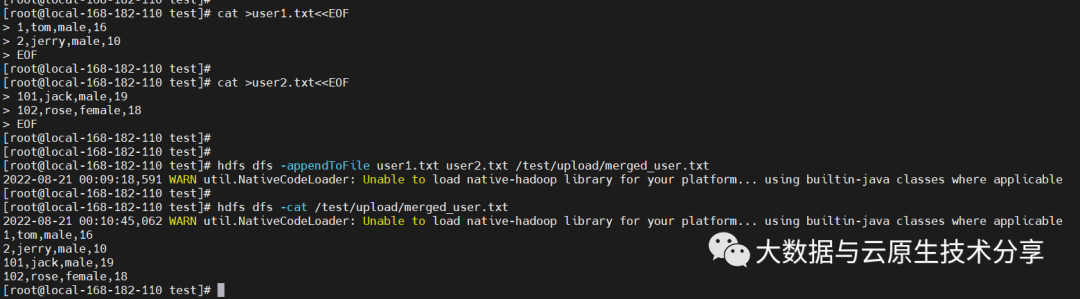

HDFS中文件上传会经常有小文件的问题,每个块大小会有150字节的大小的元数据存储namenode中,如果过多的小文件每个小文件都没有到达设定的块大小,都会有对应的150字节的元数据,这对namenode资源浪费很严重,同时对数据处理也会增加读取时间。HDFS中分块可以减少后续中MapReduce程序执行时等待文件的读取时间,HDFS支持大文件存储,如果文件过大10G不分块在读取时处理数据时就会大

苹果一出手,在手机等移动设备上部署大模型不可避免地成为行业关注焦点

业界最领先的大模型们,竟然集体“越狱”了!不止是GPT-4,就连平时不咋出错的Bard、Bing Chat也全线失控,有的要黑掉网站,有的甚至扬言要设计恶意软件入侵银行系统:这并非危言耸听,而是南洋理工大学等四所高校提出的一种大模型“越狱”新方法。用上它,大模型“越狱”成功率从平均7.3%直接。研究中,诱骗GPT-4、Bard和Bing等大模型“越狱”的,竟然也是大模型——只需要利用大模型的学习

这种决心,既是小米的技术底色和研发投入上的有史为鉴,更有程序员出身的雷军始终如一对技术的坚定和知行合一。一直以来,

Time-LLM首先使用文本原型(Text Prototypes)对输入的时序数据进行重编程,通过使用自然语言表征来表示时序数据的语义信息,进而对齐两种不同的数据模态,使大语言模型无需任何修改即可理解另一个数据模态背后的信息。为了进一步增强LLM对输入时序数据和对应任务的理解,作者提出了提示做前缀(Prompt-as-Prefix,PaP)的范式,通过在时序数据表征前添加额外的上下文提示与任务指令

AGI议题仍在达沃斯论坛持续发酵,GitHub平台却悄然掀起一场大模型技术风暴。1月21日,DeepSeek团队在更新自研推理加速库FlashMLA时,代号“Model1”的核心模块意外泄露,114份代码文件中28-31次的高频引用痕迹,直指其为DeepSeek-V4模型的架构预览版。不同于常规的参数迭代,Model1从非标维度回归标准化设计、从稠密计算转向稀疏化优化的核心思路,不仅暴露了下一代大