简介

该用户还未填写简介

擅长的技术栈

可提供的服务

大数据人工智能相关课程培训,人工智能培训及咨询,合作抠抠526346584

叶梓,工学博士,高级工程师。2005年上海交通大学计算机专业博士毕业,在校期间的主研方向为数据挖掘、机器学习、人工智能。毕业后即进入软件行业从事信息化技术相关工作;负责或参与了多项国家级、省市级人工智能及大数据项目的建设工作。在人工智能和大数据应用等方面都有着丰富的经验。

《高质量数据集与大模型应用技术》培训提纲

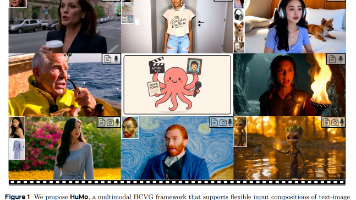

字节跳动联手清华大学开源多模态视频生成神器——HuMo!它凭一张图、一段文字、一段音频,就能轻松生成电影级效果的说话视频,彻底解决了传统技术中人物身份不一致、声音画面不同步的老大难问题

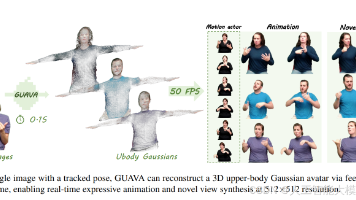

清华团队开源GUAVA技术,仅凭一张图,0.1秒就能生成超逼真3D化身!身份一致、表情精准,还能实时驱动,渲染流畅自然。这大幅降低了创作门槛,影视、直播等行业将迎来新变革!

叶老师直播分享。Dify是一款开源的大模型应用开发平台,旨在简化和加速生成式AI应用的创建和部署。

符号回归作为一种从数据中发现可解释数学表达式的基本工具,在科学和工程领域具有广泛应用。然而,现有的基于大模型的方法,如 LLM-SR,往往过度依赖大模型内部的先验知识,缺乏对数据结构的深入理解和系统反思机制,导致生成的方程准确性和泛化能力有限。为了解决这些问题,中国科学院自动化研究所的研究人员提出了 DrSR(Dual Reasoning Symbolic Regression)框架,通过结合数据

人工智能咨询培训老师叶梓 转载标明出处在人工智能领域,提升大模型(LLMs)的推理能力一直是研究的重点。传统的方法主要依赖于特定的提示技术,例如少量样本或零样本的思考链(CoT)提示。这些方法虽然有效,但往往需要大量的手动提示工程。来自Google DeepMind的Xuezhi Wang和Denny Zhou提出了一个新的研究视角:无需提示,LLMs能否有效推理?研究者们发现,与传统的贪婪解码相

这个平台的设计理念非常现代,它追求的是内核的简洁和生态的强大。而且,lowcode-engine 使用的是TypeScript,这是一个静态类型的编程语言,它能够提供更好的代码健壮性和开发体验。此外,lowcode-engine 提供的不仅仅是代码层面的支持,它还提供了一套完整的工具链,帮助你从设计到部署的整个研发周期都能更加高效。lowcode-engine 是阿里巴巴推出的一个企业级的低代码开

基于阿里研发的组合式生成模型Composer,通义万相提出了基于扩散模型的「组合式生成」框架,通过对配色、布局、风格等图像设计元素进行拆解和组合,提供了高度可控性和极大自由度的图像生成效果。大模型的研发动辄要超千亿参数,囊括了底层算力、网络、存储、大数据、AI框架、AI模型等复杂技术的系统性工程,堆GPU是无法实现的。比如,「中国甲虫陶瓷雕塑零件面板,装配零件和道具,金画细节Knolling布局,

Evo2 是由斯坦福大学、英伟达、Arc研究所、加州大学伯克利分校和加州大学旧金山分校的科学家联合发布的生物学大模型,其完整版包含 400亿参数,训练数据覆盖 12.8万个物种 的 9.3万亿个核苷酸。这一模型的发布标志着AI在生物学领域的重大突破,为基因组学、精准医学、药物研发和合成生物学带来了全新的可能性。传统的生物学研究依赖于实验方法和数据分析,但随着基因组学的快速发展,海量的基因组数据需要