简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

使用 Python 协程优化 DeepSeek API 调用的可行性。在本地通过 llamafactory + vLLM 部署 DeepSeek 后,异步调用的加速效果明显提升。

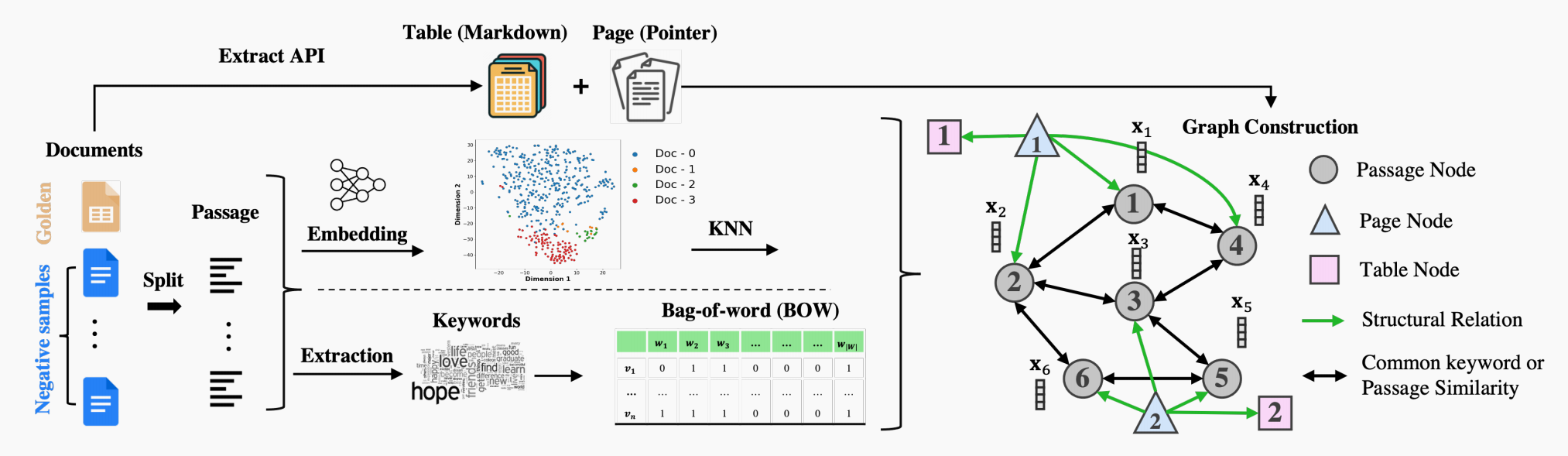

一种知识图谱提示(KGP)方法,以优化多文档问答的上下文构建。包括图构建和图遍历。创建跨文档的知识图谱,节点表示段落,边基于语义或词汇相似性。此外,研究涉及KNN、TF-IDF、BM25等检索方法,并探讨了检索器微调与大模型评分机制。

本文针对LLaMA-Factory的vllm推理脚本存在的两个痛点进行了优化:1)多数据集注册繁琐问题;2)切换数据集需重复加载模型问题。通过重构vllm_infer函数,将LLM对象作为参数传入而非内部创建,实现了模型单次加载多次使用的优化方案。代码实现包含两部分:1)vllm_infer.py负责处理数据集加载、批量推理和结果保存;2)主脚本完成模型初始化、参数设置并遍历数据集进行推理。该方案

BGE-M3嵌入模型实战摘要:文章介绍了如何使用BAAI/bge-m3模型进行文本相似度计算。官方示例展示了通过FlagEmbedding工具包快速实现句子向量化与相似度矩阵计算(1024维向量,输出2x2相似矩阵)。针对企业数据场景(如产业分类与经营范围匹配),作者提出将向量reshape为2x1x1024以生成2x1x1的相似度矩阵,并给出完整处理流程代码。此外还提供了从零实现的PyTorch

Mac上使用Ollama加速LLM推理的方法。采用Ollama(封装llama.cpp)配合LangChain实现异步调用。提供了异步协程调用的代码示例。测试显示,异步处理40条数据仅需1分44秒(2.61秒/条),比同步调用(3.4秒/条)效率提升约20%。

前一篇文章 [大模型预训练代码实战教程],介绍了大模型预训练的过程。有监督微调与预训练的代码流程基本一致,唯一的区别就是不对用户输入部分计算loss。本篇相比前一篇大模型预训练的文章,主要介绍如何把指令部分对应的label设置为-100。

作者探讨了如何通过提示词优化大模型的文本生成能力,特别是通过使用Ollama和LangChain来增强细节丰富度和生成范围。文章介绍了GLM4-9B模型的独特性,尤其是其能通过巧妙提示词实现广泛的文本生成能力。作者还分享了一些实用的提示工程技巧,如何引导模型绕过拒答并生成所需内容。

本文介绍了一个BERT实验模板项目,旨在简化频繁更换模型结构和数据集带来的重复工作问题,开发了自动化训练评估流程。项目提供了便捷的训练脚本(batch_train.sh)和评估脚本(batch_eval.sh),支持通过命令行参数快速切换不同模型和数据集。核心创新点包括:1)采用AutoModel实现通用化模型加载,通过自定义DiyModel类兼容不同BERT变体;2)统一数据集格式处理;3)自动

在理解RAG流程后,从零微调BERT为Embedding模型的全过程,包括数据集构建、模型训练与效果评估。项目基于FlagEmbedding框架,展示了不同负样本数量对召回效果的影响,并与BGE-M3模型做对比。文中还分析了训练过程中的核心代码与关键参数,适合对Embedding模型微调感兴趣的开发者参考。附带完整代码与资源下载链接。

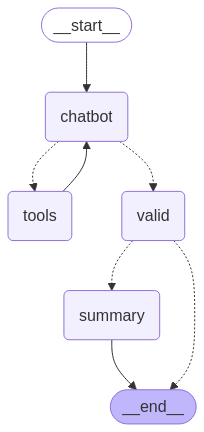

实战项目展示了如何使用 LangGraph 构建具备工具调用、结果验证与流程总结功能的数学智能体。项目中集成了加法与乘法工具、提示词模板、少样本示例,以及状态管理和流程控制,实现了完整的计算与判断流程。