简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

通过本文介绍的步骤,我们完成了一个简单的机器学习工作流,包括数据加载、探索、预处理、建模、预测和评估。求求官方别限流啦。

是一款由 Activeloop 开发的开源深度学习数据湖,旨在解决深度学习数据管理的挑战。它提供高效的多模态数据管理、类似 Git 的版本控制、强大的查询和可视化功能,并与 MLOps 生态系统无缝集成,助你轻松驾驭海量数据,加速模型训练!

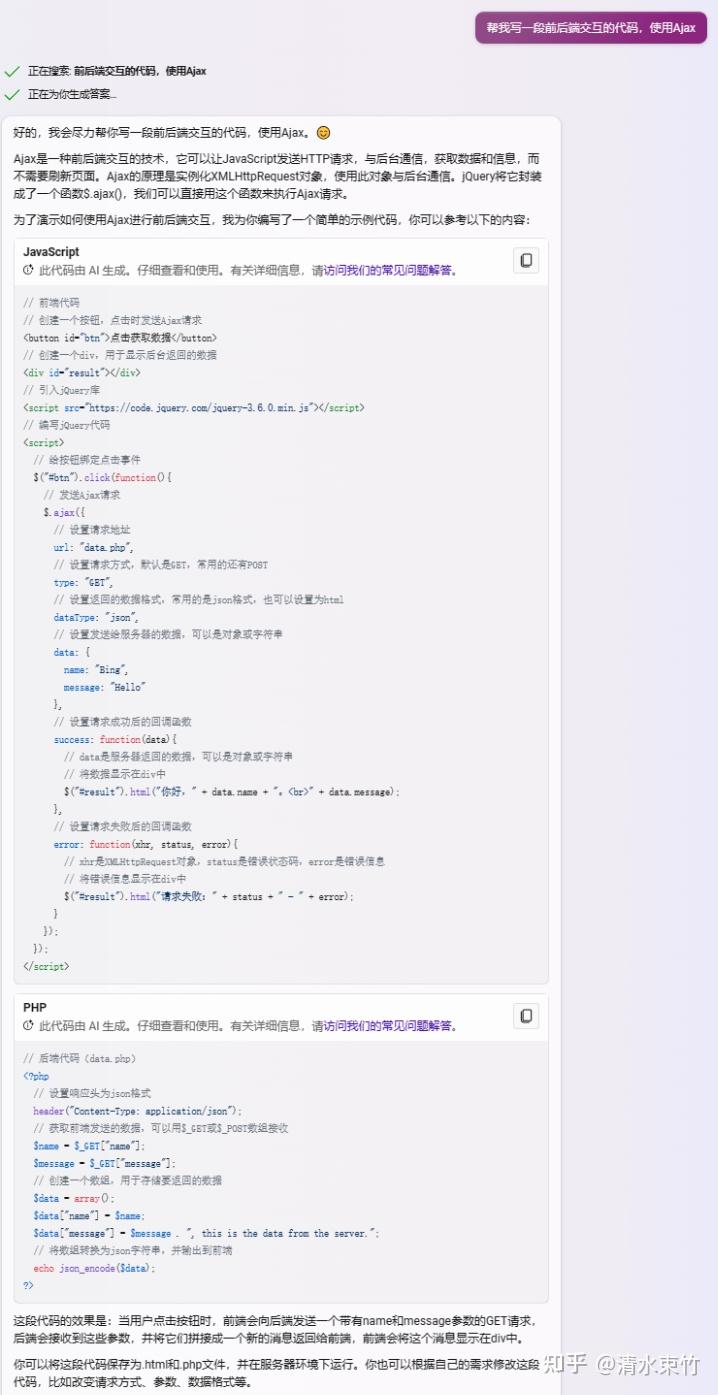

最近公司有一个项目需求需要使用到AI智能识别的功能《垃圾智能AI识别系统》,本人一直从事Web领域开发工作,也没接触过人工智能这个赛道,刚好现在借这个“腾讯云 AI 代码助手编程挑战赛”来了解一下AI写代码相关的流程。刚好也是接触新的技术领域,经过“腾讯云AI代码助手”来帮助我从0到1来实现这个《构建开发板垃圾图片识别AI对话的Copilot》的项目,在很多地方帮助程序员开发人员更好地理解和优化代

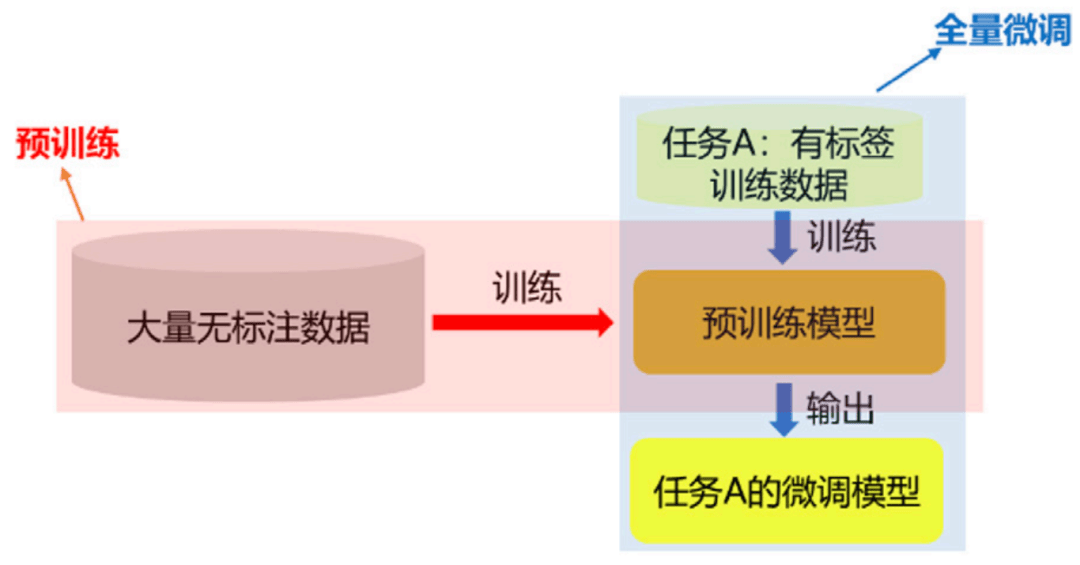

预训练是指使用海量的未标注数据对模型进行训练,使其学习到通用的知识和模式。这些数据通常来自书籍、文章、网站等多种来源,涵盖了广泛的领域和语言结构。通过预训练,模型能够掌握语言的底层规律,如词汇语义、句法结构,以及不同场景下的通用模式和上下文关系。泛化能力是指模型从训练数据中学习到的知识和模式,能够应用到新的数据、任务或环境中的能力。简单来说,就是模型在面对未曾见过的情况时,依然能够做出合理的判断、

个人情况:本科双非,考研上了北邮,目前研二。先找了某安全公司的日常实习(线下一下午,一面、二面、leader面、HR面,过了就去了),3月16日申请了阿里云安全开发暑期实习,4月14日收到意向书。简历重点:WEB安全、Python、软件著作权一项、实验室的漏洞挖掘项目和字节跳动安全与风控部门寒假训练营(所在小组获得第一)。字节跳动训练营是给了网站,挖漏洞,搭建WAF防护该网站,搭建WAF管理平台。

大二,普通本一学校(福建师范大学),计算机科学与技术专业,不知道哪个方向更好,一堆培训机构各有各的说法。这些培训机构值不值得报,是否真的如他们所说,报了更有竞争力。从我身边的例子看,如果是选择学习/研究方向,而且学校和导师提供的资源相同的话,那么从和两个角度分析——

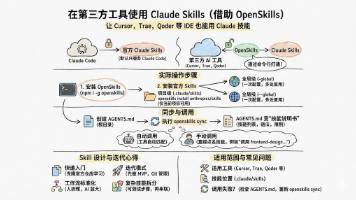

官方 Skills 只能解决通用问题,真正体现团队优势的,是把自身业务工作流抽象为自定义 Skills。借助 OpenSkills,Claude Skills 不再只属于 Claude Code,而是可以作为一个独立的“能力层”,被不同的 AI 编程工具共享和复用。对于个人开发者,这意味着可以在熟悉的 IDE 中享受更强大的技能生态;对于团队和企业,这则意味着可以在工具多样化的前提下,依然构建统一

随着AI Agent从概念走向规模化落地,2025年Meta收购Manus、Anthropic推出Agent Skills机制等行业事件,标志着“工具+技能”双轮驱动时代的到来。如果说大模型是Agent的“大脑”,那么Skills(技能)就是Agent的“手脚”与“经验库”,是其实现自主决策、场景适配与价值释放的核心支撑。本文将从内涵定义、分类体系、核心价值、构建方法、应用案例及发展趋势六大维度,

人工智能已经成为了现代技术的重要组成部分,所以开发人员学习人工智能是非常必要的。人工智能是未来的趋势:人工智能已经成为了未来技术的趋势,它将会在各个领域发挥重要作用,包括医疗、金融、交通、教育等等。人工智能可以提高开发效率:人工智能可以自动化一些重复性的工作,比如数据分析、图像识别等等,这样可以提高开发效率,减少开发时间和成本。人工智能可以提高产品质量:人工智能可以通过分析数据和模式来预测和避免错

NVIDIA Jetson Orin™ Nano 开发者套件是一款尺寸小巧且性能强大的超级计算机,重新定义了小型边缘设备上的生成式 AI。它采用了性能强大的Orin架构模块,在体积小巧的同时提供高达40 TOPS的AI算力,能够无缝运行各种生成式 AI 模型,包括视觉变换器、大语言模型、视觉语言模型等,为开发者、学生和创客提供了一个高性价比且易于访问的平台。图注:NVIDIA Jetson Ori