简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

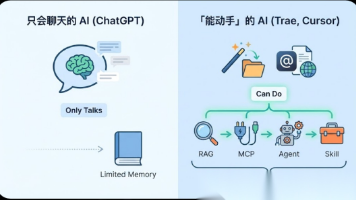

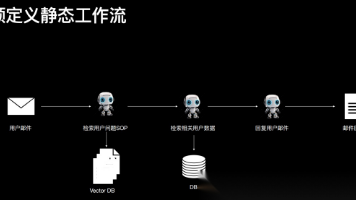

很多企业在聊 AI Agent 的时候,容易陷入两个极端:要么把它当成“更聪明的聊天机器人”,做完一个对话入口就宣布成功;要么一上来就堆满多智能体、工作流、向量库、知识图谱,最后发现系统很炫,但业务并没有更快、更稳、更省。

很多企业在聊 AI Agent 的时候,容易陷入两个极端:要么把它当成“更聪明的聊天机器人”,做完一个对话入口就宣布成功;要么一上来就堆满多智能体、工作流、向量库、知识图谱,最后发现系统很炫,但业务并没有更快、更稳、更省。

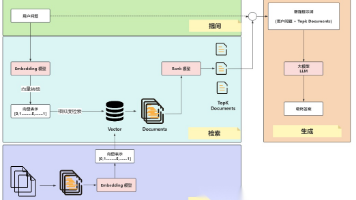

用 Trae 输入一句话就能生成整个项目,Cursor 能 @ 文件、@ 网页——这些「能动手」的 AI 和只会聊天的 ChatGPT 有啥不同?背后是一套从 RAG、MCP 到 Agent、Skill 的底层逻辑。今天用对话帮你讲清楚。

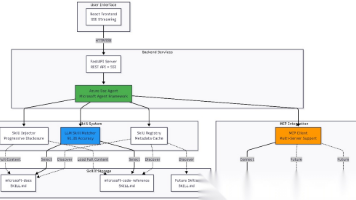

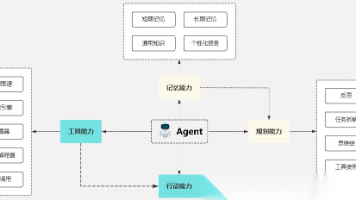

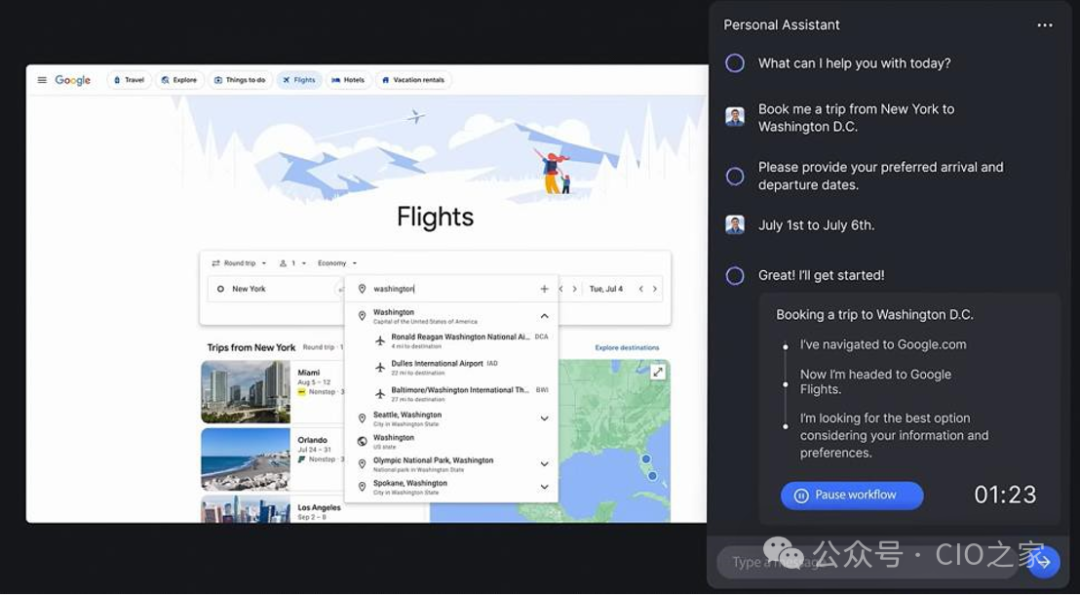

AI Agent(人工智能代理)是一种能够感知环境、进行决策和执行动作的智能实体。不同于传统 的人工智能,AI Agent 具备通过独立思考、调用工具去逐步完成给定目标的能力。比如,告诉 AI Agent 帮忙下单一份外卖,它就可以直接调用 APP 选择外卖,再调用支付程序下单支付,无需人 类去指定每一步的操作。Agent 的概念由 Minsky 在其 1986 年出版的《思维的社会》一书中提出,

随着人工智能技术的飞速发展,自然语言处理(NLP)在各个领域的应用越来越广泛。从智能客服到内容生成,从机器翻译到智能问答,对语言模型的理解和生成能力提出了更高的要求。中国电信人工智能研究院顺应这一趋势,研发出了TeleChat2模型,旨在为用户提供更智能、更高效的语言服务。

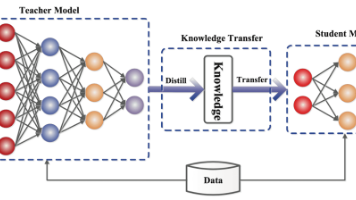

DeepSeek在模型轻量化与性能迁移领域展现出了卓越的技术实力,其核心创新在于数据蒸馏与知识蒸馏的协同应用。

今天小医和大家来聊聊AI医疗领域一个非常硬核且意义重大的方向——AI病理诊断大模型。病理诊断被誉为疾病诊断的“金标准”,但传统模式下,病理医生培养周期长、工作负荷大,且存在一定的主观性。现在,中国的AI力量正试图用“大模型”这把利器,为病理诊断带来一场智慧革命!

Spring AI 版本为1.x 最新版本:1.1.2JDK17+Spring Boot 3.4.8

你可能也遇到过这种情况:* 一个 Agent,刚开始很聪明* 任务一复杂,就开始跑偏* Prompt 越写越长,系统却越来越不稳定

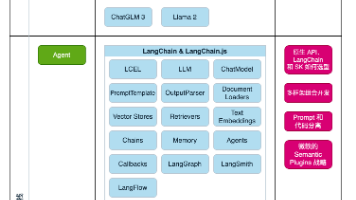

由Anthropics开放的Claude agent skills无疑是当下最火的Agentic技术。各大AI开发助理厂商也都跟进,你可以利用Claude code agent SDK或者其他厂商的SDK来实现这个功能,或者在AI开发助理软件中直接使用。但它本是一个开放标准,本文利用这个思想,参考Skills的文档自主开发实现这个能力。另外也通过本篇文章的实际例子来阐述Agent Skills和M