简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了向量嵌入的基本概念和应用。向量嵌入通过将词语、句子或物体转化为多维数字向量,使计算机能够理解语义关系。相似事物在向量空间中距离更近,支持语义搜索、推荐系统等应用。文章解释了向量嵌入的工作原理、常见类型(词嵌入、句子嵌入等)和实际应用案例,并提供了动手体验的代码示例。向量嵌入技术是AI理解语义信息的关键基础。

📌 AI幻觉:大语言模型的"虚构"问题解析 摘要:AI幻觉指大语言模型以自信流畅的语气生成事实上错误或虚构内容的现象,如杜撰论文、编造判例等。其危险性在于错误信息往往包装专业,难以辨别。技术成因包括训练数据局限、缺乏知识验证机制及概率采样随机性。行业通过RLHF训练优化、RAG架构改进(检索增强生成)及产品级保障(信息溯源、多轮检查)进行缓解。关键结论:AI幻觉目前无法根除,

MoE(混合专家)模型通过将多个"专家"网络与门控网络结合,实现了高效的大模型训练。门控网络根据输入选择最匹配的Top-K专家进行加权计算,既保留了大规模模型的参数容量,又通过稀疏激活降低了计算成本。MoE通常替换Transformer中的FFN层,保持注意力机制不变。虽然MoE解决了传统稠密模型的计算效率问题,但也面临负载均衡和高资源需求等挑战。这种架构为超大规模AI模型提供

AI Agent(智能体)是一种能够自主感知环境、制定计划并采取行动的人工智能系统,与传统AI工具不同,它能主动拆解任务、调用工具并持续优化。AI Agent具备感知、规划、工具使用和记忆反思等核心能力,不同于单轮反应的聊天AI,它能进行多轮自主思考。典型应用包括个人效率、软件开发、企业服务和创意生产等领域。技术架构上采用ReAct模式(思考与行动交替)或多Agent协作方式,通过协调者分配任务给

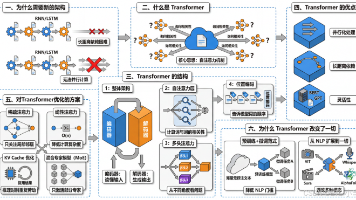

Transformer是一种革命性的神经网络架构,彻底改变了序列数据处理方式。相比RNN/LSTM,它通过自注意力机制解决了长距离依赖和并行计算问题,使模型能直接捕捉词间关系。其核心结构包括编码器-解码器、多头注意力和位置编码,具有并行化处理、长距离依赖捕捉和高度灵活性等优势。针对计算复杂度高的缺陷,业界提出了稀疏注意力、线性注意力、KV缓存和混合专家模型等优化方案。Transformer不仅确立

低代码发展趋势如此猛,你是否有担心被替代的危机呢?

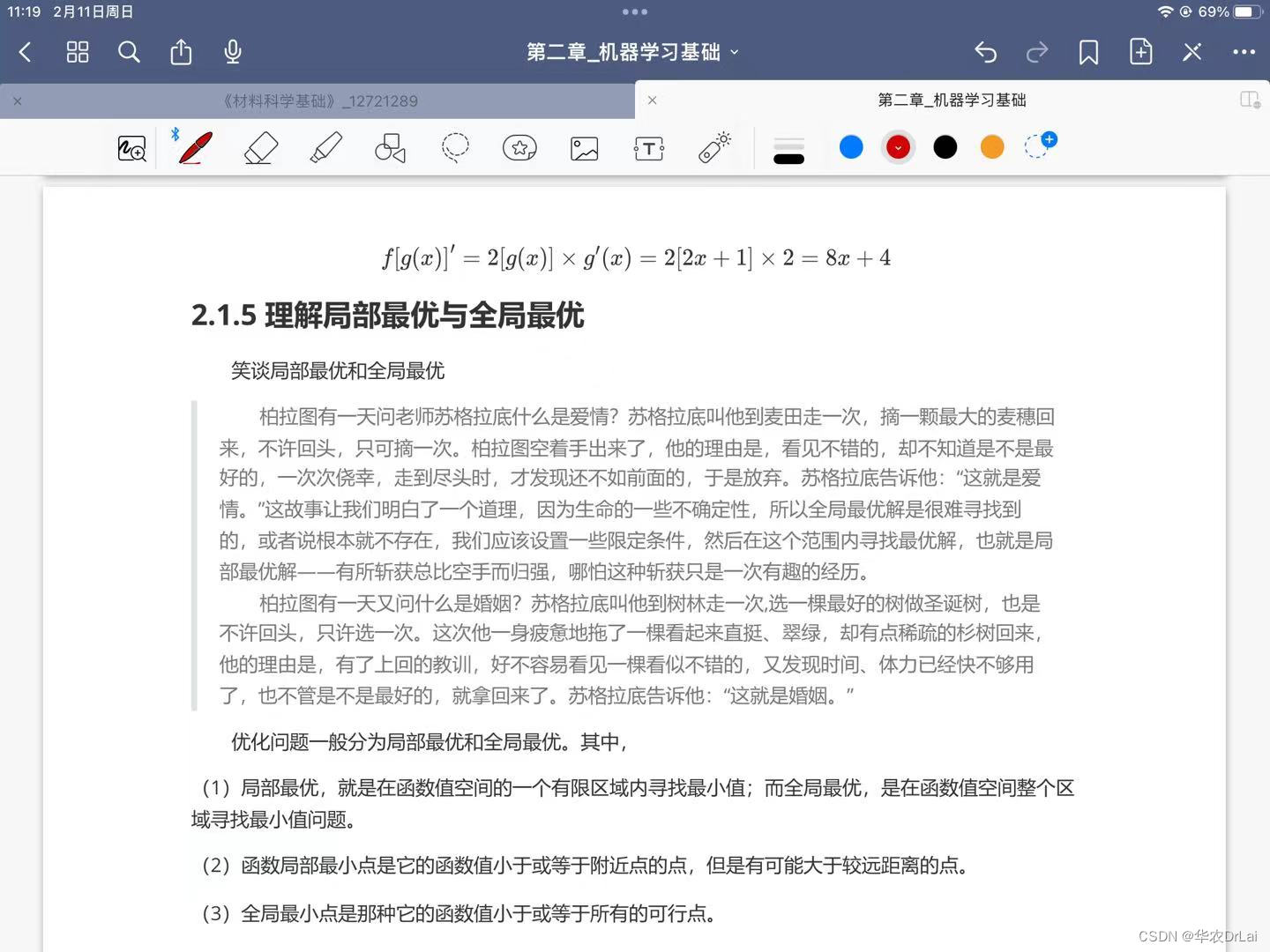

(1)局部最优,就是在函数值空间的一个有限区域内寻找最小值;而全局最优,是在函数值空间整个区域寻找最小值问题。(2)函数局部最小点是它的函数值小于或等于附近点的点,但是有可能大于较远距离的点。(3)全局最小点是那种它的函数值小于或等于所有的可行点。

机器学习中的梯度下降法是一种寻找函数最小值的优化算法,广泛应用于训练各种模型,尤其是在深度学习中。

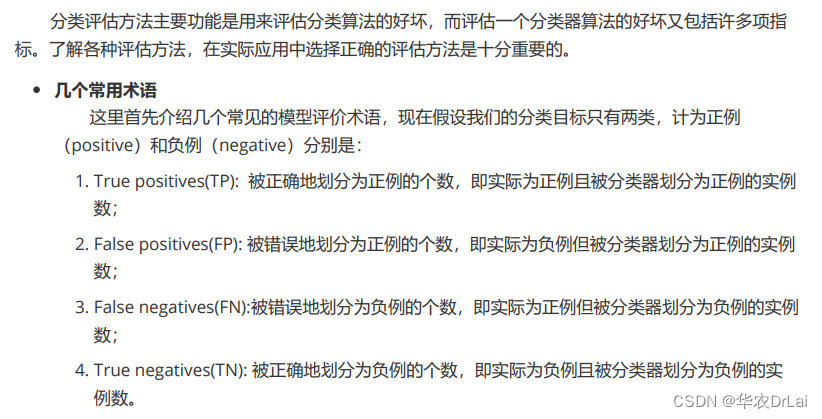

了解各种评估方法,在实际应用中选择正确的评估方法是十分重要的。2.False positives(FP):被错误地划分为正例的个数,即实际为负例但被分类器划分为正例的实例数;1.True positives(TP):被正确地划分为正例的个数,即实际为正例且被分类器划分为正例的实例数;3.False negatives(FN):被错误地划分为负例的个数,即实际为正例但被分类器划分为负例的实例数。4.

Redis基本类型的例子一篇就够