简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

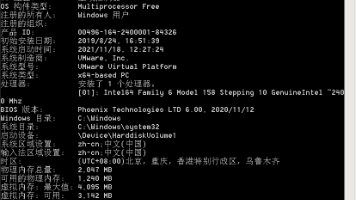

本文介绍了内网渗透的基本概念和常用信息收集方法。主要内容包括:通过systeminfo、net start等系统命令获取主机信息;利用net view/domain、ipconfig等判断域环境;使用ping扫描探测存活主机;以及获取用户凭证的工具如mimikatz、LaZagne等。文章强调系统命令的优势在于免杀,并提供了详细的操作示例和截图说明,为内网渗透测试提供了基础技术参考。

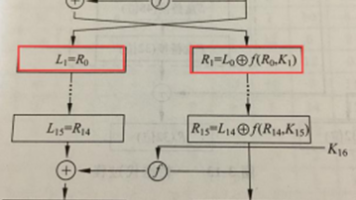

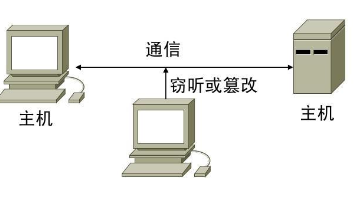

本文介绍了网络信息安全的基础知识和加密技术。主要内容包括:信息安全的基本概念、威胁分类(硬件、系统、协议等漏洞)和攻击手段(如口令入侵、DDoS等);密码学的发展历程和密码系统组成(明文、密文、密钥等);典型加密技术如置换密码、代换密码(单表/多表)及其应用实例(Caesar、Vigenere、Playfair和Hill密码)。文章系统梳理了信息安全的核心要素和技术体系,为理解网络安全防护提供了基

网络安全行业正面临法规驱动、预算有限和AI冲击三大挑战。从业者有三条出路:成为技术架构师、拥抱AI提升效率、转向合规工作。建议尽早转型,顺应行业变化,避免被市场淘汰。三条路都不易,但比原地等待强。

网络安全行业虽热门但竞争激烈,缺乏的是实战型人才而非理论小白。作者以自身经历证明,通过系统学习实战技能可实现职业发展。文章分享了多个优质学习资源,包括Hacksplaining、Try Hack Me等实战网站,以及The Cyber Mentor、NetworkChuck等YouTube频道。核心忠告是:网络安全不靠证书背书,靠持续实战积累,找对学习方法并坚持练习才能在竞争中立足。

2026年网络攻防进入“AI+自动化”新纪元,传统渗透工具已难以适配云原生、IoT、DevSecOps等复杂场景。本文精选今年最顶流的渗透测试神器,覆盖AI驱动、云环境、全流程自动化等核心趋势,既有经典工具的重磅升级,也有颠覆行业的新兴框架,无论你是合规测试的企业安全师,还是冲击CTF榜单的白帽大神,收藏这篇就能领跑2026攻防战场!

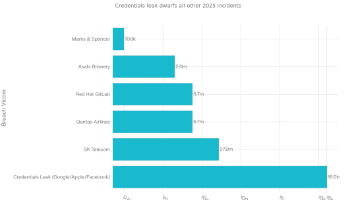

2025年见证了人工智能技术的加速发展与前所未有的网络安全威胁的上升。进入2026年,AI技术的多模态能力、推理深度和自主性将发生质的飞跃,与此同时,AI驱动的网络攻击也在以指数级速度演进。关键发现包括:大模型安全漏洞中prompt注入攻击在73%的生产环境中出现;2025年发生的16亿密码泄露事件成为历史上规模最大的凭证泄露;81%的企业计划在2026年前采纳零信任架构;NIST已批准四项后量子

本文介绍了Burp Suite(BP)工具的Proxy代理模块功能。BP是用于攻击Web应用程序的集成平台,Proxy模块主要用于拦截和修改HTTP会话内容,为其他模块提供数据支持。文章详细讲解了Proxy的四个组成部分:Intercept(截断模式控制)、HTTP history(历史数据包查看)、Websockets history(类似HTTP history)和Options(代理配置)。

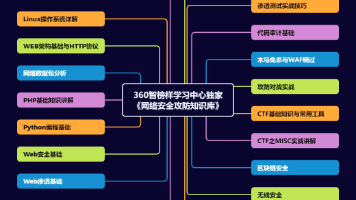

广度: 面向企业安全建设的核心场景(渗透测试、红蓝对抗、威胁狩猎、应急响应、安全运营),本知识库覆盖了从攻击发起、路径突破、权限维持、横向移动到防御检测、响应处置、溯源反制的全生命周期关键节点,是应对复杂攻防挑战的实用指南。• 注意:一个人的工资收入💸 会受到多重因素的影响,比如就读院校层次、学历层次、就职的公司及岗位、机遇、身体💪和心理 💚健康保持能力(有些高收入💰💰💰待遇需要多年拼

近年来,随着深度学习技术的飞速发展,AI大模型作为人工智能领域的重要研究对象,正逐步成为学术界和产业界广泛关注的热点议题。AI大模型,作为一类具备庞大参数规模与卓越学习能力的神经网络模型,如BERT、GPT等,已在自然语言处理、计算机视觉等多个领域展现出卓越成效,极大地推动了相关领域的技术进步。**AI大模型的价值不仅体现于其庞大的参数规模与强大的学习能力,更在于其对于解决现实世界复杂问题的巨大潜

2025春节期间,Deepseek和宇树科技的机器人火爆出圈,让很多普通人切身感受到人工智能已经袭来。尤其是Deepseek,甚至有文章说“Deepseek能让张雪峰都失业”。虽然Deepseek目前还没夸张到能报高考志愿表这种程度,但的确和之前的人工智能(AI)聊天助手相比进步了一大截,很多文字分析和处理的工作用人工智能来做已经超过普通人类了。近几年每年都有家长会过来问我,“林老师,我给孩子选这