简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

现在的ai很多,让我看得有些眼花缭乱,随着ai的发展,现在已经有很多ai的大模型已经支持开源,所以现在支持部署一个大模型在自己电脑上,数据私人化。如果不知道自己是否需要或者是否合适配置可以跳到本文的结尾查看小编的使用感受。前排提示,文末有大模型AGI-CSDN独家资料包哦!首先打开开源网站github,大家自行百度就好然后用到现在非常火的ollama这个开源项目,项目地址是各位可以直接打开,然后里

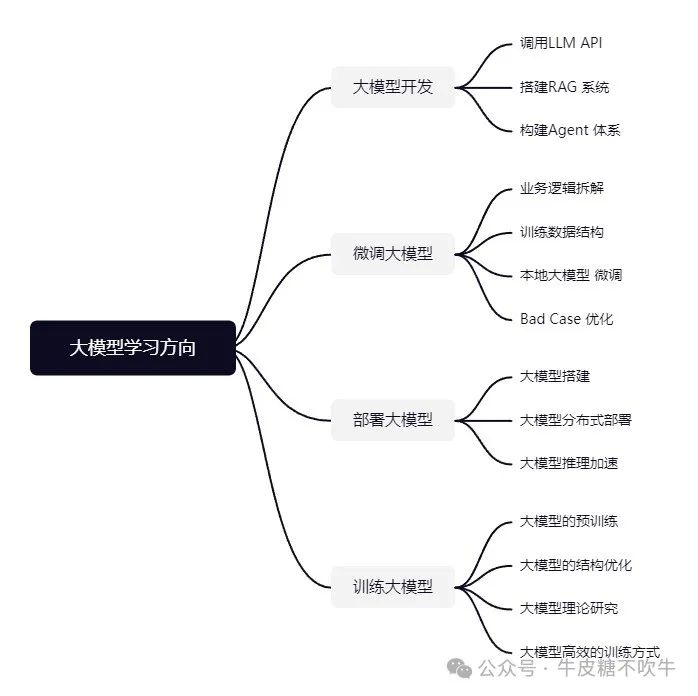

大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。以大模型平台应用与开发为主,

本文详细介绍了ollama工具的离线部署与使用方法。ollama类似docker,但对模型文件进行分层管理。文章分步骤讲解了Linux系统下的离线安装过程,包括获取、解压和配置文件。同时详细说明了ollama的使用方法,包括启动服务、加载已知模型、创建自定义模型的Modelfile编写,以及运行模型时的性能监控。通过具体示例展示了如何部署自研语义大模型,为开发者提供了实用参考。

前排提示,文末有大模型AGI-CSDN独家资料包哦!a.Self-Attention的表达式b.为什么上面那个公式要对QK进行scalingscaling后进行softmax操作可以使得输入的数据的分布变得更好,你可以想象下softmax的公式,数值会进入敏感区间,防止梯度消失,让模型能够更容易训练。c.self-attention一定要这样表达吗?不一定,只要可以建模相关性就可以。当然,最好是能

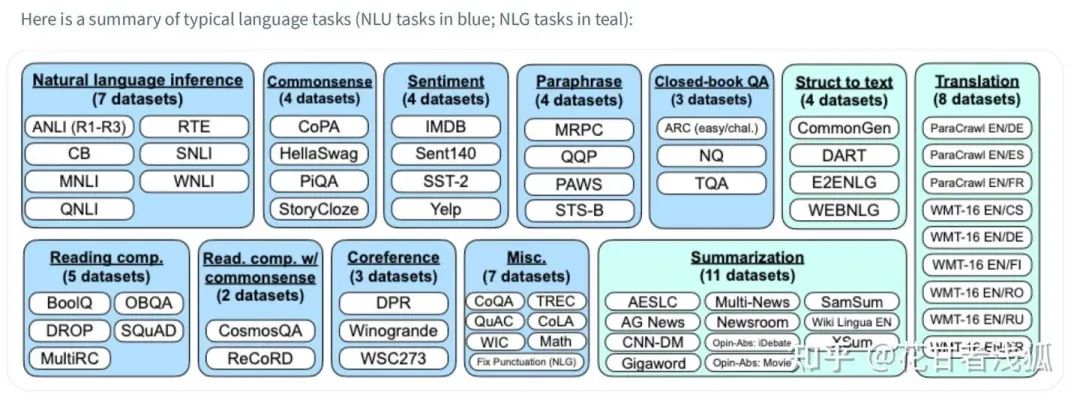

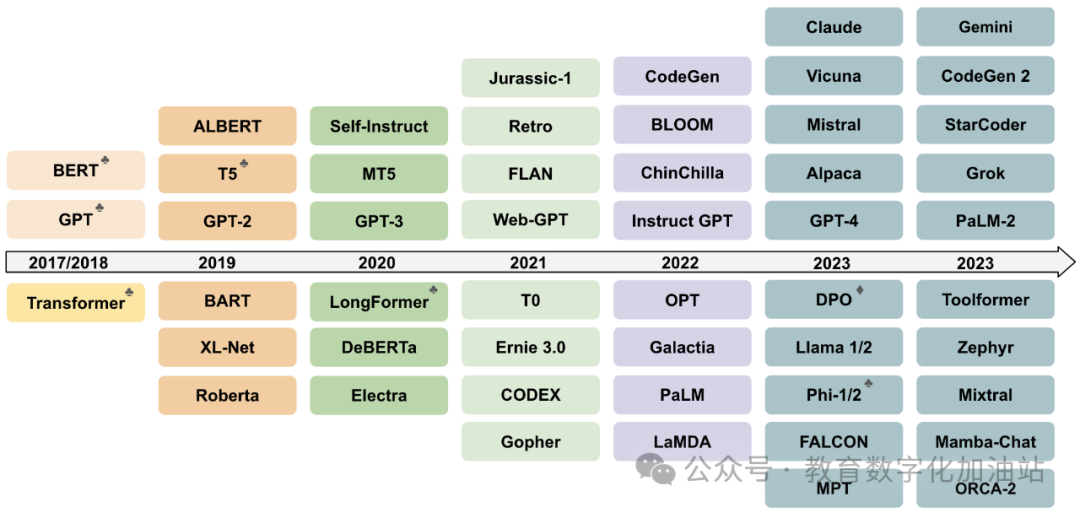

1.1 大型语言模型(LLM)的概念大语言模型(LLM,Large Language Model),也称大型语言模型,是一种旨在理解和生成人类语言的人工智能模型。LLM 通常指包含数百亿(或更多)参数的语言模型,它们在海量的文本数据上进行训练,从而获得对语言深层次的理解。目前,国外的知名 LLM 有 GPT-3.5、GPT-4、PaLM、Claude 和 LLaMA 等,国内的有文心一言、讯飞星火

企业考虑成本和数据隐私问题,会特别希望能在企业内部部署一套大模型,在企业内部直接调用,这样就能成本可控,数据也不会泄露,所以开源大模型是非常有前景的,目前来说Meta开源的Llama3是开源大模型中性能表现最好的,所以这节课先带大家来尝试使用Ollama来部署Llama3和nomic模型。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;这样,ollama的服务端就启动了,就可以接

或 Web 应用程序框架是主要用于发现漏洞的安全扫描器。可以在几乎 Web 应用程序渗透测试中使用 W3af 来快速探测目标网站及其托管服务器。首先,键入“cd w3af.d”打开 W3af 控制台。进入正确的目录后,输入“./w3af_console”打开 w3af.接下来,输入“target”,“set target xxxx”并回车。输入“back”跳转一个目录,配置将被保存。最后,输入“s

LangChain是一个开源框架,旨在帮助人工智能开发者将大语言模型(如GPT-4)与外部计算和数据源结合起来。这个框架提供了Python和JavaScript包,使开发者能够轻松地将自己的数据与大语言模型连接起来,从而实现更复杂的人工智能应用。LangChain的创始人是哈里森·蔡斯和安库什·戈拉,他们于2023年在美国加利福尼亚州创建了这家人工智能公司。哈里森·蔡斯担任首席执行官。

总的来说,大语言模型是一种通过学习大量的文本数据,来理解语言的规律和模式的计算机程序。它通过神经网络算法,来预测和理解新的语言输入。虽然它的理解和预测并不是完全准确的,但是随着技术的不断发展,它的能力也在不断提高。

因此,科研界给这些庞大的语言模型起了个名字,称之为“大语言模型(LLM)”。包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。大语言模型(LLM,Large Language Model),也称大型语言模型,是一种旨在理解和生成人类语言的人工智能模型。大模型的基本开发,相对来说是比较简单的,只需要针对于大模型的一些应用和一些想方法来进行接口接