简介

擅长点云和图像的检测,分割,和目标跟踪等感知算法

擅长的技术栈

可提供的服务

暂无可提供的服务

CUDA Driver 是与 GPU 沟通的驱动级别底层 API,对 Driver API 的理解,有利于理解后续的 Runtime API。CUDA Driver 随显卡驱动发布,需要与 cudatoolkit 分开看,CUDA Driver 对应于 cuda.h 和 libcuda.so。Driver API 主要知识点是 Context 的管理机制 以及 CUDA 系列接口的开发习惯(错误检

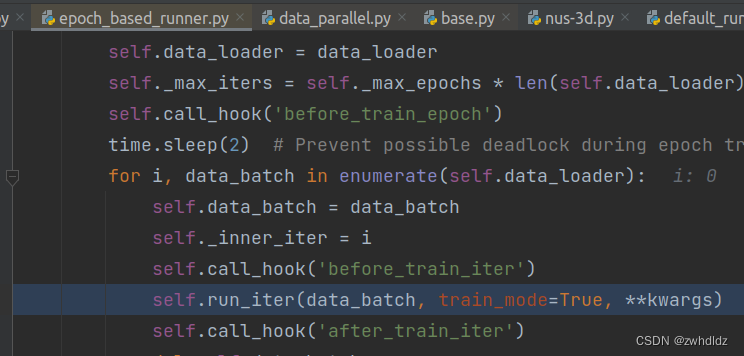

CUDA流:一系列将在GPU上按照顺序执行的操作。可以将一个流看做是GPU上的一个任务,不同任务可以并行执行。如下图所示,利用三个流,同一个流上的任务顺序执行,不同流上的任务可以同时执行,从而实现并发操作。// cuda runtime 头文件。

不同于LSS、BEVDepth的bottom-up式,先进行深度估计,设计2D转3D的模块。DETR3D是一种3D转2D的top-down思路。先预设一系列预测框的查询向量object querys,利用它们生成3D reference point,将这些3D reference point 利用相机参数转换矩阵,投影回2D图像坐标,并根据他们在图像的位置去找到对应的图像特征,用图像特征和obje

多尺度特征图尺寸记录:spatial_shapes:([[180, 180],[ 90,90],[ 45,45],[ 23,23]])sampling_locations原本为采样点位置,范围为[0,1),为了适应F.grid_sample采样函数的用法,调整为[-1,1)分布,意思是,900个query在特征图(32,level_h,level_w)中各采样4个点,采样结果为900个对应的4个通

官方下载地址为https://developer.download.nvidia.cn/compute/cuda/repos/ubuntu1804/x86_64/对应好系统版本和CPU位数,我的电脑用的是Ubuntu 18.04 + x86_64。nvidia-modprobe版本过低,与显卡驱动的版本不匹配导致的。1 下载与显卡驱动一致的nvidia-modprobe。2 安装nvidia-mo