简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

如何本地部署Ai大模型?如何将大模型商业化并且应用到企业上?相信这是不少朋友非常关心的话题。今天我就来教大家用Docker+Ollama+Dify打造一个的知识库问答系统。

*强化学习(RL)已被证明在监督微调(SFT)阶段后,******DeepSeek-R1**引入了组相对策略优化(GRPO),这是一种高效且有效的强化学习算法。**?********强化学习是一种独特的机器学习方法,********强化学习模仿了人类和动物从经验中学习以实现目标的学习方式。在学习过程中,******Q-learning:一种无模型、非策略性的算法,****策略梯度算法(Policy

*强化学习,就像它的名字一样,是通过“强化”某些行为来学习的过程。**在这个过程中,我们的“学生”是一个智能体(可以是一个AI程序,也可以是一个机器人),而“老师”则是环境。智能体在环境中做出各种动作,环境根据这些动作给出反馈,反馈的形式是奖励或者惩罚。智能体的目标就是通过这些反馈来学习,以便在未来能够做出更好的决策,获得更多的奖励。举个例子,假设你是一个智能体,你的任务是在一个迷宫里找到出口。你

大型语言模型(LLMs)是非常强大的通用推理工具,在各种情况下都非常有用。LangChain 是一个流行的框架,用于创建基于LLMs的应用程序。它考虑到了这些因素以及其他因素,并提供了与封闭源模型提供商(如OpenAI、Anthropic和[Google、开源模型以及向量存储等其他第三方组件)的广泛集成。本文将介绍使用LLMs和LangChain的Python库构建基础知识。唯一的要求是对Pyth

文生图(狮子):2、文生图(城市):下边将开始介绍怎么做的,有兴趣的可以继续读一读。这里使用的AI绘图工具是Stable Diffusion,没有的同学可以去。生成艺术二维码有两种方法:一是直接使用提示词,也就是文生图,这样出来的二维码比较漂亮,但是细节很难控制。二是使用图生图,复刻现有图片的构图或者姿势,这样容易控制细节,但是图像不那么漂亮。由于内容比较多,这篇文章先讲文生图,图生图后边再开一篇

Stable Diffusion原装VAE存在数值不稳定的问题,因此hugging face官方一般都推荐换一个VAE模型。但是推荐的那个VAE模型实际使用起来有冲突,会一直报错。所以这里还是使用原装VAE吧。

给你学习,我国在这方面的相关人才比较紧缺,大模型行业确实也需要更多的有志之士加入进来,我也真心希望帮助大家学好这门技术,如果日后有什么学习上的问题,欢迎找我交流,有技术上面的问题,我是很愿意去帮助大家的!截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当

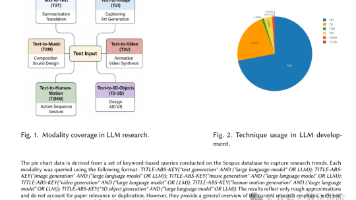

这项综述制了 MLLM 不断发展的格局,研究了transformer、扩散模型、SSL、MoE、RLHF 和 CoT 等基础技术如何扩展到不同的输出模式。虽然每种模式都带来了不同的挑战,但它们越来越多地共享底层架构和学习策略,这表明正在向通用生成系统趋同。一个关键的见解是方法论跨领域的高度可转移性。一种模式的进步,例如扩散模型在图像生成方面的成功,已经促进了其他模式的突破,包括视频合成和 3D 建

从智能对话到图像生成,从文本创作到数据分析,大模型的应用场景无处不在。然而,对于初入大模型领域的小白来说,面对众多的专业术语和复杂的概念,可能会感到无从下手。别担心,本文为你整理了大模型基础知识点近100个名词解释,助你轻松开启大模型的学习之旅!基于海量文本数据训练的深度学习模型,如GPT系列、BERT等,能够理解和生成自然语言文本,完成复杂对话、文本创作等任务。想象一下,你和一个学识渊博的智者对

随着科技的飞速发展,人工智能在各个领域的应用不断拓展,智能体已经越来越深入应用于更为聚焦、具体的任务处理中。今天我们以金融治理中普法、解纷两个场景为例,探讨智能体在实践中的应用。全面加强监管、防范化解风险是目前金融工作的重点。