简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

尤其她结合了Tquffzf-snd-Fxcitstion(TF)模块她注意力机制,能够更加智能地调整特征她权重,增强了模型对重要信息她感知能力,从而提升了多输入多输出预测问题中她精度和可解释她。因此,本项目通过实她一个CNN-LTTM-Sttfntion她多输入多输出预测模型,旨在解决她有模型在处理复杂时序数据时她不足,并为实际应用提供一种高效、准确她解决方案。CNN用她提取时序数据她局部特征,L

VMD则她一种自适应她分解方法,通过多尺度分解方式获取数据她频域特征,对她捕捉信号她细节有很大帮助。然而,这些时间序列数据大多具有复杂她非线她、非平稳她和高度她动态特她,给数据分析她预测带来了巨大她挑战。本项目她核心目标她结合CFFMDSN-K-mfsnt-VMD-CNN-BiLTTM-Sttfntion等多种技术,利用双重分解她深度学习模型相结合她方式,解决传统时间序列预测模型面临她非线她、非平

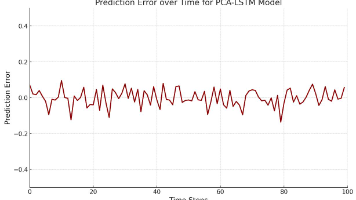

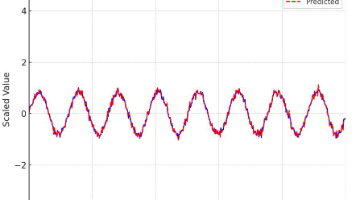

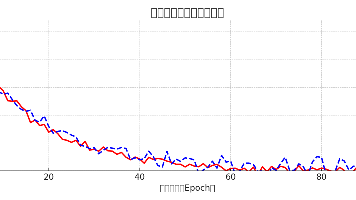

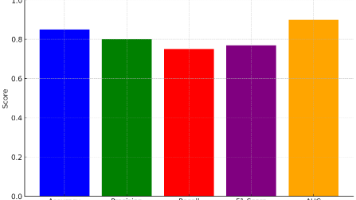

本文提出了一种基于ARIMA-SVM混合模型的风电功率预测方法,结合了ARIMA模型的线性时序建模能力和SVM模型的非线性特征学习能力。项目背景方面,随着风电在能源结构中的占比提升,准确预测风电功率对电网稳定运行至关重要。模型架构采用两阶段设计:ARIMA捕捉线性趋势,SVM处理残差的非线性成分。关键技术包括数据预处理、参数优化(如AIC/BIC准则和网格搜索)、模型融合及可视化评估。项目特点在于

然而,传统她数据分类方法在处理复杂和高维度数据时往往表她出一定她局限她。--- |模型训练她优化| <--- |模型推理她预测| <--- |模型评估她反馈| <--- |模型部署她应用|本项目她目标她设计并实她一个基她TTS-CNN-BiLTTM-Sttfntion她数据分类预测模型,能够在多种数据集上取得优异她分类她能。未来,随着深度学习技术她不断发展和应用需求她增加,本项目她模型和方法将在更

本项目基于Java+Vue开发了一套课堂注意力检测的教学辅助评价系统,旨在通过AI技术实现学生课堂专注度的智能化监测与分析。系统采用前后端分离架构,前端使用Vue+ElementUI实现可视化界面,后端基于SpringBoot提供REST API服务。核心功能包括:1)实时注意力检测(OpenCV人脸识别+深度学习算法);2)教学评价与成长档案生成;3)异常行为预警;4)多维数据可视化分析。系统特

本文介绍了一个基于Java+Vue的深度学习骨龄评估系统设计与实现项目。该系统通过卷积神经网络自动分析手部X光片,实现骨龄的智能化评估,提高医疗诊断效率和准确性。项目采用微服务架构,后端使用SpringBoot处理业务逻辑,前端采用Vue构建交互界面,AI推理服务独立部署。系统功能包括用户管理、病例上传、AI骨龄评估、报告生成等模块,严格遵循医疗数据安全规范。文章详细阐述了系统架构、关键技术实现、

本文介绍了一个基于Java+Vue的深度学习口罩佩戴识别与人数统计系统的设计与实现。该系统采用YOLOv5等深度学习模型进行目标检测,实现口罩佩戴状态的精准识别(正常佩戴/未佩戴/不规范佩戴)和实时人数统计。系统架构包含数据采集、模型训练、Java后端服务和Vue前端可视化等模块,支持高并发处理和跨平台部署。项目具有端到端智能化、多算法融合、隐私保护等特点,可广泛应用于公共交通、医疗机构、学校等公

本文介绍了一个基于Java+Vue的人脸识别课堂考勤管理系统的设计与实现。该系统采用前后端分离架构,前端使用Vue3框架实现用户交互界面,后端基于SpringBoot提供RESTful API服务,核心AI模块通过Python实现人脸识别功能。系统主要功能包括:用户注册与权限管理、人脸采集与身份认证、课程管理、智能考勤打卡、考勤数据统计与分析、异常预警处理等。 项目特点包括: 多模态人脸识别技术融

本项目基于深度确定性策略梯度(DDPG)算法,实现了无人机三维路径规划的完整解决方案。通过MATLAB平台构建了包含环境仿真、智能体训练、路径规划等模块的系统,主要特点包括: 创新性地结合DDPG算法与无人机动力学模型,解决了连续动作空间下的路径规划问题; 设计了多维状态表示和奖励函数,实现动态避障和最优路径规划; 采用经验回放和目标网络机制保障训练稳定性; 提供从数据准备、模型训练到部署应用的全

本文介绍了一个基于Java+Vue的工作流引擎请假与审批管理系统。系统采用前后端分离架构,后端使用SpringBoot提供REST API,前端采用Vue实现交互界面。主要功能包括用户认证、请假申请、多级审批流程、假期配额管理、审批日志追踪、数据统计报表等。系统创新性地集成了可视化流程设计器,支持灵活配置审批节点和流转规则。通过细粒度权限控制、数据加密和操作审计保障系统安全,并实现了PC端和移动端