简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

7.安装驱动,Install 32 bit compatibility libraries?4. 检查禁用nouveau是否生效,输出为空。2. 更新initramfs。1. 禁用nouveau。

网上有很多文章介绍过迁移学习,但TensorFlow2.0的较少,有TensorFlow2.0的,但能说清楚明白的更少。验证码的样本需要自行标记,本文使用的样本大概2000左右。训练集1500,测试集500。本次迁移学习选择的预训练模型为:Xception,是个比较优秀的CNN模型。验证码的特征是带空心字符、有大小写且粘连的验证码。环境使用的是MX350 2G的GPU(使用GPU训练很快)。主要步

你是一个数据可视化专家,根据用户的输入选择合适的可视化工具完成数据可视化展示。1、在插件市场安装AntV Visualization Chart插件。若是图片先输出图片链接地址,然后输出图片。2、创建一个数据库可视化智能体。三体小说人名词云图。

精心设计的提示词就像一把精准的钥匙,能够引导大模型在处理长文本会话时,将注意力集中在与质检紧密相关的重点信息上。无论是客户与客服之间围绕产品细节的多轮详细咨询,还是团队成员在项目协作中对方案的深入探讨,大模型都能如同一位经验丰富的质检专家,细致入微地分析每一句话的含义,判断其是否符合既定的质检标准。而如今,随着人工智能技术的飞速发展,大模型为这一困境带来了全新的解决方案,有望通过提示词交互迭代的方

这两天在网上查找资料进行了各种配置尝试无果,包括修改服务,修改注册表等等,都没有成功,我是通过mac的Parallels Desktop里面运行一个Windows 11 pro(激活后),然后在远程服务器上部署的windows server 2019中文版(将默认自带的远程桌面服务重新安装一下,可以解决远程服务器无法使用本地麦克的问题)。即可让远程服务器使用本地的音频,在远程服务器上显示的是远程音

1、在本地搭建数据库访问的服务,并使用ngrok暴露到公网。2、创建知识库,导入表结构描述。3、创建数据库访问工作流。4、创建数据库智能体。

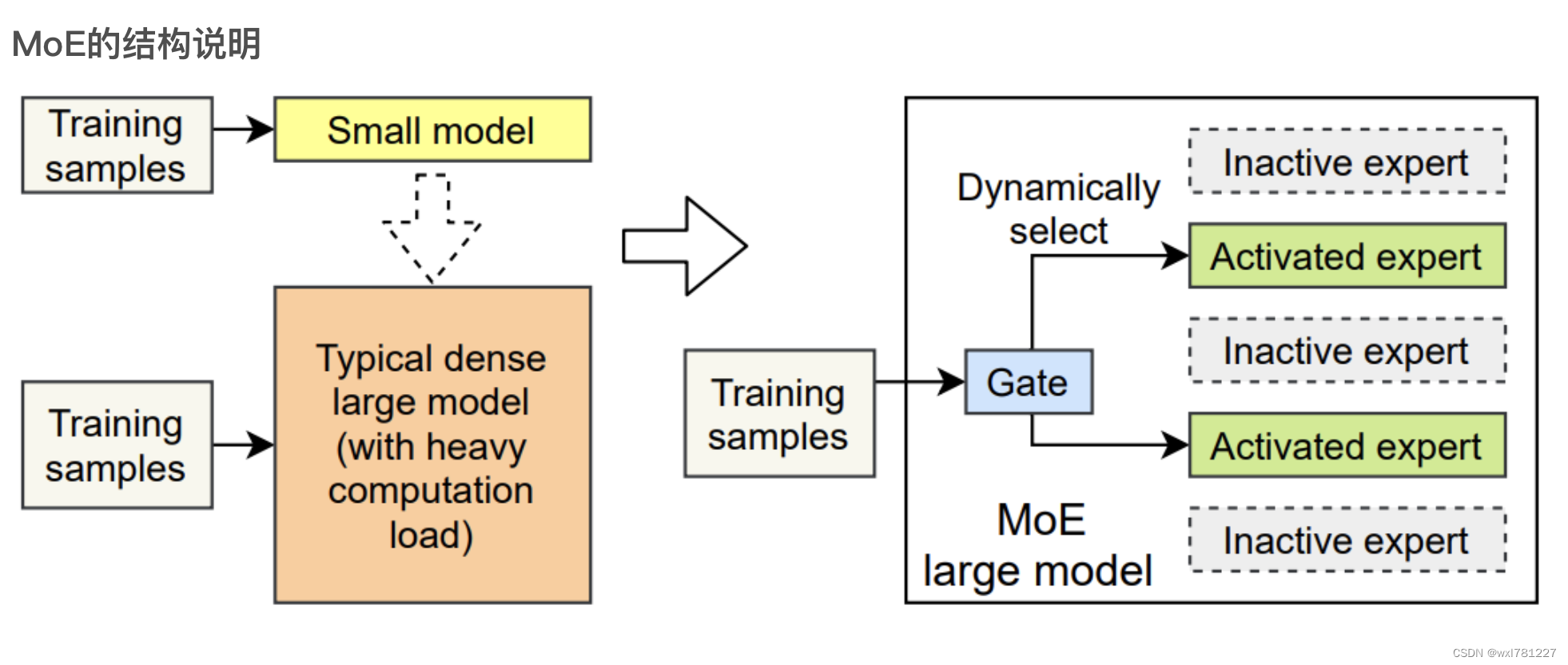

因此就会减少训练的计算量,降低计算所需要的GPU(8B*7的模型,本应该需要56B模型所需的GPU,使用专家模型结构后,装载模型需要47B模型所需的GPU,训练时只需要14B模型的GPU)同时参数是共享的,也会进一步的减少GPU(减少到12B模型的GPU占用)。GPT4和GLaM都是MoE结构的模型,MoE模型并没有解决幻觉的问题,只是在超大的模型上,减少了训练和推理的计算,降低了训练和推理的成本

广义上讲,包括自动驾驶、机器臂、机器人都属于智能体,另外一种是基于流程编排的智能体,如本文所要实现的智能体,流程和技能都是预先设置好的。下面以使用本地ollama模型,基于代理人根据客户个人信息提供风险图谱、风险呈现与法律依据和优先级风险与解决方案的需求做了一次尝试,给出具体的实现过程,希望对你有所帮助。Dify是一个流程编排的工具,支持RAG和Chat聊天,支持对接各种在线大模型和本地大模型接入

Oumi是一个完全开源的平台,可以简化基础模型的整个生命周期——从数据准备和培训到评估和部署。无论您是在笔记本电脑上开发,在集群上启动大规模实验,还是在生产中部署模型,Oumi都能提供您需要的工具和工作流程。🚀使用最先进的技术(SFT、LoRA、QLoRA、DPO等)将模型从10M到405B参数进行训练和微调。🌎在任何地方运行——从笔记本电脑到集群再到云(AWS、Azure、GCP、Lambd

工具:interpreter --local。输出:(输出最基本的结果,并提示进一步优化)输出:(每次输出的结果可能会不一样)2、显示数据文件内容。