简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

前言下载axios库:vue脚手架配置代理服务器:方法一:在vue.config.js中添加如下配置说明:方法二:优点:可以配置多个代理,且可以灵活的控制请求是否走代理缺点:配置略微繁琐,请求资源时必须加前缀下载 vue-resource库:总结:vue项目常用的两个Ajax库:作用:让父组件可以向子组件指定位置插入html结构,也是一种组件间通信方式分类:默认插槽、具名插槽、作用域插槽使用方法:

list 容器,又称双向链表容器,即该容器的底层是以双向链表的形式实现的。这意味着,list 容器中的元素可以分散存储在内存空间里,而不是必须存储在一整块连续的内存空间中。set是一个集合容器,其中所包含的元素是唯一的,集合中的元素按一定的顺序排列。元素插入过程是按排序规则插入,所以不能指定插入位置。set采用红黑树变体的数据结构实现,红黑树属于平衡二叉树。在插入操作和删除操作上比vector快。

随意线索,不随意线索不随意线索:不随着自己的意思,就像上图左边所示,注意力集中在红色杯子;不随意线索:随着自己的意思,带有目的性的,如图右边所示,注意力集中在书本。

【代码】仅用pygame+python实现植物大战僵尸-----完成比完美更重要。

是谷歌在2015年提出,是的进阶版,对于Inception系列网络来说,他是当时第一个在100层卷积网络却依然可以取得好效果的网络(ResNet还没有提出来),相比于更深入得网络结构,在中,包含了48层卷积网络,这可以提取出更多特征,从而获得更好成果;使用分解卷积,将较大的卷积核分解为多个较小的卷积核,在保持良好性能的情况下,依然降低了网络参数量,减少计算复杂度;使用BN层,

它通过展示模型预测结果与实际标签之间的对比,帮助我们理解模型的准确度以及其在不同类别上的表现。其中,与患病相关性比较强的有:MMSE得分、功能评估得分、记忆抱怨、行为问题等相关性比较强,其中,MMSE得分、功能评估得分为负相关,记忆抱怨、行为问题为正相关。而对于多分类问题,混淆矩阵会相应地扩展到NxN的大小(N为类别数量),每一行代表实际类别,每一列代表预测类别。通过发现,由于原本数据中不患病的多

你真的了解ARIMA、AR、MA么?ACF图你会看么?? 时间序列数据如何构造???

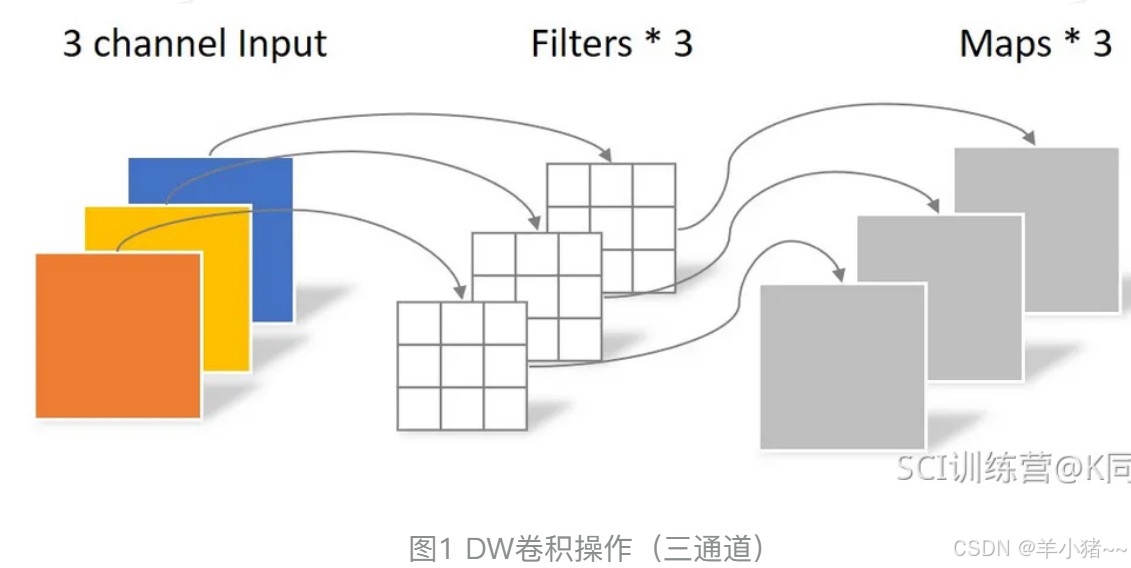

函数原型:输入通道数:输出通道数:卷积层大小stride:卷积步伐大小padding:添加到输入的所有四个边的填充。默认值:0dilation:扩张操作,控制kernel点(卷积核点)的间距,默认值:1。groups:将输入通道分组成多个子组,每个子组使用一组卷积核来处理。默认值为 1,表示不进行分组卷积。:‘zeros’, ‘reflect’, ‘replicate’或’circular’. 默

环境:seaborn绘制热力图的时候,版本需要与matplotlib版本配对,matplotlib版本需要在3.8.0以下随机森林:可以决解多重共线性问题进一步熟悉了数据分析的过程不足:算法的扩展性、数据特征提取没有做。

Bagging集成核心思想:将数据集集随机分为N份,每一份用一个模型求解,最后将所有模型结果进行投票得出结果。自动采样法自动采样法,可以有放回的采样,假设m个样本的数据集,每一次随机拿去一个样本,然后放回,这样就有概率下一次再被选中,经过m次采样,一次大概有百分之63.2%(数学公式推导而出)的数据被选中。数学公式推导:假设每一个样本被选择的概率为 1/m,这样进行m次选择,没有选择的概率为:1