简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

模板:请阅读以下[文本类型,如技术文档/会议记录/客服对话],总结核心要点,要求[具体要求,如重点标注某部分/用列表形式/不超过X字],适配[受众,如程序员/小白]。文本内容:[插入文本]。示例:请阅读以下Python技术文档片段,总结核心要点,要求重点标注requests库的post请求使用方法,用列表形式呈现,不超过3点,适配小白程序员。文本内容:[插入requests库post请求相关文档]

定义状态和规划步骤的目的在于指导任务执行。通过PlanExecute类存储任务的输入、计划、过往步骤和响应,提供任务执行的完整状态记录。Plan类则用于描述未来要执行的计划,明确按顺序排列的步骤。此外,创建了planner_prompt提示模板,用于生成简单、逐步且独立的任务计划,确保每一步包含必要信息,最终直接得出答案。# 定义一个TYpeDict类 PlanExecute , 用于存储输入、计

六周的时间不长,但如果你认真完成每一个环节,你将具备在AI时代立足的核心能力。更重要的是,你会培养出一种思维方式:面对新技术时不是盲目跟风,而是理解其本质,掌握其规律。在学习过程中,我强烈建议你掌握AI辅助编程工具,Cursor是目前的首选。作为一个深度集成了AI能力的代码编辑器,Cursor能够理解你的意图,帮你快速写出高质量代码,特别是在实现复杂的大模型相关项目时,它能够显著提升你的开发效率。

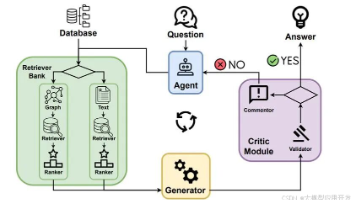

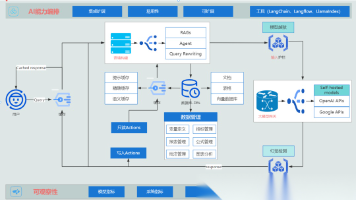

需要告诉编排器您的系统使用哪些组件,例如模型(包括用于生成、路由和评分的模型)、系统可以从中检索数据的数据库以及系统可以采取的操作。与模型网关直接集成可以帮助简化模型入门,并且一些编排器工具希望成为网关。许多编排器还支持与评估和监控工具集成。

当下的AI行业堪称“群雄逐鹿”,ChatGPT、DeepSeek、扣子、豆包等各类大模型工具轮番登场,直接打破了传统职场的固有规则,重塑了职场人的核心竞争力边界!这种职场变革,主要体现在两个核心层面,每一个都和我们的职业发展息息相关:一方面,求职者的核心要求已经彻底升级——“会用AI”早已不是加分项,而是所有岗位的标配能力。

AI大模型时代,技术迭代速度越来越快,对于Java程序员而言,“固守原有技能”只会逐渐被淘汰,掌握大模型技术,实现转型,是提升职业竞争力、抓住时代机遇的关键。转型不用急于求成,按照“夯实基础→掌握工具→升级能力→实战落地”的步骤,充分发挥Java程序员的工程化优势,循序渐进,就能逐步切入大模型领域。

某互联网大厂十年技术主管,在内部核心工作群突然爆料:公司已正式启动“生存式裁员”计划,核心产研团队最终仅保留30%的人员!据透露,HR早已提前核算好所有赔偿金额,沟通流程简单直接——当场面谈、当场确认、当场签字走人,全程不拖泥带水。消息一经传出,数百人的技术交流群瞬间炸开了锅,议论声此起彼伏。最让人揪心的是,此次裁员并非只针对边缘岗位,就连以往被视为“铁饭碗”的核心研发岗,也没能逃过这场裁员浪潮,

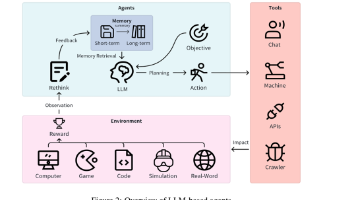

智能体简单来说,就是能从周围环境中获取信息(感知),并主动执行动作、完成任务的“智能实体”,是我们实现人工通用智能(AGI)的核心突破口。其核心特征有4点,小白记牢这4点就能快速理解:① 自主性(不用人工全程操控,能独立做决策);② 感知能力(像人一样“看、听”,通过传感器等采集环境信息);③ 决策能力(基于感知到的信息,判断该做什么动作);④ 动作能力(能执行决策,改变环境状态,比如调用工具、输

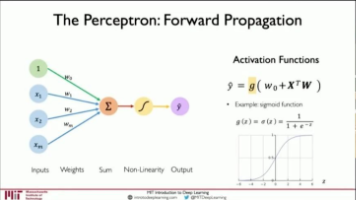

*「微调(Fine-tuning)」**是给大模型提供特定领域的标注数据集,对预训练的模型参数进行微小的调整,使其更好地完成特定任务。通过微调,可以显著提升模型在特定任务上的性能。通用大模型:类似于中小学生,具有广泛的基础知识,但缺乏专业性。行业大模型:基于特定行业的数据集进行微调。如金融证券大模型通过基于金融证券数据集的微调,可以得到一个专门用于金融分析和预测的大模型。这相当于大学本科生,具备了

什么是AI Agent?对于小白而言,不用死记复杂定义,简单理解为——它是一个“有自主意识”的软件程序,能自己感知环境、做决策、执行操作,最终帮你达成指定目标。和我们平时用的“输入指令才响应”的传统AI(比如简单聊天机器人)相比,AI Agent最大的优势就是“自主性”,不用你一步步指挥。对程序员来说,核心定位更明确:AI Agent是以大型语言模型(LLM)为核心驱动,能够自主规划、拆解并执行多