简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了jupyterlab的安装和配置。

RAG技术通过结合检索与生成能力,解决了传统大语言模型在专业知识和最新信息上的局限性。本文介绍了NaiveRAG的三个核心步骤:1)知识库准备(文档分块和向量化);2)问题检索(相似度匹配);3)答案生成(结合检索内容)。文章提供了Python实现代码,包含文档处理器、向量存储和主控制器模块,并演示了实际应用示例。NaiveRAG具有实现简单、成本低廉等优点,但也存在检索质量依赖简单向量相似度、无

本文详细介绍了GraphRAG系统,这是一种将知识图谱与RAG框架结合的创新方法。传统RAG在处理多跳推理和深层关系时存在局限,GraphRAG通过结构化知识存储、多跳推理能力和可解释的推理路径解决了这些问题。文章系统阐述了GraphRAG的工作原理,包括知识图谱构建、查询理解与子图检索、图推理与答案生成三个阶段。完整展示了从实体关系抽取到知识图谱构建,再到子图检索和答案生成的实现代码。

使用WSL2+docker+oneapi成功部署fastGPT

本文进一步记录了千问模型的函数调用功能使用方法,大家可以一起学习交流~

这段时间在自己的Win11系统上部署了chatGLM以及Qwen模型,进行对话、推理以及工具调用都没有问题,但是在尝试进行微调的时候发现好像并不能成功,因此花费了很大的力气,又分别在ubuntu桌面版、windows子系统WSL2 Ubuntu上部署了Qwen模型,并尝试进行LoRA的微调实践。由于过程比较多,步骤较为繁琐,我可能会分几个部分进行叙述。首先介绍一下我的两个环境(平民玩家,勿喷):一

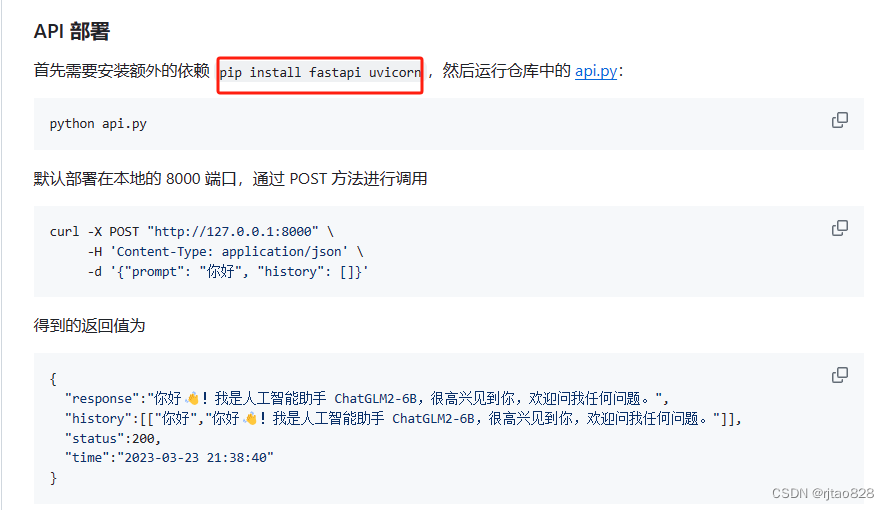

本文记录了采用api的方式访问本地chatGLM2-6B的方法

本文介绍了jupyterlab的安装和配置。

虚拟机安装好麒麟系统后,无法设置到合适的分辨率,窗口无法随着虚拟机窗口的大小改变而改变,可以通过安装VMware tools解决。然而网上大部分的解决办法是通过虚拟机设置:->虚拟机(M)->安装VMware tools,这在应用于麒麟系统时不可取。因为“安装VMware tools”是灰色状态的,不可选。通过网上找到一个教程如下:虚拟机版本:VMwareworkstation16.2