简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

3、获取CPU序列号或者主板序列号。1、获取CPU ID。2、显示当前硬件信息。5、获取BIOS信息。8、显示当前内存大小。

摘要: HashMap在JDK1.7使用数组+链表实现,1.8优化为链表长度超过8时转为红黑树,提升查询效率至O(logn)。ConcurrentHashMap在1.7采用分段锁技术,1.8改为更细粒度的锁机制结合CAS操作保证线程安全。synchronized和ReentrantLock的主要区别在于锁的获取方式、公平性及响应中断能力。JVM垃圾回收中,MinorGC处理新生代,FullGC清理

数据分析不再是难题!跟DeepSeek一起,让数据说话,让分析更轻松!

关联分析是在大规模数据集中寻找有趣关系的任务。这些关系主要呈现为两种形式:频繁项集和关联规则。频繁项集是经常出现在一块儿的物品的集合,比如在电商购物数据中,购买了手机的用户往往也会同时购买手机壳和充电器,那么手机、手机壳和充电器就构成了一个频繁项集。关联规则则暗示两种物品之间可能存在很强的关系,例如在超市销售数据中,如果发现购买啤酒的顾客中有很大比例也会购买尿布,就可以得出 “购买啤酒→购买尿布”

大模型在网络安全领域的应用已从理论探索迈向初步落地,尤其在威胁检测、漏洞挖掘等场景成效显著。未来,随着多模态大模型与边缘计算的发展,网络安全防护将向“预测-防御-自治”闭环演进,进一步缩小攻防信息差。:恶意代码呈现模块化、跨平台传播特征,需结合大模型动态更新检测规则。:安全编排自动化(SOAR)成为主流,但需持续优化剧本覆盖场景。:动态策略管理成熟度达L2级,已集成到防火墙、IPS等设备。:攻击溯

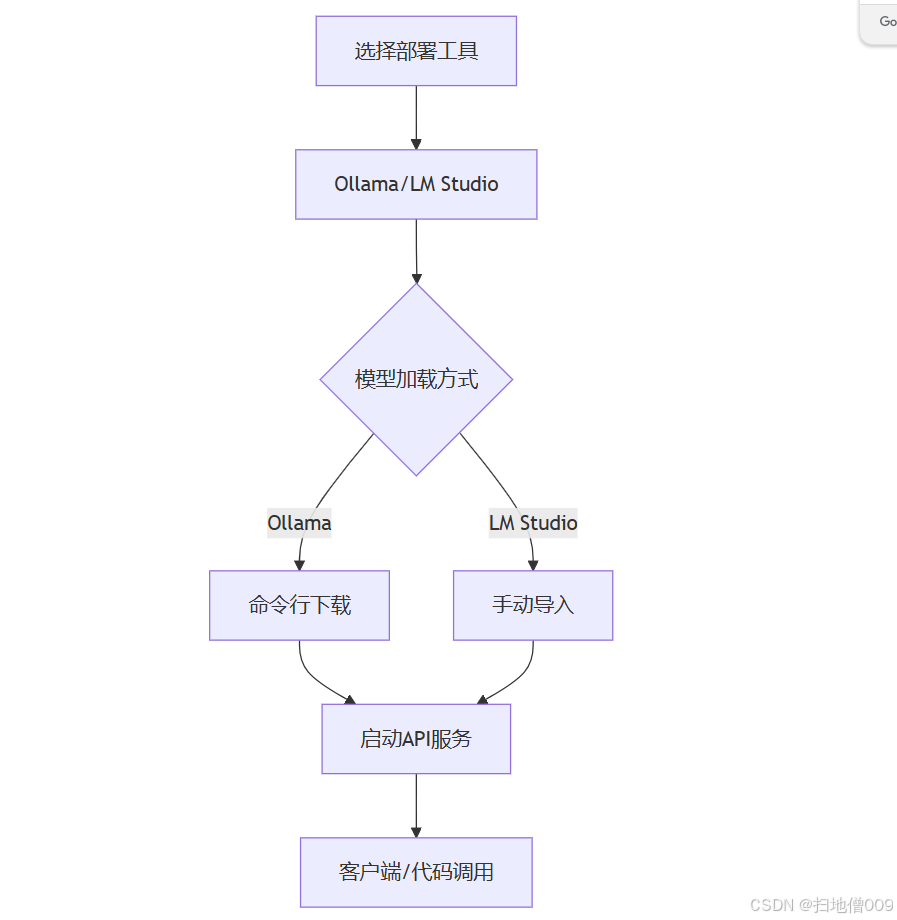

通过以上流程,可在10分钟内完成本地部署并实现API调用,满足私有化场景的智能化需求12。库,支持文本补全、对话生成等任务23。

随着AI应用的普及,越来越多的开发者需要在本地环境部署智能模型。本文将详细介绍如何在本地机器上部署DeepSeek模型,并提供完整的配置指南和优化建议。通过本文的指导,您已经成功在本地部署了DeepSeek模型。建议定期关注官方GitHub仓库获取最新更新,也欢迎在评论区分享您的部署经验!DeepSeek官方部署文档GitHub示例项目。

大模型在网络安全领域的应用已从理论探索迈向初步落地,尤其在威胁检测、漏洞挖掘等场景成效显著。未来,随着多模态大模型与边缘计算的发展,网络安全防护将向“预测-防御-自治”闭环演进,进一步缩小攻防信息差。:恶意代码呈现模块化、跨平台传播特征,需结合大模型动态更新检测规则。:安全编排自动化(SOAR)成为主流,但需持续优化剧本覆盖场景。:动态策略管理成熟度达L2级,已集成到防火墙、IPS等设备。:攻击溯

⽬前主流GPU⼤模型推理与训练性能⽐较。

deepseek 避坑指南:实时演练:场景演练: