简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

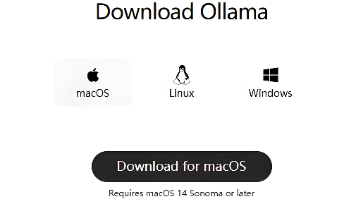

《macOS上零配置运行本地AI模型指南》介绍了使用Ollama在Mac电脑上快速部署Llama3、DeepSeek等大语言模型的方法。文章详细讲解了两种安装方式(官方脚本和Homebrew)、模型管理命令,并针对不同Mac硬件配置提供了模型选择建议。此外,还介绍了图形界面(Open WebUI)和API调用等进阶用法,包括Python集成示例。指南涵盖从基础安装到故障排除的全流程,帮助用户安全高

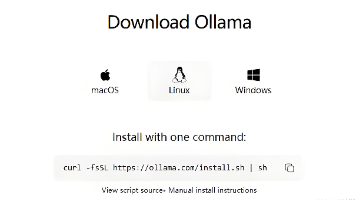

本文详细介绍了在Linux系统上安装和使用Ollama大语言模型平台的完整指南。主要内容包括:安装前的系统要求检查、两种安装方式(自动脚本安装和手动定制安装)、基本使用方法(模型下载运行和管理)、以及进阶应用(REST API调用、Python集成、Docker部署和Web图形界面)。文章还提供了常见问题解决方案和性能优化建议,帮助用户从零开始搭建本地大模型平台,适用于不同技术水平的开发者。

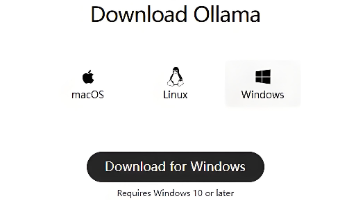

Ollama Windows 安装使用指南 Ollama 是一个开源工具,支持在 Windows 本地运行 Llama、DeepSeek 等大语言模型。安装方式包括官方安装包(推荐新手)和命令行脚本两种。安装后通过 ollama run 命令即可启动模型交互,支持模型管理(list/pull/rm)和状态查看(ps)。根据硬件配置可选不同规模模型(如8GB内存建议7B参数模型)。进阶功能包括: A

本文介绍了在Ubuntu 22.04系统上本地部署大语言模型并进行训练,最终通过API对外提供服务的完整方案。主要包括:1)硬件配置评估,建议16GB显存GPU适合7B参数模型的微调训练;2)环境搭建步骤,包括创建隔离环境、安装PyTorch和训练框架;3)三种模型处理路径,重点推荐基于LoRA的微调方案以节省显存;4)API服务封装方案,提供FastAPI和FastChat两种实现方式。该方案特

Ollama 是一个开源的大型语言模型(LLM)运行框架,它能让你非常方便地在本地计算机上部署和运行各种主流大模型,无需复杂的配置即可享受 AI 对话、内容生成等能力,并确保数据的私密性。下面这份全面指南将带你完成从安装到使用的每一步。

本文详细介绍了在Windows 11系统下部署大模型训练及API服务的完整方案。针对Windows平台特性,重点对比了WSL2(推荐)和原生Windows两种部署路径,提供详细的WSL2环境配置指南、GPU驱动安装说明及CUDA环境搭建步骤。文章包含Python环境配置、模型训练/微调示例代码,并特别说明Windows平台下的API服务封装技巧和网络暴露配置方法。通过清晰的流程图和步骤说明,帮助开

针对 10k FPS 吞吐量需求的 GPU 服务器集群(NVIDIA DGX) + Edge TPU 边缘节点协同部署 方案

TensorFlow 模型部署的 Docker 配置与性能调优细节的深入指南,涵盖容器化部署、硬件加速、内存优化及监控策略,适合生产环境实践

针对 激光雷达点云处理 的 极端场景优化方案,结合 模型并行化(多 GPU) 和 Edge TPU 加速,实现 亚毫秒级延迟(<5ms)的实时处理。方案涵盖硬件选型、模型优化、分布式训练与部署策略

GitOps 实现持续交付流水线的完整指南,涵盖核心概念、工具链配置、实战场景及常见问题解决方案!