简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

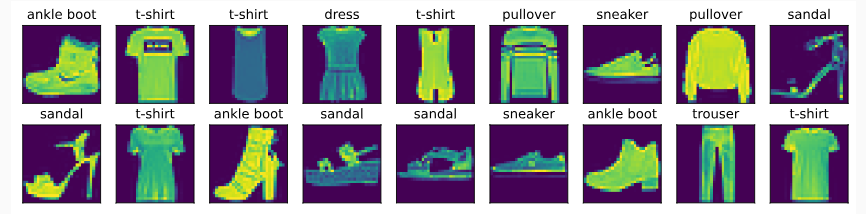

Fashion-MNIST中包含的10个类别,分别为t-shirt(T恤)、trouser(裤子)、pullover(套衫)、dress(连衣裙)、coat(外套)、sandal(凉鞋)、shirt(衬衫)、sneaker(运动鞋)、bag(包)和ankle boot(短靴)。Fashion-MNIST由10个类别的图像组成, 每个类别由训练数据集(train dataset)中的6000张图像

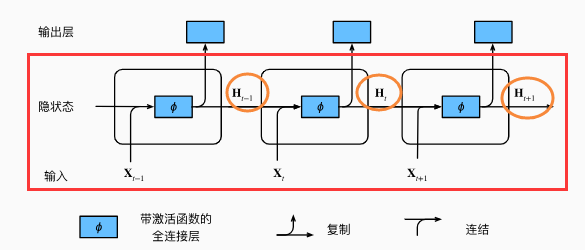

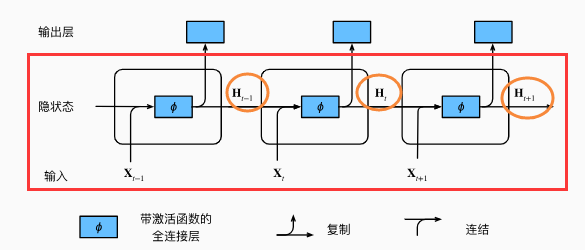

使用简单的代码来说明一下,定义矩阵X、W_xh、H和W_hh,它们的形状分别为(3, 1)、(1, 4)、(3, 4)和(4, 4)。沿列(轴1)进行拼接X和H,沿行(轴0)拼接矩阵W_xh和W_hh,两个拼接分别产生形状(3,5)、(5,4)的矩阵,相乘为(3,4)的矩阵。定义init_rnn_state函数在初始化时返回隐状态,该函数的返回是一个张量,张量全用0填充,形状为(批量大小,隐藏单元

重新安装Anaconda失败,显示Failed to link extracted packages to D:\Anaconda\anaconda3。C盘——>用户——>admin(用户名)——>.condarc。,这个文件是你之前配置镜像源所用到的文件。1、C盘,进入用户文件夹。2、点击你创建的用户。

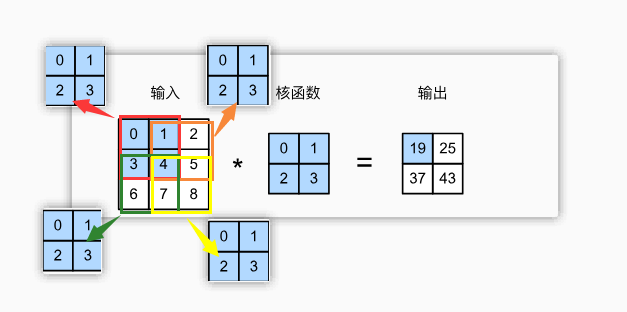

通过逐渐聚合信息,生成越来越粗糙的映射,最终实现学习全局表示的目标,同时将卷积图层的所有优势保留在中间层。当输入包含多个通道时,需要构造一个与输入数据具有相同输入通道数的卷积核,以便与输入数据进行互相关运算。汇聚层与卷积层的原理大体相似,只不过把互相关运算换成求最大值或者求平均值。(padding):在输入图像的边界填充元素(通常填充元素是0)不同颜色所选的区域与同一个卷积核做互相关运算,最后得到

在使用 YOLOv8 进行训练时,默认的优化器是 SGD(Stochastic Gradient Descent),可以通过命令行参数或代码修改优化器为 Adam。我训练自己的数据集大概标注了10来张,前面训练的时候P、R、mAP也为0,到后面才开始增长的。在修改数据集后,若之前训练过,在训练前删除这两个train.cache和val.cache。使用YOLOv8训练自己的数据集时,出现P、R、m

在自己想用yolo训练自己的数据集时,有时候会自己标注10来张图片进行测试,但训练100个epoch各项数据仍然为0,这时就会怀疑是否是自己的数据量不够,还是模型错误,还是哪个步骤没弄对,这里有一个简单的排除方法,可以测试自己的数据质量是否达标。,重复2次及以上,至少就有30几张图片和标签了,然后再次训练,这时候P、R、mAP都有值,但很小。所以你就需要考虑数据质量的问题了,搜集不同的图片进行标注

库实现,如果没有需要在命令行执行。

使用简单的代码来说明一下,定义矩阵X、W_xh、H和W_hh,它们的形状分别为(3, 1)、(1, 4)、(3, 4)和(4, 4)。沿列(轴1)进行拼接X和H,沿行(轴0)拼接矩阵W_xh和W_hh,两个拼接分别产生形状(3,5)、(5,4)的矩阵,相乘为(3,4)的矩阵。定义init_rnn_state函数在初始化时返回隐状态,该函数的返回是一个张量,张量全用0填充,形状为(批量大小,隐藏单元

部分初始化的模块 "pandas "没有属性 “core”(很可能是循环导入造成的):关闭所有的jupyter notebook,并。

在Linux命令行输入该命令,下载成功且速度快。只能下载小文件,大文件需要用到。选中数据集→右键共享→复制链接。注意:在Linux命令行进行。,替换下面的链接中的。