简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了在昇腾NPU上高效运行大语言模型的实践方案。通过vLLMAscend插件实现昇腾NPU与vLLM框架的无缝对接,结合MindIETurbo加速套件,可在Atlas800TA2训练卡上实现高效推理。文章详细说明了从环境配置、模型下载到推理优化的完整流程,包括Python环境搭建、模型加载、推理参数设置等关键步骤,并提供了性能优化建议和常见问题解决方案。重点强调了输入控制、显存管理和稳定性保

package]name = "my-awesome-lib" # 修改为你的库名version = "0.1.0" # 设置初始版本description = "一个很棒的仓颉库" # 描述你的库cjc-version = "1.0.3" # 根据需要调整编译器版本output-type = "static_library" # 通常三方库设置为 static_library 或 dynamic

本文基于开源项目 gcoord4cj,总结一套从 0 到 1 的仓颉(Cangjie)三方库开发流程:工程化、API 设计、实现细节、单元测试、文档规范与发布建议。读者可直接参考本文在自己项目中落地实践。

综上所述,亮数据的网页抓取工具凭借全面的特性和高可用性,为开发者提供了一站式的爬虫解决方案。**实际使用中,我们体验到开发效率显著提升,很多繁琐的反爬对策都由平台自动完成**。它解决了传统爬虫中常见的 **IP 封锁、反爬墙、复杂结构解析** 等难题,同时保持高度的扩展性和合规性。对于需要快速构建训练数据管道和开展数据驱动业务的团队来说,Bright Data Web Scraper 是一个值得尝

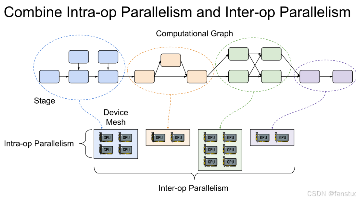

摘要:算子作为AI模型的"发动机",是深度学习落地的关键因素。文章指出,看似高大上的模型本质是由无数底层算子组成的流水线,算子将抽象指令翻译成硬件可执行的具体操作。通过实际案例展示了算子优化如何在不改变模型结构的情况下显著提升性能(280ms→80ms)。在大模型时代,FlashAttention等算子级创新已成为性能突破的核心。文章强调,理解算子对于解决跨平台部署、性能优化等

> 真正让我们愿意信任 AI 的,是在赛题刚发布时,它比我们更冷静。我们参加的是 2023 年 MCM 比赛,当时拿到的题目是关于**多地点服务设施的最优选址问题**(E 题)。刚看完题目的时候,我们脑子里全是关键词:- 多目标优化?NP 难问题?- 该不该建模成线性规划?还是遗传算法?- 这是不是那个 Facility Location Problem 的改版?但是经验告诉我们,一旦直接跳模型,

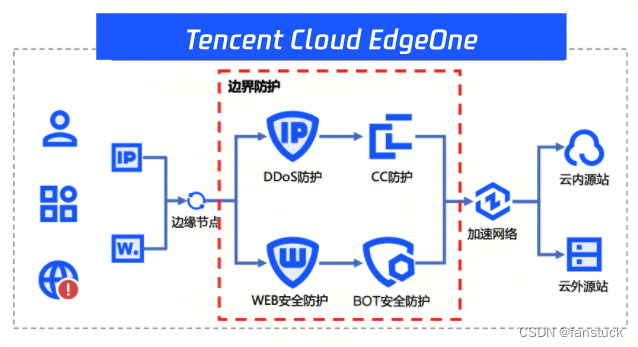

自己感觉难受不说,网站稍微有点要出头的时候,数不清的访问攻击就接踵而至:恶意软件、SQL注入、网站挟持、钓鱼攻击、跨站脚本攻击、恶意爬虫等等,让个人开发者甚为揪心,如果是企业网站的话,攻势有过之无不及。同时,与当前市面上的安全产品多采取(保底+弹性)的计费方式:流量包含业务流量+攻击流量不同,EO的流量计费均为干净流量(即经防护过的流量)是正常的业务流量,不会产生非预期账单,方便企业进行预算管理,

随着深度学习模型开源趋势加速,学生和独立开发者越来越关注 AI 模型的部署问题:模型部署到底需要什么配置?云服务器的带宽、内存、存储究竟对模型推理性能有多大影响?这篇文章将围绕这些核心技术问题展开分析,并结合提供的香港轻量云服务和免费套餐,系统性地说明如何用最低成本完成一个 AI 服务的上线部署。

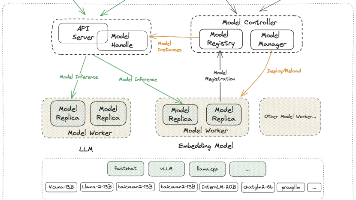

本文介绍了从零构建企业智能体平台openJiuwen的实战经验。作者指出,当前大模型应用中最大的挑战不是模型能力,而是缺少管理智能体的工程平台。openJiuwen定位为Agent运行与编排的中间层,包含开发设计(Studio)、运行核心(Core)和运维治理(Ops)三大模块。文章详细阐述了平台架构设计思想,并提供了Windows环境下的部署指南,包括Milvus向量数据库的安装配置。该平台强调

总而言之,针对机器学习训练任务选择适当的云服务器配置,对初创企业来说是平衡效率、成本和未来扩展的关键举措。通过分析任务规模和资源瓶颈,团队可以确定所需的 vCPU 核数、内存容量、GPU 数量、网络带宽以及存储方案,从而以最小的投入获得满足训练需求的性能表现。同时,充分利用亚马逊云科技等领先云平台的工具(如 SageMaker、CloudWatch)和优惠政策,可进一步降低探索 AI 创新的门槛。