简介

首个存内计算开发者社区,基于知存科技领先的存内技术,涵盖最丰富的存内计算内容,以存内技术为核心,史无前例的技术开源内容,囊括云/边/端侧商业化应用解析以及新技术趋势洞察等, 邀请业内大咖定期举办线下存内workshop,实战演练体验前沿架构;从理论到实践,做为最佳窗口,存内计算让你触手可及。传送门:https://bbs.csdn.net/forums/computinginmemory?category=10003;

擅长的技术栈

可提供的服务

暂无可提供的服务

"芯际觉醒"南京站活动聚焦存内计算技术突破与AI生态构建,于2025年9月7日在南京阿里中心举行。活动汇聚高校学者、芯片专家与开发者,展示了存算一体领域三大前沿实践,实测能效比超7nmGPU十倍。现场达成多项产学研合作意向,并设置AR体验等互动环节。专家分享环节涵盖存算一体技术发展、AR应用及大模型创新,推动南京本地AI技术生态发展。活动作为"算力跃迁"系列首站,后续将在北上广深等城市继续开展,促

近日火爆科技圈,对决Open AI登顶海外App下载量第一的科技新秀Deepseek,引发媒体关注。在海内外一众大模型公司中为何脱颖而出,本博文展开深度解析。DeepSeek-V3是由中国公司深度求索(DeepSeek)开发的一款先进的大规模语言模型。用户可以通过官方网站进行注册和使用,注册过程简单便捷,仅需手机号即可完成。DeepSeek-V3在训练效率、成本控制、评测表现以及高并发支持等方面展

技术融合推动人机共生新时代:从存算一体架构突破算力瓶颈,到空间计算重构数字交互体验,再到AIGC赋能内容创作,技术正加速重塑人机关系。清华大学"视觉算力生态革新技术工坊"揭示了三个关键趋势:存算一体开发者社区构建产学研生态,推动下一代计算架构落地;空间计算使数字生命具备触感交互能力;AIGC重构艺术创作流程。这些技术突破的共同指向是:人类将从"技术操作者"进

大语言模型(LLMs)的快速规模化暴露了当前硬件架构在内存容量、计算效率、互联带宽的瓶颈。DeepSeek-V3通过硬件感知的模型协同设计,在2048块NVIDIA H800 GPU上实现了低成本大规模训练与推理。随着集群规模的指数级增长,硬件的鲁棒性与可靠性对于大模型将愈加重要。

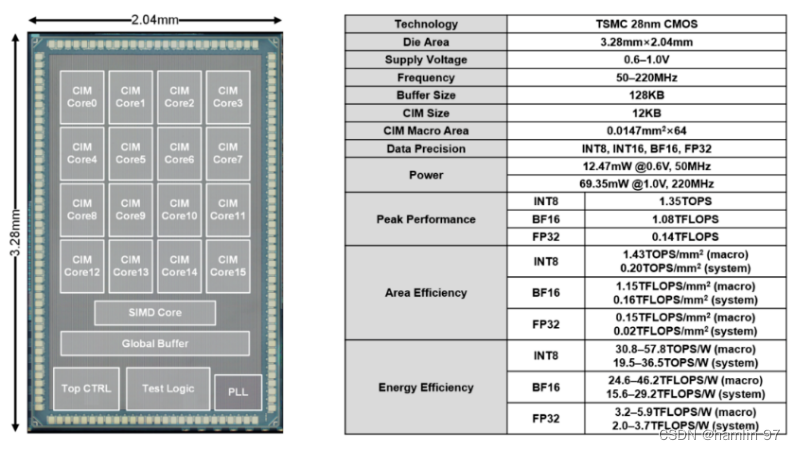

2023年9月14日,清华大学吴华强及高滨共同通讯在Science在线发表题为“Edge learning using a fully integrated neuro-inspired memristor chip”的研究论文,论文显示,团队基于存内计算范式,研制出全系统集成、支持高效片上学习(机器学习能在硬件端直接完成)的存内计算芯片。针对AI时代的新技术的方向,基于存储器运行计算的新型架构模

随着大数据和数据经济的不断发展,海量数据的收集、存储、分析都需要大量的人力物力,其对芯片算力的需求不断增长,而传统冯﹒诺依曼架构已无法支持当今大数据算力需求,因此新型存内计算架构作为一种解决方案被提出。数据经济是指以数据为核心资源,通过数据的收集、分析和应用,创造经济价值的一种经济形态。存内计算,将存储器和计算单元集成在一起,旨在使芯片计算单元兼具存储数据、处理数据的能力,计算单元可以通过极低的开

当数据洪流遭遇算力瓶颈,存算一体技术正以破局者之姿重构 AI 硬件的未来图景。今天,国内首个聚焦存算一体技术的开发者生态阵地 ——存算一体开发者社区正式上线!这里不仅是技术研发的前沿阵地,更是构建「技术研发 - 产学研协同 - 人才成长」全链路生态的核心枢纽,邀你一同在算力革命的浪潮中抢占开发新坐标!

多Agent模式背后的算力需求通常较高,因为需要同时处理来自多个智能体的任务和数据。存内计算作为一种新兴的计算架构,能够在存储器阵列内完成逻辑运算,避免存储器和处理器之间频繁的数据搬移操作,从而提升算力,降低功耗。

由于笔者能力有限,可能未罗列全所有存算企业的优秀产品,列举的可能也并非该企业的最新产品,因为企业往往只会公开产品发布时间点对其有利的部分数据,部分以提升倍数表示的数据无法转化为具体数值,未公开的数据用“-”表示,数据带有宣传性质,请酌情采信。基于知存科技的存内计算技术,积累了全球化的用户经验和需求,具有低功耗、高算力、多应用的三大优势,可助力智能可穿戴设备实现产品体验升级,实现多元化和差异化的应用

【活动预告】9月13日,存算一体开发者社区联合清华大学学生创客空间协会举办视觉计算生态革新主题工坊,聚焦智能眼镜、多模态模型等前沿技术。活动亮点:1)跨界对话:涵盖艺术创作、芯片架构、智能设备全产业链;2)实战干货:探讨存算一体突破、数字IP进化、AR开发等落地议题;3)前瞻视角:解析视觉计算的指数级算力需求与存内计算解决方案。适合开发者、硬科技爱好者及创意工作者参与,共同探索视觉技术的未来边界。