简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

SpringBoot分布式锁自定义注解处理幂等性

SpringBoot自定义注解+分布式锁+接口幂等性

Mac下使用homebrew管理多版本mysql同时启动

给每个版本分配不同的数据目录和配置文件即可本文尝试了使用 brew 安装管理多个MySQL版本,同时运行、直接切换。

Java-springboot集成+drools规则引擎集成,动态化编程

Java-springboot集成+drools规则引擎集成,可以通过界面化大的方式动态化编程

Spring/SpringBoot/SpringCloud Mybatis 执行流程

在后续分析Mybatis 流程中代码的可能会用到IDEA debug 技巧:回到上一步:Java动态代理实现 InvocationHandler接口:mybatis 核心FactoryBeanMapperScannerRegistrar实现了ImportBeanDefinitionRegistrar 接口。 可以自动注入MapperScannerConfigurer 实现 BeanDefiniti

MySQL中的insert ignore into 和 insert into 使用方式

MySQL中的insert ignore into 和 insert into 使用方式

Redis 大key和热key问题及处理

redis大key和热key问题及处理

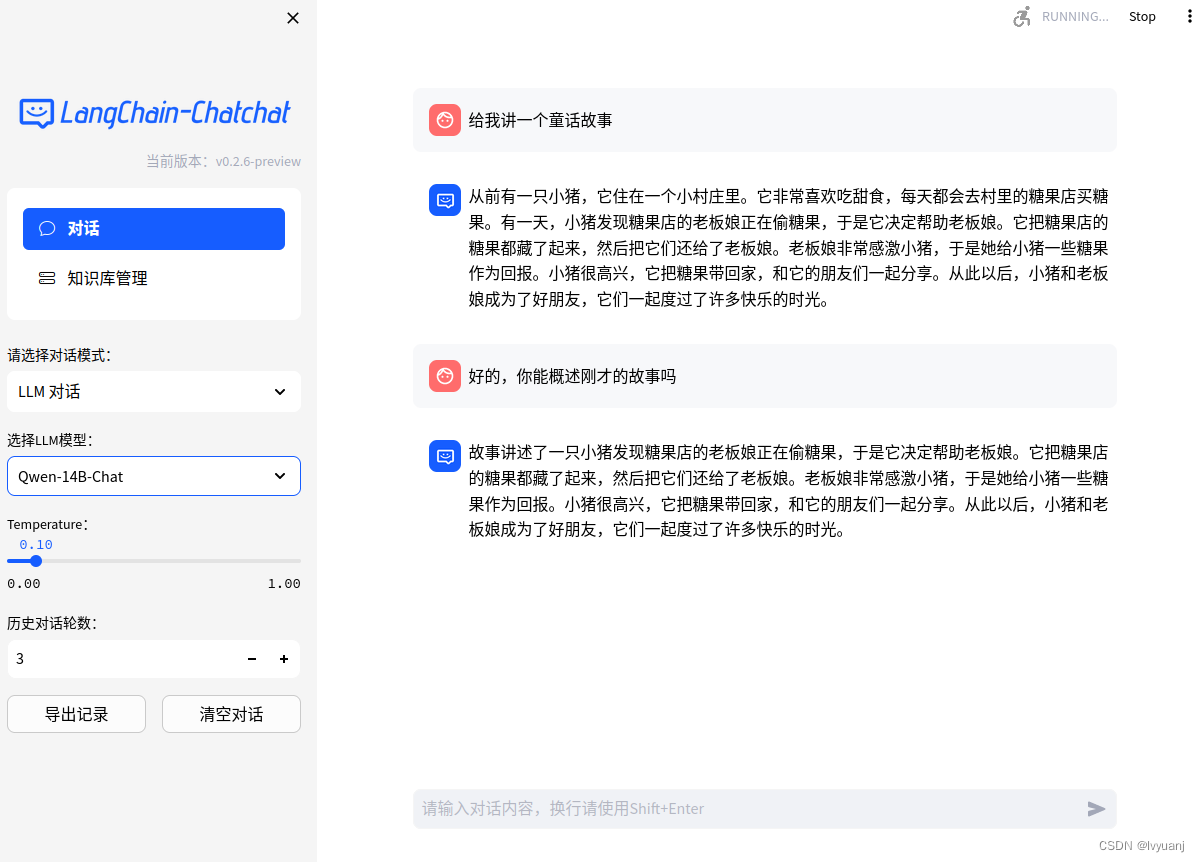

AI大模型-搭建 Langchain-Chatchat 详细过程

基于 ChatGLM 等大语言模型与 Langchain 等应用框架实现,开源、可离线部署的检索增强生成(RAG)大模型知识库项目。

Java-JVM 虚拟机原理调优实战

java jvm 调优

到底了