简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要:NVIDIA Alpamayo自动驾驶生态系统 NVIDIA推出的Alpamayo生态系统为构建具备推理能力的自动驾驶系统提供了完整解决方案。该系统包含三大核心组件:Alpamayo 1(100亿参数VLA推理模型)、Physical AI AV数据集(全球最大开放自动驾驶数据集)和AlpaSim仿真平台(开源闭环评估工具)。Alpamayo 1通过Transformer架构实现多模态感知和

大多数用户都知道如何检查他们的 CPU 的状态,查看有多少系统内存可用,或者找出有多少磁盘空间可用。相比之下,从历史上看,密切关注 GPU 的运行状况和状态一直比较困难。如果您不知道去哪里寻找,甚至可能难以确定系统中 GPU 的类型和功能。值得庆幸的是,NVIDIA 最新的硬件和软件工具在这方面做出了很好的改进。该工具是 NVIDIA 的系统管理接口 (nvidia-smi)。根据您卡的代号,可以

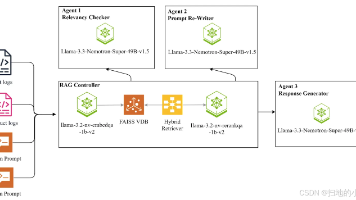

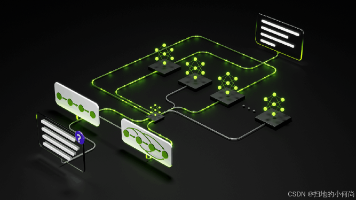

本文介绍了利用NVIDIA Nemotron构建的多智能体自我修正RAG系统,用于解决复杂日志分析的挑战。该系统通过混合检索、智能重排序、相关性评分和生成等核心组件,结合多智能体协同工作流,实现了从海量日志中自动提取关键洞察的能力。文章详细阐述了系统架构、关键技术及实现方法,并提供了快速上手指南。该系统能显著提升日志分析效率,将问题诊断时间从数小时缩短到数秒,适用于DevOps、网络安全等多个领域

本文介绍了如何利用NVIDIA Nemotron构建一个多智能体自我修正的RAG系统,用于解决复杂日志分析挑战。系统采用混合检索、智能重排序和相关性评分等技术,通过多智能体协同工作实现日志解析、查询修正和答案生成。文章详细阐述了系统架构、关键组件和实现方法,并提供了快速上手指南。该系统能显著提升日志分析效率,将问题诊断时间从数小时缩短至数秒,为开发运维团队提供有力支持。

nvmath-python提供了对NVIDIA数学库的Python接口,使开发者能够利用GPU加速的数学运算,显著提高计算密集型应用的性能。这个库包含了多种优化的数学函数,特别适合于线性代数、统计分析和科学计算领域。

摘要:NVIDIA CUDA-Q QEC 0.5.0量子纠错新功能 NVIDIA CUDA-Q QEC 0.5.0版本推出多项量子纠错关键功能:1)支持在线实时解码,实现与量子处理单元(QPU)的低延迟并行运行;2)新增GPU加速的RelayBP算法解码器,通过"记忆强度"概念改进传统BP方法;3)集成TensorRT AI解码器推理引擎,支持ONNX模型;4)引入滑动窗口解码

本文深入探讨了NVIDIA硬件一致性平台(GH200/GB200/GB300)的两种内存管理模式:NUMA和CDMM。NUMA作为默认模式统一管理CPU和GPU内存,但可能导致GPU显存被非计算任务占用,在Kubernetes环境中引发资源隔离问题。CDMM模式则通过驱动直接管理GPU内存,避免系统干扰,特别适合Kubernetes部署和需要精确内存控制的场景。文章详细对比了两种模式的特点、适用场

NVIDIA游戏AI与神经渲染技术革新 NVIDIA在Gamescom 2025上发布了RTX神经渲染和ACE生成式AI技术的重要更新。DLSS 4通过Streamline SDK提供更简便的集成方式,支持175+游戏,显著提升帧率和图像质量。RTX Kit引入Cooperative Vectors技术,允许HLSL着色器直接访问Tensor Core,为实时AI渲染开辟新可能。NvRTX 5.6

MCP LLM Bridge 是一个连接 Model Context Protocol (MCP) 服务器与 OpenAI 兼容大型语言模型 (LLM) 的桥接工具,旨在解决不同模型协议之间的集成挑战。它通过双向协议转换,将 MCP 工具规范转换为 OpenAI 函数模式,并处理函数调用映射到 MCP 工具执行,支持云端和本地部署的模型(如 Ollama)。

NVIDIA CUDA-QX 0.4平台为量子纠错(QEC)研究提供革命性解决方案,通过集成GPU加速显著提升工作流效率。该版本实现了从代码定义、含噪模拟到校验子解码的全流程自动化,其中关键创新包括:1)一键式生成高保真度探测器错误模型(DEM),消除传统手动流程的瓶颈;2)基于cuQuantum SDK的GPU加速张量网络解码器,在保持最佳精度的同时实现数量级性能提升。平台通过统一API简化了Q