简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

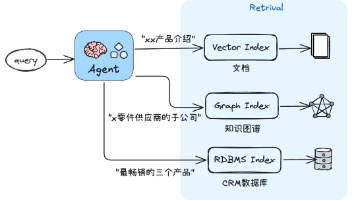

不用记复杂的学术定义,小白一句话读懂:Agentic RAG,就是融合了Agent自主能力的RAG。Agent的核心能力是“自主推理、自主规划、自主行动”,把这种能力融入到传统RAG中,让RAG不再是“被动检索的工具”,而是能“主动思考、灵活应对复杂任务”的系统——这就是Agentic RAG的本质。Agentic RAG就是将AI智能体的自主规划(如任务路由、行动步骤拆解、结果反思等)能力,融入

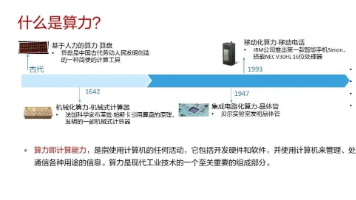

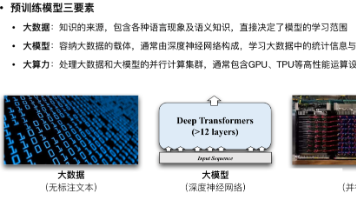

每当ChatGPT、Sora等主流大模型不断爆出技术突破时,相信很多程序员和技术小白都会有同样的感受——既为AI技术的飞速发展感到兴奋,又会默默困惑:这些看似“无所不能”的智能背后,到底藏着怎样的支撑?需要多少技术和资源才能实现?今天,我们就彻底拆解这个核心问题——支撑大模型训练的“算力”,到底是什么?它为何能成为大模型的“命脉”,又为何如此昂贵?

用过ChatGPT或Deepseek,豆包等的你一定好奇:AI Agent(AI智能体)到底有什么不一样?简单说,这是AI从"只会聊天"到"能干实事"的一次飞跃。传统大语言模型就像一个只会回答问题的顾问:你问,它答;你要内容,它写。

用过ChatGPT或Deepseek,豆包等的你一定好奇:AI Agent(AI智能体)到底有什么不一样?简单说,这是AI从"只会聊天"到"能干实事"的一次飞跃。传统大语言模型就像一个只会回答问题的顾问:你问,它答;你要内容,它写。

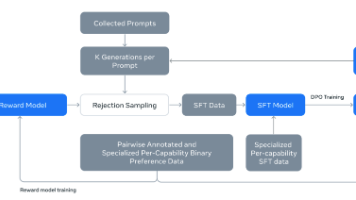

本文介绍了大模型Function Calling的训练核心环节:数据构造、模型架构适配、多阶段微调。以Llama3.1/Qwen-Agent为例,详细解析了数据预处理(含主题分级、质量评估、难度量化、语义优化)、两阶段训练(预训练+后微调)、及SFT、RLHF/DPO等训练方法。通过质量-难度联合建模与语义优化,可显著提升模型准确率并缩短收敛时间。主要来说,Function Calling 的训练

很多小白、程序员都会问:“我零基础,能转大模型吗?”“我35岁了,现在转大模型晚吗?” 答案很简单:只要你愿意行动,愿意坚持,就不晚。大模型是一个刚兴起的领域,目前行业人才缺口巨大,现在入场,比5年后再转,要容易得多、机会得多——哪怕你是零基础小白,哪怕你已经35+,只要找对方法、坚持实操,就能顺利转型。转行大模型的核心,不是“推翻过去的积累”,而是“升级自己的能力”——把你多年的编程经验、项目思

之前Meta为AI工程师开出2亿美元天价薪酬的新闻,曾让很多人震惊——但这背后不是泡沫,而是“技术迭代推动产业升级,产业升级重新分配财富”的必然结果。回顾过往,每一次重大技术变革,都会淘汰一批旧岗位,也会催生一批新机会:20年前的互联网,让一批普通人实现了阶层跨越;10年前的移动互联网,让一批程序员拿到了高薪;而2026年的AI应用开发,就是这样一个明确、可落地、低门槛的机会。很多小白和程序员会问

最近,不少在招聘平台奔波的开发者都有一个明显的感受:后端开发岗位肉眼可见地减少,薪资不仅没了往年的稳步涨幅,甚至出现了停滞不前的情况。更有求职者无奈吐槽,自己批量投递了70份后端相关简历,最终仅收到3个面试邀约,更扎心的是,邀约给出的薪资,比去年同期还低了10%。这样的就业现状,让不少后端开发者陷入焦虑,尤其是刚入行的小白,更是对未来的职业发展感到迷茫。

大语言模型(Large Language Models,简称LLMs),是基于深度神经网络打造的高端AI系统,核心亮点在于搭载百亿级、千亿级甚至万亿级参数量,通过自监督学习模式,在海量无标注文本语料(涵盖书籍、网页文章、学术论文、行业文档等)中完成训练,最终具备理解和生成人类语言的能力。

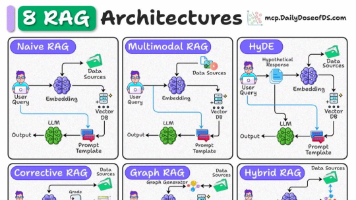

从基础版RAG到智能体RAG,这8类架构的演进,清晰展现了RAG技术从“解决基础信息匹配”到“支撑复杂智能任务”的升级路径——本质上,是RAG从“被动的检索工具”,逐步升级为“具备自主决策能力的智能助手”的过程。对于小白和程序员来说,无需盲目追求高阶架构,核心是“按需选型”,根据自身的业务需求、技术实力,选择最适合的架构,避免“过度设计”导致的资源浪费。简单事实查询、文本类数据为主,小白入门/快速