简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

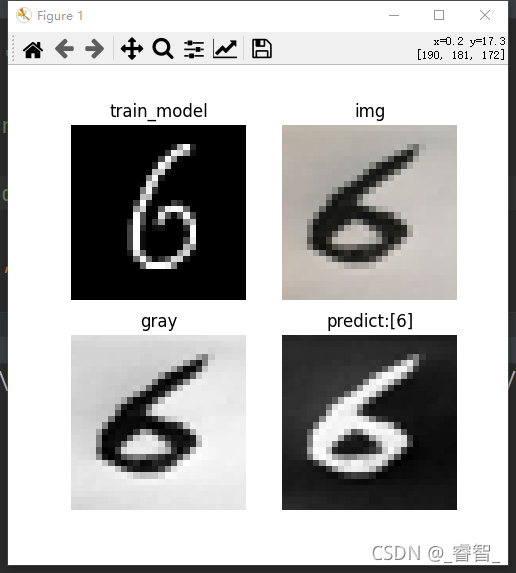

目录基础理论一、训练CNN卷积神经网络1、载入数据2、改变数据维度3、归一化4、独热编码5、搭建CNN卷积神经网络5-1、第一层:第一个卷积层5-2、第二层:第二个卷积层5-3、扁平化5-4、第三层:第一个全连接层5-5、第四层:第二个全连接层(输出层)6、编译7、训练8、保存模型代码二、识别自己的手写数字(图像)1、载入数据2、载入训练好的模型3、载入自己写的数字图片并设置大小4、转灰度图5、转

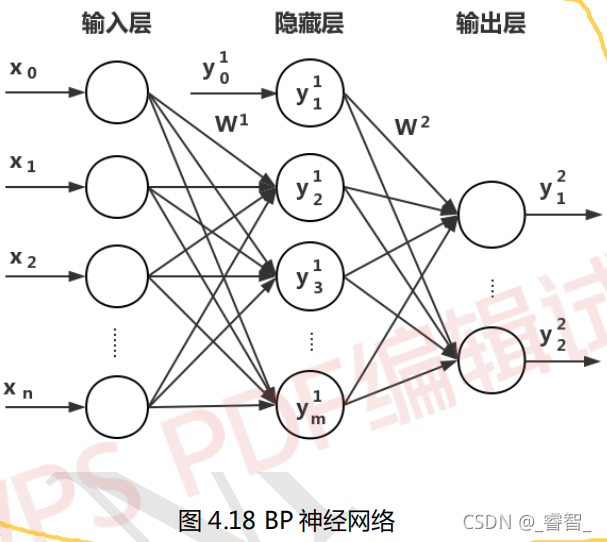

一、概念与定义BP神经网络:是一种按照误差逆向传播算法训练的多层前馈神经网络。BP 算法的基本思想:学习过程由信号的正向传播和误差的反向传播两个过程组成。正向传播:把样本的特征从输入层进行输入,信号经过各个隐藏层逐层处理后,最后从输出层传出。反向传播:对于网络的实际输出与期望输出之间的误差,把误差信号从最后一层逐层反传,从而获得各个层的误差学习信号,再根据误差学习信号来修正各个层神经元的权值。周而

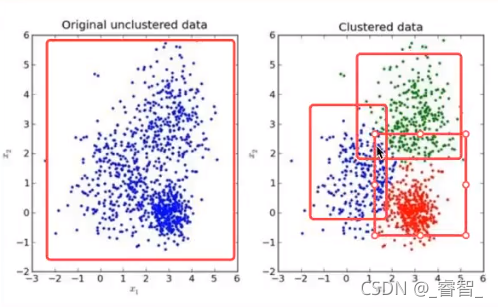

目录一、K-means1、概念2、过程3、API(K-means)二、K-means性能评估1、轮廓系数2、API(轮廓系数)一、K-means1、概念无监督学习:没有目标值(没有标签)。(聚类一般在分类之前,没有目标值的时候使用聚类)采用迭代式的算法,直观易懂且实用。缺点:容易受到局部最优解(避免:多次聚类,取多次聚类中心)。最优解:k个中心点挤在一起。例:对这些人物的分类,没有目标值,就是无监

目录基础理论一、生成验证码数据集1、生成验证码训练集1-0、判断文件夹是否为空1-1、创建字符集(数字、大小写英文字母)1-2、随机生成验证码(1000个,长度为4)2、生成验证码测试集代码二、获取数据(训练集、测试集)1、获取数据和标签1-1、获取训练集数据和标签(路径和标签)1-2、获取测试集数据和标签(路径和标签)1-3、数据组合(图像路径和标签)2、打乱数据3、处理每条数据4、自定义重复周

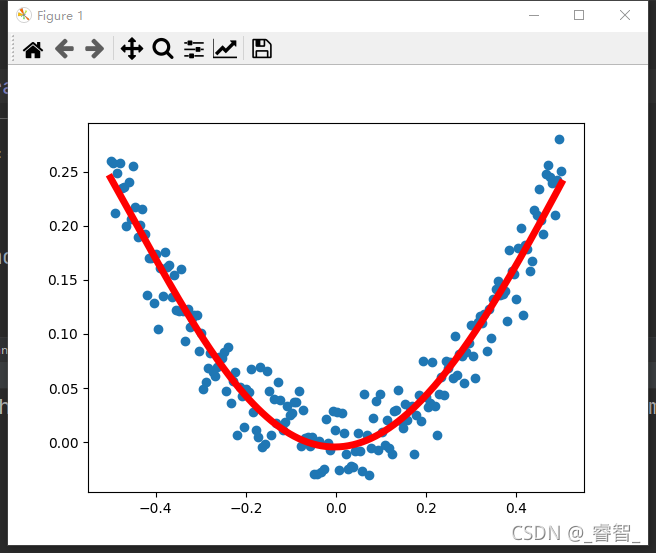

目录一、拟合线性函数1、生成随机坐标2、神经网络拟合代码二、拟合非线性函数1、生成二次随机点2、神经网络拟合代码一、拟合线性函数学习率0.03,训练1000次:学习率0.05,训练1000次:学习率0.1,训练1000次:可以发现,学习率为0.05时的训练效果是最好的。1、生成随机坐标1、生成x坐标2、生成随机干扰3、计算得到y坐标4、画点# 生成随机点def Produce_Random_D..

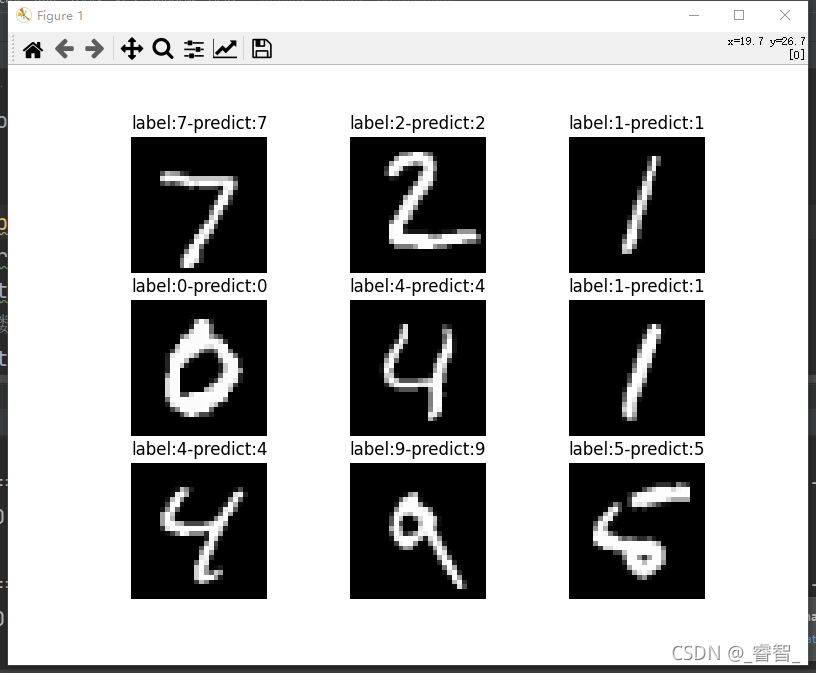

目录成果展示基础理论一、数据准备1、载入数据集2、数据处理2-1、归一化2-2、独热编码二、神经网络拟合1、搭建神经网络2、设置优化器、损失函数3、训练三、预测1、备份图像数据集2、预测分类3、显示结果(plt)总代码成果展示训练1次:训练30次:基础理论本次手写数字识别,采用的是MNIST数据集。http://yann.lecun.com/exdb/mnist/这里输出层用到了softma...

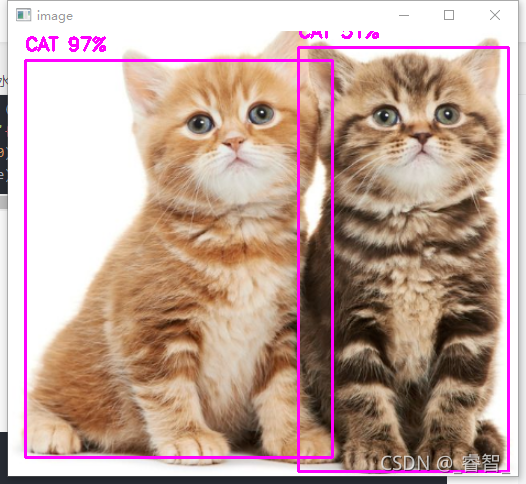

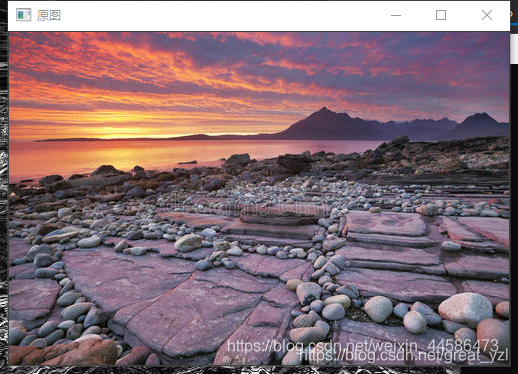

图像被划分成3个图像:图像在多次卷积压缩后,小物体容易消失,所以我们分别用52*52、26*26、13*13的网格检测小物体、中物体、大物体。(猫是大物体,所以用13*13的网格检测)import cv2import numpy as np# 读取文件def ReadFile():global name_listname_list = []# 1、读取文件with open('coco.names

在使用conda创建新环境时,出现Collecting package metadata (current_repodata.json): failed的问题,尝试了很多方法都没有解决,最后无意中通过大佬的博客解决了。大佬博客链接:https://www.jianshu.com/p/b1e4f33f975a。首先找到C:/User/Mars>下的.condarc文件,使用记事本打开。然后将一下内容

目录一、基础理论二、实战1、对x方向微分2、对y方向微分3、线性混合总代码参考资料一、基础理论Sobel算子:用于边缘检测的离散微分算子。梯度公式:对于图像而言,它是离散的,所以h的最小值只能是1了,那么这意味着,图像中某个像素位置的梯度(以x方向为例)等于它左右两个像素点的像素之差除以2。例:假设有一行像素是这样分布的:123 155 173那么,像素值为155的像素位置x方向的梯度为(173

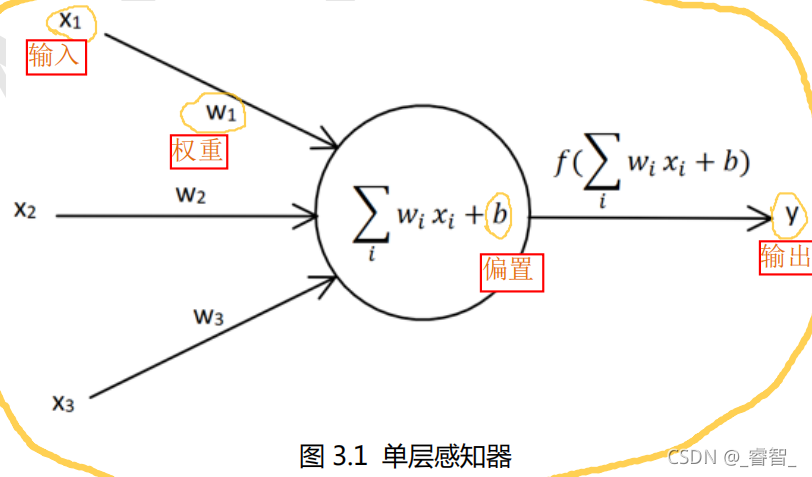

目录基础理论1、单词感知器介绍2、单词感知器学习规则前向传递(得到输出y)反向传递(更新权重w)手写单层感知器1、初始参数设置2、正向传播(得到输出y)3、 反向传播(更新权重参数)总代码基础理论1、单词感知器介绍感知器:模拟生物神经网络的人工神经网络结构。w:权值,可以调节神经信号输入值的大小。b:偏置,相当于神经元内部自带的信号。f(x):激活函数,信号进行线性/非线性变化。(有sign、si