简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

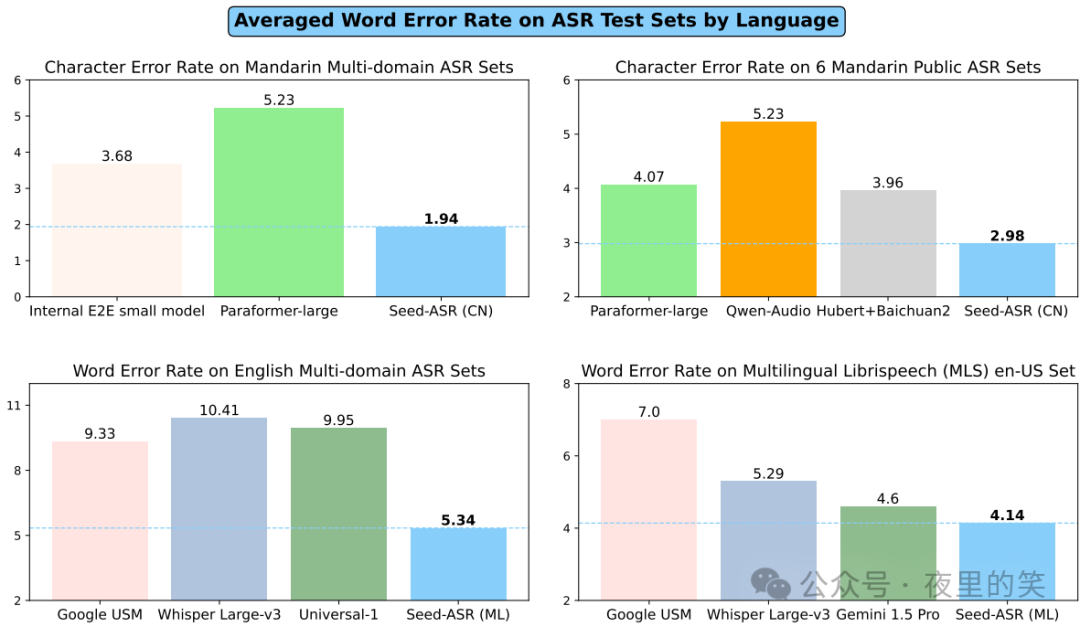

在上下文感知微调阶段,Seed-ASR模型通过生成与转录文本相关的自然语言上下文,并使用这些上下文和语音表示进行训练,从而增强模型在复杂语境下的识别能力。这篇论文提出的Seed-ASR模型通过阶段化的训练方法,包括SFT、Context SFT和RL,在多个评估集上表现出显著的性能优势。1.高识别准确率:通过在超过2000万小时的语音数据和近90万小时的配对ASR数据上进行训练,Seed-ASR(

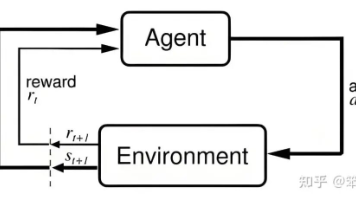

本文系统介绍强化学习在大模型中的应用,从基础理论到核心算法(Q-learning、PPO、DPO等),重点解析Agentic RL与LLM-RL的本质区别。强调Agentic RL在多步决策、工具调用中的必要性,并详述Hugging Face TRL、ms-swift等主流框架及业界实践。文章指出,Agentic RL已成为智能体时代的标配技术,能赋予模型自主执行与持续进化能力,是构建复杂AI系统

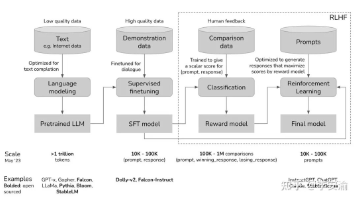

大模型训练正从预训练转向后训练阶段,强化学习(RL)成为关键。文章详细介绍了RLHF(基于人类反馈)和RLVR(可验证奖励)两种强化学习方法,对比了PPO和GRPO等算法。针对RL训练中推理与训练系统耦合的复杂工程挑战,verl框架提供了有效解决方案,并提出了投机式Rollout等性能优化技术,显著提升大模型在复杂任务中的推理与决策能力。

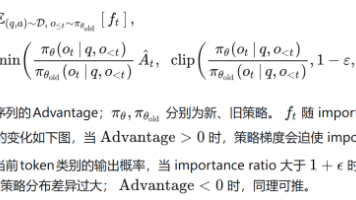

本文面向已了解强化学习中策略梯度(policy gradient)、优势函数(advantage)、重要性采样(importance sampling)等概念的读者,重点对大模型强化学习主流算法做一条线的梳理与比较。

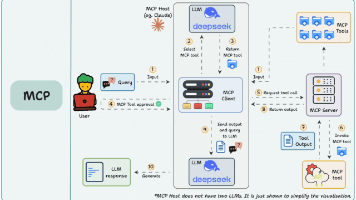

近年来,AI大模型席卷各行各业,我们感受到它强大的语言理解和生成能力。但在实际应用中,光“能说会道”还不够,更重要的是“能说还得能做”。大模型如何跨出文本世界,触达数据库、调用接口、执行代码?答案就是:MCP(Model Context Protocol)模型上下文协议。今天这篇文章,我们将详细解读 MCP 能做什么、它的工作原理以及它是如何打破大模型“只能说不能做”的边界。后面的文章中会分享Cu

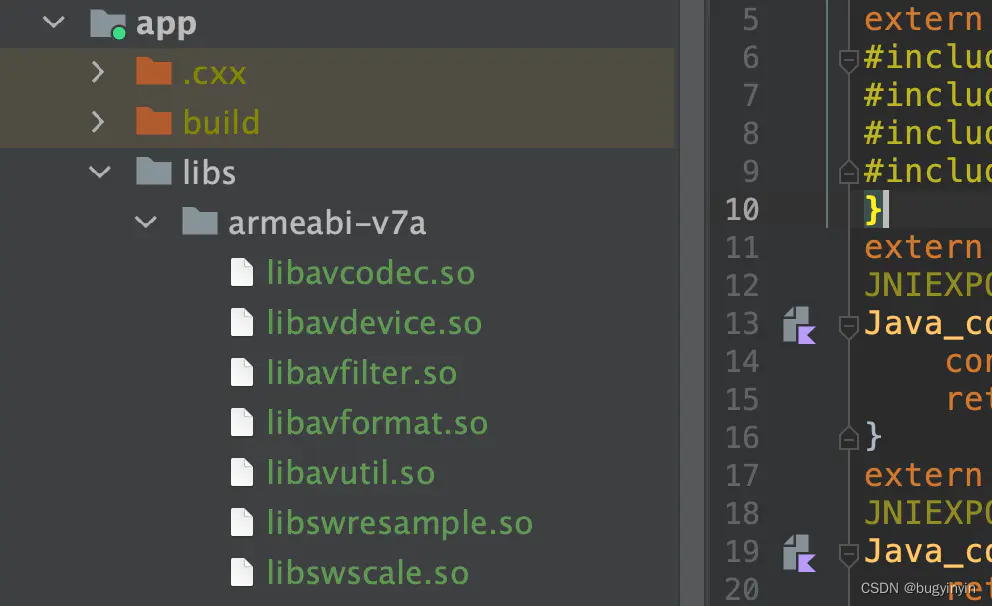

并且在该文件内,添加和配置上面我们引入的库文件。4、在app的build.gradle中添加ffmepg的配置项。5、在你需要使用的地方调用这里用简单的activity来举例,首先我们是在伴生对象里初始化“native-lib”,然后定义一个external方法,方法名随意,由于没有实现,所以会报错,但是只需要根据Androidstudio的提示,利用快捷键就能自动在native-lib.cpp文

上一篇用实战代码演绎了 Feeds 流场景下,业务层代码如何从 “无架构”到“MVP”再到“MVVM”,并使用`LiveData`承载整个数据链路。这一篇尝用 Kotlin Flow 替换掉 LiveData,看看会发生些什么变化及遇到哪些问题。

Android系统架构图:其中我们可以看到:Android 平台的基础是 Linux 内核。例如,Android Runtime (ART) 依靠 Linux 内核来执行底层功能,例如线程和低层内存管理。使用 Linux 内核可让 Android 利用主要安全功能,并且允许设备制造商为内核开发硬件驱动程序。Android****专用驱动。...

刚入行Android系统开发两年,发现在项目维护和需求开发的时候仅仅考虑快速解决,而没有深入理解其设计思想和思考高效稳定的解决方法,毕竟framework修改直接影响系统的稳定性,任何问题的修改,需要慎重。随着项目的开展和积累,越发觉得需要深入学习理解framework的设计,下面是网上和相关书籍总结的学习思路,仅仅在此汇总下。一、阅读Android源码的术与道:1、Android源码的道Andr

刚入行Android系统开发两年,发现在项目维护和需求开发的时候仅仅考虑快速解决,而没有深入理解其设计思想和思考高效稳定的解决方法,毕竟framework修改直接影响系统的稳定性,任何问题的修改,需要慎重。随着项目的开展和积累,越发觉得需要深入学习理解framework的设计,下面是网上和相关书籍总结的学习思路,仅仅在此汇总下。