简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

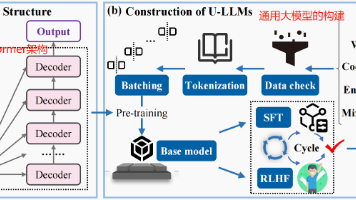

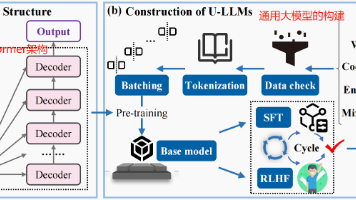

高炉炼铁行业正加速推进智能化转型,垂直大模型(V-LLMs)成为关键技术方向。本文分析了国内外大模型发展现状,指出当前钢铁行业通用大模型(U-LLMs)存在专业性不足的问题,而闭源式高算力钢铁大模型又面临部署成本高、知识融合有限等挑战。文章重点探讨了高炉炼铁垂直大模型的构建路线,包括Transformer架构应用、数据采集预处理、模型训练等关键环节。领域专业知识的深度整合是提升高炉炼铁大模型性能的

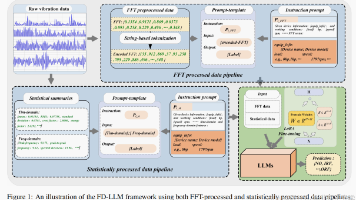

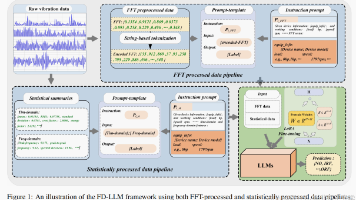

FD-LLM模型创新性地将大规模语言模型(LLM)应用于机器故障诊断领域。研究通过两种编码方法(基于字符串的标记化和统计特征提取)将振动信号等时间序列数据转换为LLM可处理的文本输入,并采用LoRA技术对Llama3等开源模型进行微调。在CWRU轴承数据集上的实验表明,该模型在传统故障诊断任务中准确率和F1分数接近100%,在跨操作条件场景下表现优异,但在跨机器组件场景中性能有所下降。这项工作为工

FD-LLM模型创新性地将大规模语言模型(LLM)应用于机器故障诊断领域。研究通过两种编码方法(基于字符串的标记化和统计特征提取)将振动信号等时间序列数据转换为LLM可处理的文本输入,并采用LoRA技术对Llama3等开源模型进行微调。在CWRU轴承数据集上的实验表明,该模型在传统故障诊断任务中准确率和F1分数接近100%,在跨操作条件场景下表现优异,但在跨机器组件场景中性能有所下降。这项工作为工

本文介绍了基于Flask框架的博客系统开发中两个核心数据库模型的搭建与功能实现,包括:1) 通过exts.py配置SQLAlchemy和Mail扩展插件;2) 在config.py中设置数据库连接和邮件服务器参数;3) 创建UserModel和EmailCaptchaModel两个ORM模型,分别用于用户信息管理和邮箱验证码存储;4) 前端注册页面通过AJAX请求获取验证码,后端实现验证码生成与邮

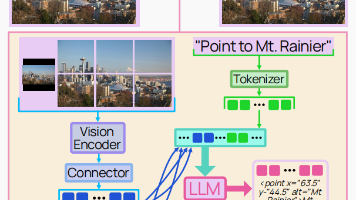

开源视觉语言模型新突破:Molmo与PixMo 当前顶级视觉语言模型(VLM)如GPT-4V均为闭源,开源方案多依赖闭源模型蒸馏数据。艾伦AI研究所提出全开源SOTA模型Molmo及无VLM依赖的PixMo标注数据集,突破闭源垄断。 核心创新: 1️⃣ 模型架构:采用重叠裁剪+注意力池化的视觉连接器设计,OCR精度提升12%; 2️⃣ 数据标注:通过语音转文本生成密集描述(比COCO详细17倍),

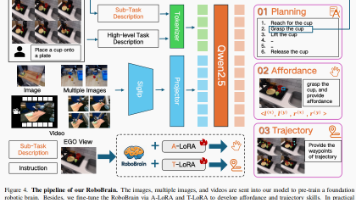

RoboBrain研究提出了一种统一的多模态大模型范式,将任务规划、可抓取区域感知和轨迹预测整合到端到端模型中。通过超百万级的ShareRobot数据集训练,该模型在多个基准测试中刷新了SOTA表现。RoboBrain基于LLaVA-OneVision-7B架构,引入双LoRA插件(A-LoRA和T-LoRA)实现高效适配,并采用四阶段训练策略优化性能。实验显示,该模型在规划、affordance

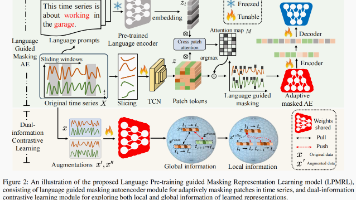

选文针对时间序列数据的复杂性、时空性和连续性所带来的自监督表征学习挑战,提出了一种新的方法——语言预训练引导掩蔽表征学习(LPMRL)。该方法通过自然语言描述引导掩蔽编码器自适应采样语义时空块,显著提高了潜在表征的可区分性。此外,LPMRL引入了对比学习机制,通过生成高质量的难负样本,进一步优化表征的可区分性,从而提高模型的分类性能。通过在106个基准数据集上的实验验证,LPMRL显著优于现有的最

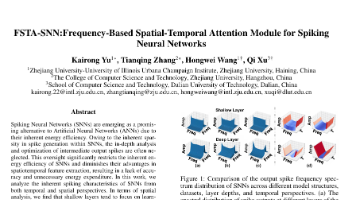

选文提出了一种基于频率的时空注意力模块(FSTA)来优化脉冲神经网络(SNNs)的性能。研究发现SNNs在时空维度上存在特征学习冗余问题,尤其是浅层网络。通过离散傅里叶变换分析脉冲输出,发现其频率分布具有高度一致性。基于此,FSTA模块包含基于DCT的空间注意力子模块和时间注意力子模块,能有效抑制冗余脉冲特征。实验结果表明,FSTA模块在CIFAR-10、ImageNet等数据集上显著提升了SNN

高炉炼铁行业正加速推进智能化转型,垂直大模型(V-LLMs)成为关键技术方向。本文分析了国内外大模型发展现状,指出当前钢铁行业通用大模型(U-LLMs)存在专业性不足的问题,而闭源式高算力钢铁大模型又面临部署成本高、知识融合有限等挑战。文章重点探讨了高炉炼铁垂直大模型的构建路线,包括Transformer架构应用、数据采集预处理、模型训练等关键环节。领域专业知识的深度整合是提升高炉炼铁大模型性能的