简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

首先下载:Visual Studio与功能包OpenCV。

从整体上看Transformer LLM接收提示词输入,并输出生成的文本模型并不是一次性生成所有文本,而是一次生成一个词元。每个词元生成步骤都是模型的一次前向传播(在机器学习中,前向传播指的是输入进入神经网络并流经计算图,最终在另一端产生输出所需的计算过程)。在生成当前词元后,我们将输出词元追加到输入提示词的末尾,从而调整下一次生成的输入提示词。神经网络外围的软件基本上就是在循环运行这个模型,按顺

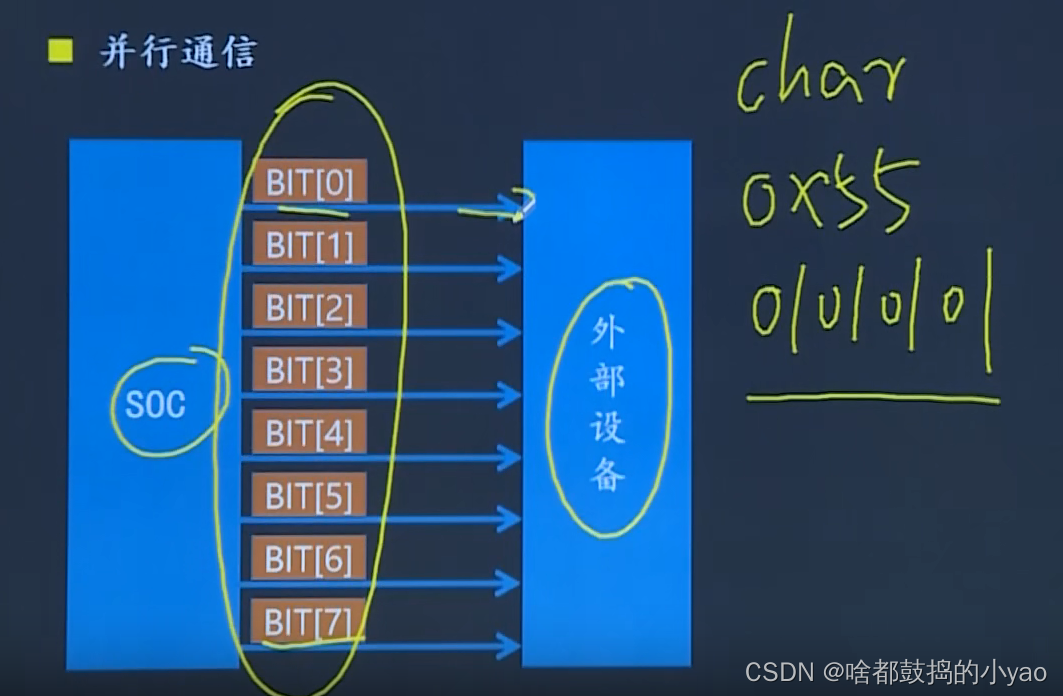

UART通信协议概念通信基础并行通信串行通信单工通信双工通信半双工全双工波特率UART帧格式硬件连接控制器AVR单片机USART相关寄存器I/O数据寄存器 UDR控制和状态寄存器 UCSRA控制和状态寄存器UCSRB控制和状态寄存器UCSRC波特率寄存器UBRRL和UBRRHUSART的使用方法初始化发送函数接受函数主函数实例概念UART是一种通用串行数据总线,用于异步通信。该总线双向通信,可以实

让三个传入的神经元向我们的绿色神经元的输入发送大小为十、七和三的脉冲。此外,神经元之间的突触具有不同的阻力。而如果网络中两个连续的层之间没有激活函数,那么它们就是两个线性函数的组合,这也是一个线性函数。然而,对于神经网络的隐藏层来说,这种激活函数的选择并不是最佳的。创建一些类似的机器学习模型,其目的是将元素的特征作为输入,并基于这些特征输出该元素的新特征。这与我们从逻辑回归构建完全连接网络的方式一

从整体上看Transformer LLM接收提示词输入,并输出生成的文本模型并不是一次性生成所有文本,而是一次生成一个词元。每个词元生成步骤都是模型的一次前向传播(在机器学习中,前向传播指的是输入进入神经网络并流经计算图,最终在另一端产生输出所需的计算过程)。在生成当前词元后,我们将输出词元追加到输入提示词的末尾,从而调整下一次生成的输入提示词。神经网络外围的软件基本上就是在循环运行这个模型,按顺

然后,他们建立第二个模型,该模型预测的不是原始值,而是第一个模型的误差,并考虑到这一点,调整最终预测。我们说第一个模型给出了这个答案,但是我们在它上面添加了第二个模型的修正,然后是第三个模型的修正,依此类推,直到得到最后一个模型。它以略有不同的方式(采用不同的子样本、不同的特征)生成许多彼此独立的不同树,并根据它们的响应形成最终解决方案。增加模型的复杂性会导致散度的增加,而简化模型会导致偏差的增加

这个陈述使我们能够更进一步地观察从非线性模型到线性模型的转变,这不仅仅是由于对特征应用了变换,而且是由于。

课程计划。

让我们回到图像分类问题 CIFAR。你的主要任务:实现整个模型训练流程,并在测试样本上获得良好的准确度指标值。本任务中用于训练模型的代码已完整实现。您需要做的就是为神经网络类编写代码并试验参数以获得良好的质量。除此之外,你要保证模型的内存使用!