简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

【代码】大数据技术演进(从传统Hadoop到Spark到云原生的技术演进路径)

不是“不能”,而是“不为”:IDEA 在设计上完全有能力通过插件体系支持 Python(事实上它也确实支持),但 JetBrains 选择通过独立的 PyCharm 来提供最佳的 Python 开发体验。选择建议如果你主要或只使用 PythonPyCharm是你的不二之选。如果你主要进行 Java/JVM 开发,同时偶尔需要写 Python,使用并安装 Python 插件是最佳工作流。如果你需要频

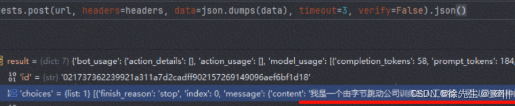

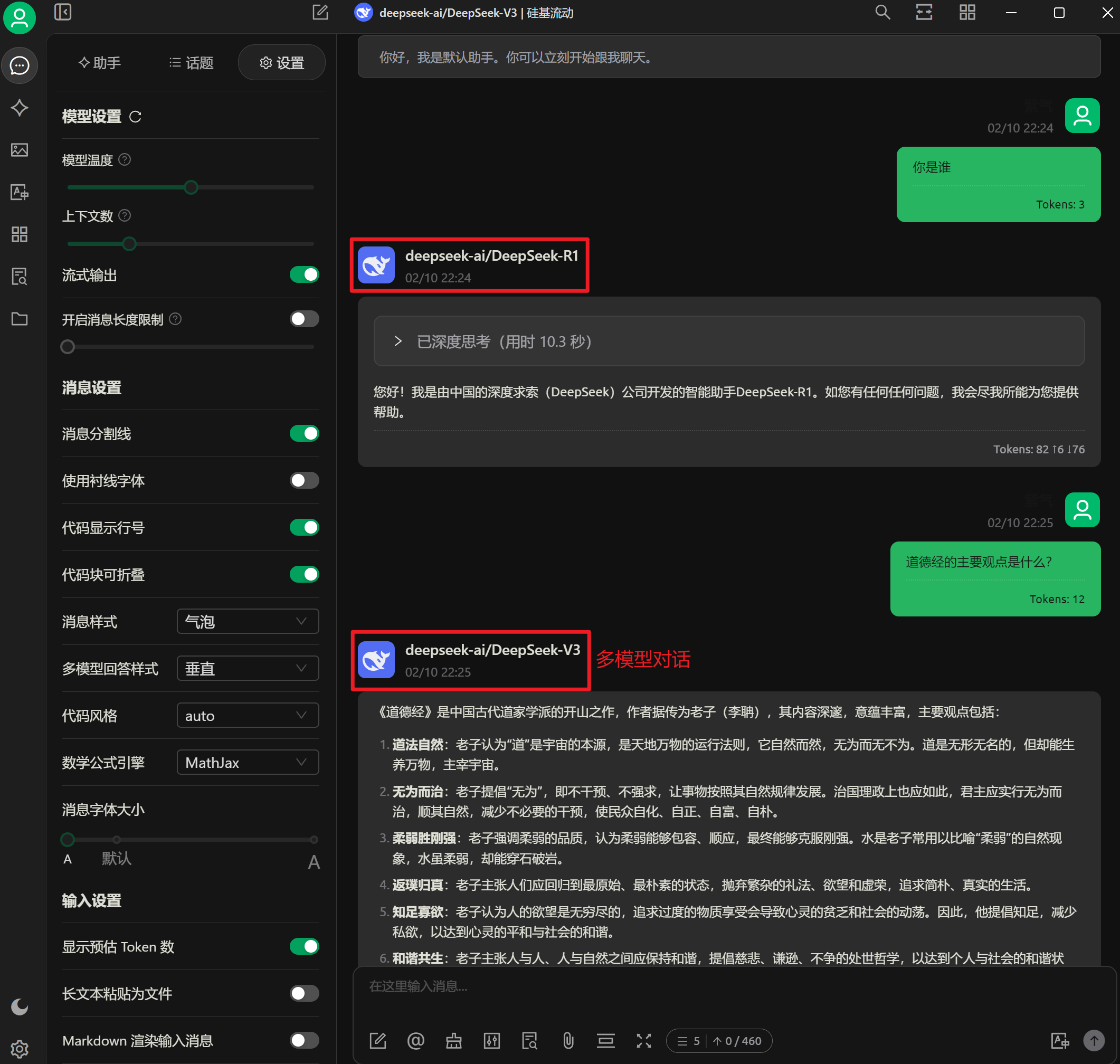

DeepSeek满血版本搭建教程

大模型Agent是基于大规模语言模型(LLM)构建的智能实体,它融合了自主性、交互性、反应性和主动性等多元特质。与单纯的大模型不同,Agent不仅能够理解和生成文本,还能自主决策和执行任务,实现从"计划"、“组织”、"执行"到"学习"的完整闭环。Agent可被视为"具备自主智能的实体",也被广泛称作智能体。当前的Agent主要分为三种类型:单体Agent、多Agent协作(Multi-Agent)

Palantir Foundry通过这种分层架构,将数据、模型、业务语义、分析和决策编排有机整合,帮助企业构建从数据洞察到业务行动的完整数字化运营体系。本体层作为核心创新,为企业提供了统一的业务语义基础,使AI和数据分析能够更好地理解和作用于真实业务世界。:连接企业各类数据源,提供统一的数据访问和管理。:为业务用户提供直观的分析工具。:将分析洞察转化为实际行动。:构建和部署数据科学模型。

总训练时间则取决于您设置的训练轮数。这只是一个非常粗略的估计,实际时间需以实验为准。,用RAG提供外部知识,用PEFT(如LoRA)微调模型技能,兼顾效率、成本与性能。一张V100显卡(以32GB显存为例)的微调时间受。等多种因素影响,难以给出精确数字。:假设使用LoRA方法微调。

其关键组件包括 Agent Card、Client/Remote Agent、Task、Message/Part、Artifact、Discovery、Transport、Auth。这个流程中,每个代理之间通过 A2A 协议通信:Agent Card 发现、Task 创建、Message/Part 交换、Artifact 返回、状态追踪、必要的认证授权。:让代理“自己打广告”——谁我是、我在哪里(

从统计到神经网络:提升了模型表达能力从有限依赖到全局依赖:更好地捕捉语言结构从顺序计算到并行计算:大幅提升训练效率从专门模型到通用架构:Transformer成为基础架构目前Transformer架构及其变体已成为自然语言处理领域的主流,并在不断推动着AI技术的发展。

这是一种“在比较中学习”的范式。其核心思想不是让模型预测一个确切的标签,而是学习一个“表示空间”,在这个空间里,相似样本的表示距离近,不相似样本的表示距离远。希望这个详细的展开介绍能帮助您全面理解这三项重要技术。MOE是一种将“专家”组合起来的模型架构,旨在实现。的“系统级”黑科技。