简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

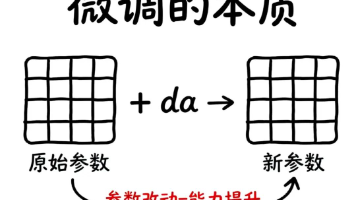

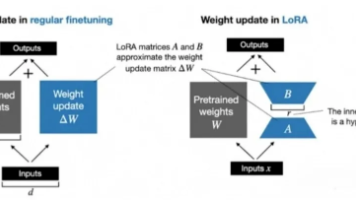

本文介绍LoRA技术,一种高效的大模型微调方法。传统全量微调需更新所有参数,消耗大量资源。LoRA通过矩阵分解,用两个小矩阵近似参数改动,仅需学习2%-16%的参数,可降低90%以上成本。这使得个人开发者也能负担大模型微调,并支持同一基础模型搭配不同LoRA"技能包"实现多任务切换。LoRA让大模型微调从大厂专利走向平民化。

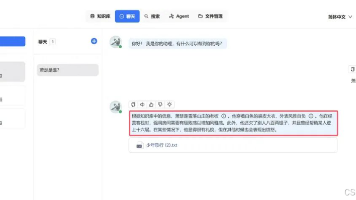

今天给大家介绍一下关于dify和ragflow知识库整合案例,顺便给大家介绍一下ragflow。 话不多说,下面给大家演示一下效果。 我们首先看一下ragflow测试效果

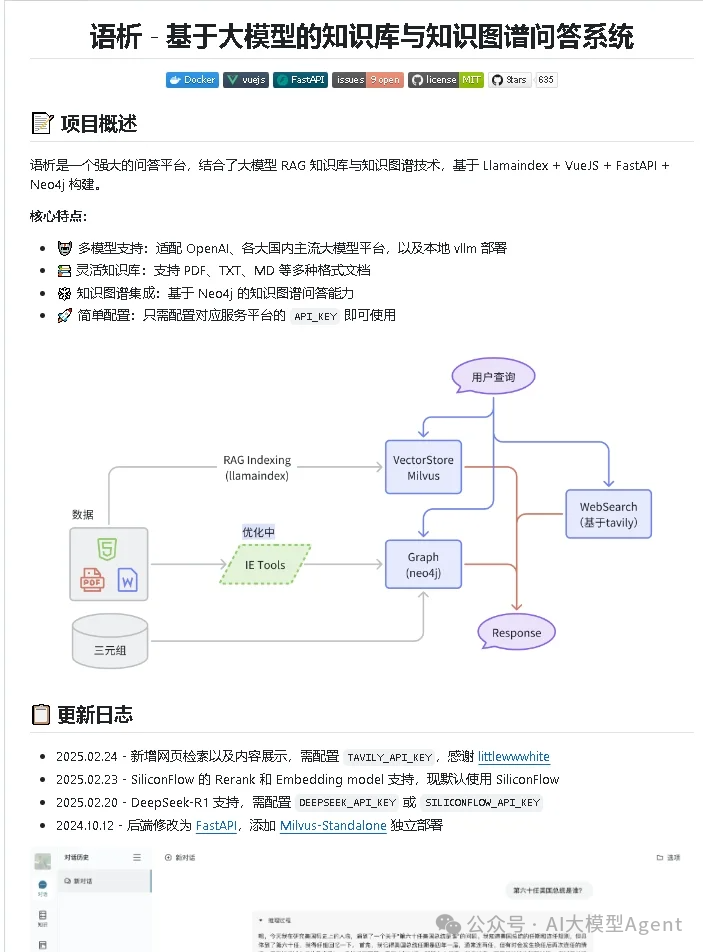

基于大模型 RAG 知识库的知识图谱问答系统。大模型适配 OpenAI、国内主流大模型平台的模型调用、本地 vllm 部署。支持推理模型DeepSeek-R1、联网检索。🤖 多模型支持:适配 OpenAI、各大国内主流大模型平台,以及本地 vllm 部署📚 灵活知识库:支持 PDF、TXT、MD 等多种格式文档🕸️ 知识图谱集成:基于 Neo4j 的知识图谱问答能力🚀 简单配置:只需配置对

“中年危机”对于我们当代人来说,是令我们每个人都惶恐不安的四个字,但我们又不得不面对它。对于我们程序员来说尤为明显,就像一个魔咒一样挥之不去。

我也是他们中的一员。但就在几个月前,我做出了一个改变命运的决定:从传统后端开发,零基础切入大模型领域。仅仅用了两个多月的时间,我就拿到了月薪2万+的大模型应用工程师Offer。今天,我想把这段真实、毫无保留的经历分享给你,告诉你为什么大模型是我们35+程序员逆袭的最佳风口,以及一条已经被验证的、可以“抄作业”的转型路径。

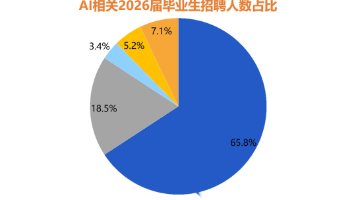

2025年夏末,一场针对2026届毕业生的AI人才争夺战比往年提前了至少一个月打响。阿里巴巴、腾讯、字节跳动、百度等头部企业纷纷抛出规模空前的招聘计划,其中AI相关岗位占比普遍超过60%,部分业务线甚至高达80%至90%。一场前所未有的秋招正在拉开序幕,机遇与门槛都前所未有。

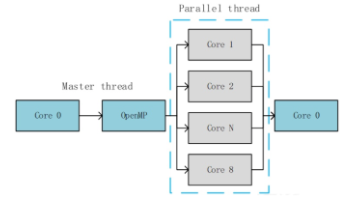

大模型以其强大的能力在自然语言处理、计算机视觉等众多领域发挥着关键作用。然而,算力资源的稀缺性使大模型推理面临着计算资源难以满足、推理速度慢等挑战,与行业深入应用形成的亟待解决的矛盾,而利用 GPU 进行加速以及借助高效的推理框架如 vLLM 成为了重要的解决方案。本文从GPU通用加速优化技巧和vLLM原理解析出发,随后详细分享了基于GPU和vLLM的推理加速实践及案例,其中有很多值得学习借鉴的经

2025年,大模型已从技术热点演变为重塑千行百业的核心生产力。智联招聘数据显示,AI大模型相关岗位需求同比增长超过10倍,但人才供需比仅为0.5。市场上每两个岗位,才有一个合适的候选人。这张路线图不仅是一份学习指南,更是你抓住时代机遇、构建职业护城河的战略地图。

本文系统介绍大模型参数高效微调(PEFT)方法,包括LoRA、QLoRA、适配器调整、前缀调整、提示调整、P-Tuning等8种技术。这些方法通过冻结预训练模型主干参数,仅引入少量可训练适配模块,显著降低微调计算和存储需求,使资源有限环境下也能高效定制大模型,并提供了从零基础到进阶的完整学习路线。

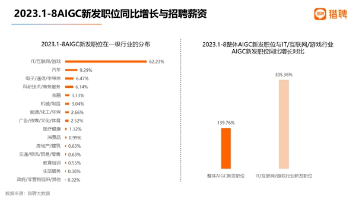

摘要: 随着AIGC技术的爆发式发展,土建行业从业者面临转型机遇与挑战。数据显示,2023年AIGC岗位需求增长近140%,IT/互联网行业占比超60%。AIGC已广泛应用于设计、内容创作、电商等多个领域,为跨行业转型提供可能。建筑从业者可重点关注AIGC设计师岗位,该岗位要求具备设计能力、AI工具使用及模型调优技能。文章还分享了实用AI技巧,如使用Comfyui实现快速抠图和建筑效果图生成,帮助