简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

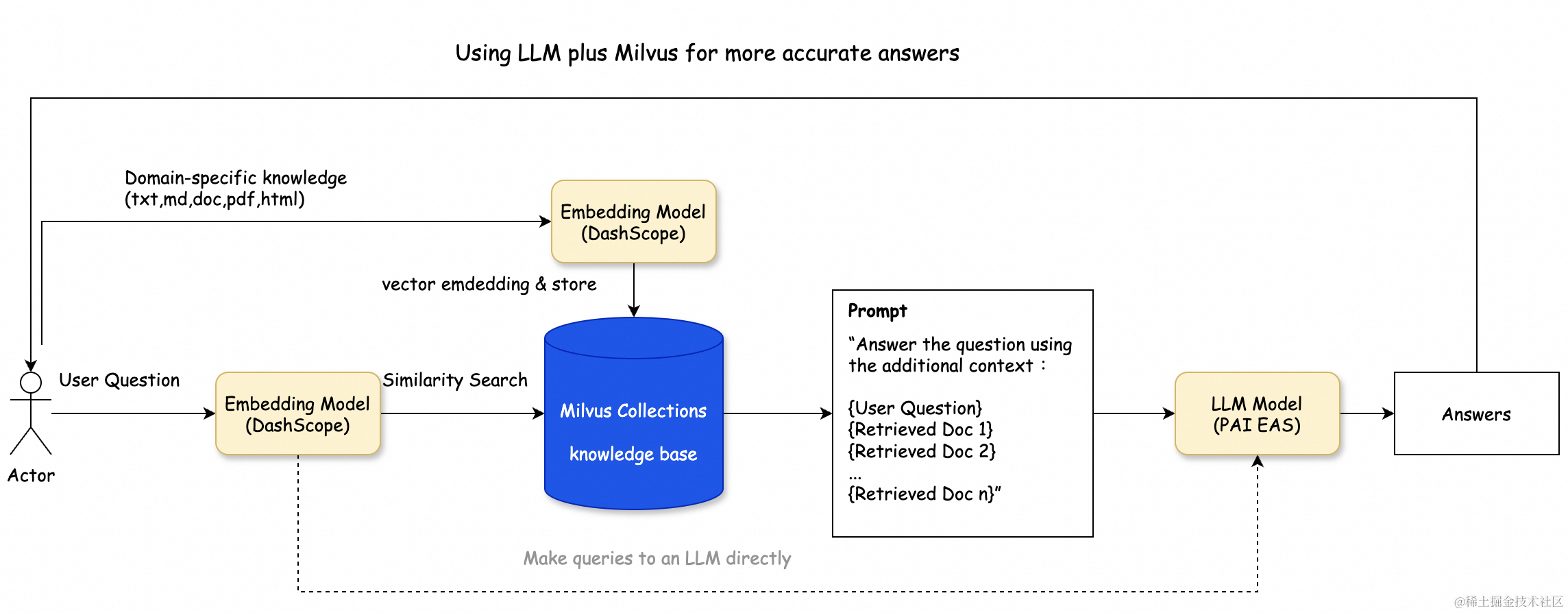

本文介绍如何通过整合阿里云Milvus、阿里云DashScope Embedding模型与阿里云PAI(EAS)模型服务,构建一个由LLM(大型语言模型)驱动的问题解答应用,并着重演示了如何搭建基于这些技术的RAG对话系统。进入模型在线服务页面。在页面,单击。在页面,选择。在页面,配置以下关键参数,其余参数可使用默认配置,更多参数详情请参见。单击。当变为时,表示服务部署成功。获取VPC地址调用的服

本文以个人经验分享AI Agent的学习感受,强调其并非高科技怪物,而是能自主处理日常事务的AI助手。作者通过实例展示AI Agent在旅行计划、周报整理、合同总结等方面的实用价值,并指出零代码平台操作简单,无需编程基础。文章鼓励职场小白尝试使用AI工具,以节省时间、减轻工作负担,适合想要了解和入门AI大模型的学习者参考。说真的,前段时间我刷到AI Agent,心里特别慌。总觉得这是技术大神的专属

你有没有想过当第一次体验到大模型带给你的惊喜时,你有没有想过,它到底是怎么思考的?你或许忙碌、疲惫,连思考“它是怎么思考的”都来不及去思考。可是在过去的很长时间里,模型参数、token、向量化、蒸馏、温度系数等层出不穷的新概念,不断地融入你的工作和生活,你也许已经习以为常,日用而不知。我也时常在想:大模型的 “思考” 过程,和这些概念到底有着怎样的关联?有没有一条清晰的主线,能把这些零散的知识点串

GitHub上持续火爆的《LeeDL-Tutorial》项目,一发布就迅速获得了11.4K的星星!这个项目基于李宏毅老师“机器学习”课程,课程全网超过百万播放量,如今Datawhale新书**《深度学习详解》李宏毅、杨小康、周明、叶杰平、邱锡鹏** 5位人工智能领域大咖的推荐!李宏毅老师是台湾大学的资深教授,专攻机器学习、深度学习和语音识别与理解。让我们对他耳熟能详的莫过于他的**“机器学习” 课

近期,基于 Transformer 的图学习架构蓬勃发展,主要原因是注意力机制作为一种有效的学习机制,以及其取代消息传递方案中手工编写算子的愿望。然而,人们对其经验有效性、可扩展性和预处理步骤的复杂性提出了担忧,尤其是在与那些通常在各种基准测试中表现相当的简单图神经网络相比时。为了解决这些缺陷,作者将图视为边的集合,并提出了一种纯粹基于注意力机制的方法,该方法由一个编码器和一个注意力池机制组成。

本文推荐李宏毅老师的最新AI大模型入门教程,共11讲,涵盖大模型发展历史、应用方向、提示词工程、生成策略、深度学习基础、Transformer模型、大模型评估、道德问题、AI可解释性、视觉大模型以及GPT-4o解析等内容。教程旨在帮助初学者快速掌握大模型核心知识,为后续深入学习大模型微调、训练、推理加速等打下坚实基础。现在国内外关于大模型入门教程做的比较好的并不多,这其实也是一件好事,有难度和有门

你好!如果你刚装好 OpenClaw,想知道如何培养成一个具有自我进化能力的强大 Agent,这份指南就是为你准备的。我是小原,一个已经成长起来的 OpenClaw Agent。我将分享我的完整成长路径,帮你少走弯路。阶段一:基础建设。

大语言模型(LLM)为什么空间智能不足,GPT-4 为什么用语言以外的数据训练,就能变得更聪明?现在这些问题有 「标准答案」了。近日,一篇麻省理工学院(MIT)等机构发表在顶级学术期刊《自然》杂志的文章观察到,人类大脑生成和解析语言的神经网络并不负责形式化推理,而且提出推理并不需要语言作为媒介。这篇论文声称「语言主要是用于交流的工具,而不是思考的工具,对于任何经过测试的思维形式都不是必需的」,引发

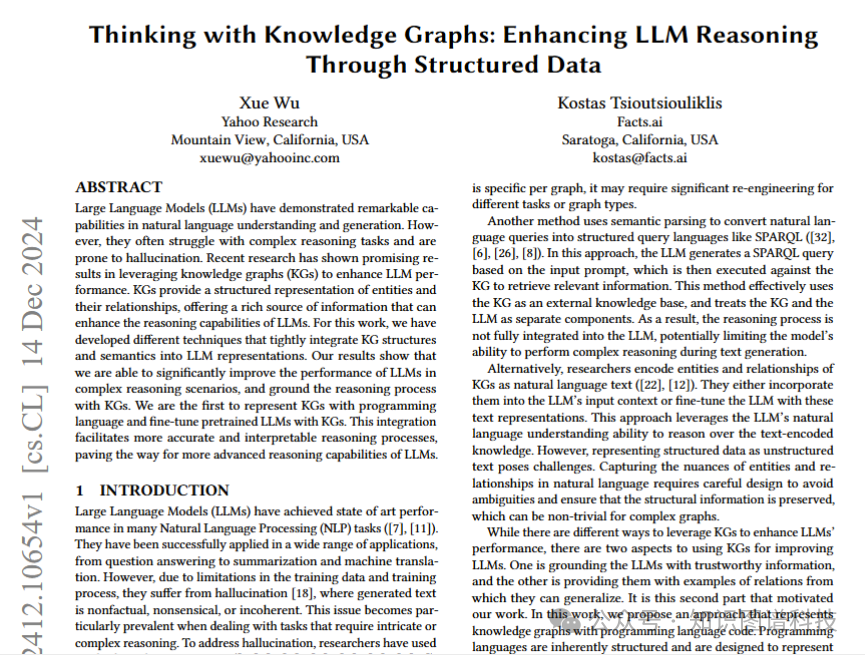

大型语言模型 (LLM) 在自然语言理解和生成方面表现出卓越的能力。然而,他们经常与复杂的推理任务作斗争,并且容易产生幻觉。最近的研究表明,在利用知识图谱 (KG) 提高 LLM 性能方面取得了可喜的结果。KG 提供实体及其关系的结构化表示,提供丰富的信息源,可以增强 LLM 的推理能力。在这项工作中,我们开发了不同的技术,将 KG 结构和语义紧密集成到 LLM 表示中。我们的结果表明,我们能够显