简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

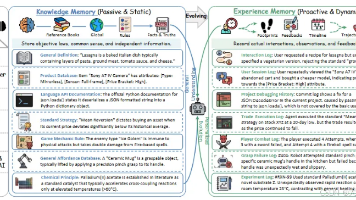

若你构建需长期可靠运行的AI代理,证据日益清晰:你需结构,你需图。本体定义代理理解形状。图为其形状提供家园——可存储、查询、遍历与演化。共同,它们将代理记忆从过去文本被动日志转为代理世界主动、组织、自改进模型。这是我们追求方向,且欣慰见其广博成长研究验证。记忆最佳的代理非数据最多者,而是理解所知结构者。

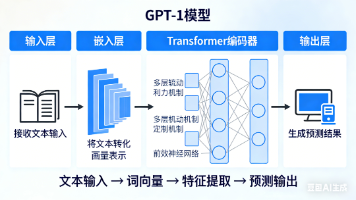

是不是感觉全世界都在聊AI,但那些层出不穷的新词——LLMPromptAgentRAGMCPSkills——让你眼花缭乱,想加入讨论却不知从何说起?别担心,这不是你的问题。清空大脑,忘记所有你听过或没听过的术语。接下来,我用一个完整的故事,把这些概念串成一条清晰的逻辑线,保证你看完就能懂。一切,都从那个古老的起点开始。那时的模型还是个“小玩具”,能力有限。但研究者们发现,当模型的参数规模(你可以简

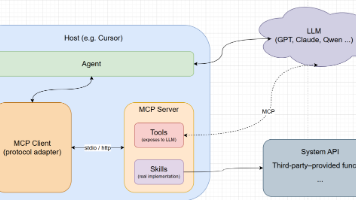

本文深入浅出地介绍了AI大模型的核心概念,包括Agent(AI智能体)、LLM(大语言模型)、Tools(接口说明书)、Skills(能力实现)和MCP(模型上下文协议)。文章通过实例解析了它们之间的协作流程,帮助读者建立对AI架构体系的基础认知,为后续实践AI技术打下坚实基础。现在看这些还是一头雾水,没关系,我来一一为你道来。这里再做一次总结,Agent 是有感知、会决策、能行动的 AI 系统。

在B站讲论文的李沐大神被曝出从亚马逊离职,与导师一同投身大模型创业。无独有偶,快手前AI核心人物李岩,也被曝出加入大模型创业赛道。最近,互联网大佬纷纷投身大模型赛道。昨天,李沐大神离职亚马逊、去做大模型的消息,如同惊雷一般炸响了大家的社交网络。紧接着,今天又曝出前快手AI核心大佬李岩在2022年离职快手后成立的新公司,做的也是大模型。显然,自从ChatGPT让全世界看到了AI上天入地般的应用场景,

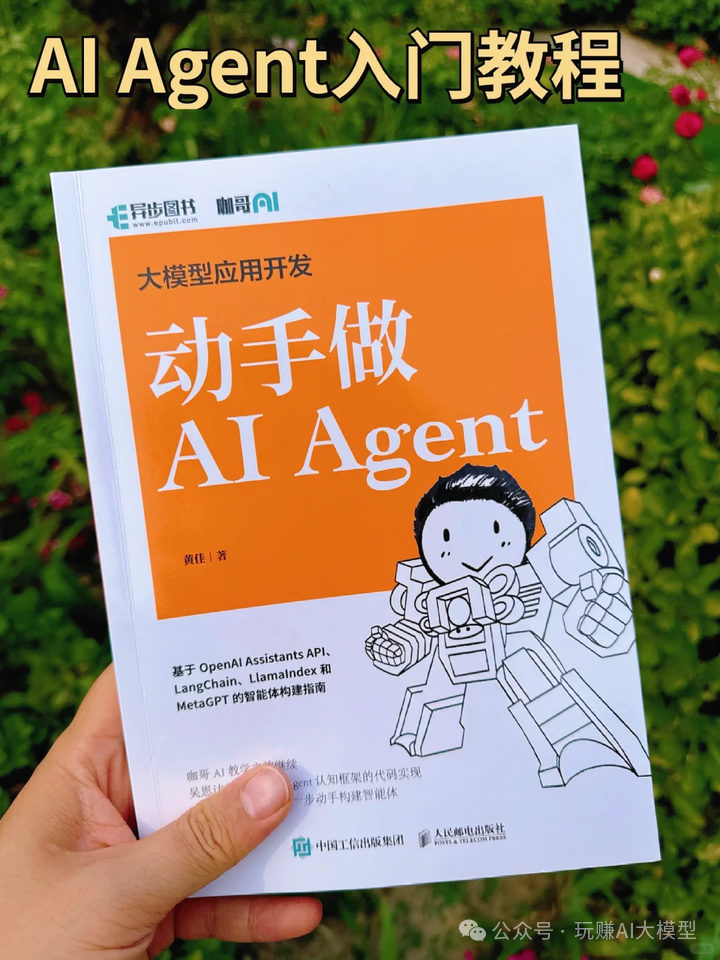

书中不仅介绍了Agent的定义、特性与技术架构,还详细讲解了构建Agent的AI技术工具,并以7个实战项目展示了Agent开发的方法。此书结合传统文化哲理与现代科技前沿,提出了一套Agent开发的系统性方法论,实战性强,适合想要转型的程序员、AI领域的专业研究人员阅读,对Agent技术感兴趣的技术爱好者、企业负责人、高等院校师生也都可以从本书中有所收获。✔️基础知识~定义了 Agent 的概念,然

AI Agent(AI 智能体):一种结合人工智能与一系列工具的应用。

本文分享了高效搭建AI智能体的五个关键要点:精准定位高频重复需求、拆解任务流程为独立节点、善用平台现成工具、迭代优化提示词质量、从解决个人小问题入手。通过这套方法,新手也能快速构建实用的AI智能体,提升工作效率。文章还指出大模型技术催生了Prompt工程师等新兴岗位,并附赠大模型学习资源包,帮助读者把握AI时代的职业机遇。

RAG技术通过语义搜索增强LLM回复准确性,降低"幻觉"风险。其核心流程包括:将知识库文档切片并向量化存储;用户提问时进行语义检索;对结果重排序后输入LLM生成可信回复。关键环节涉及嵌入模型选择、切片策略优化、相似度计算和查询改写等。该技术能提供信息溯源,特别适用于财务等对准确性要求高的场景。目前百度千帆、dify等平台已实现RAG功能,通过优化各环节显著提升了知识检索效果。

书籍第一部分(1-8章)内容为初学者水平,从自上而下的方法开始,使用预训练模型,然后详细解释了pytorch,从基础层面解释了用于图像分类的多层感知器和卷积神经网络。,那你一定要看看这本书!第三部分(15章)主要介绍了pytorch的部署内容,内容非常简明,表明PyTorch的部署工具并不复杂。听起来好像很多,但得益于其轻松的风格和语气,使读者阅读起来相当畅快!并且因为深度学习内容冗长,于是作者缩

年前,字节跳动正式发布,凭借多模态音视频生成、工业级可控性等核心能力,再次刷新全球AI大模型的技术上限,成为AI视频领域的里程碑式产品。另一边,也在全力扩张团队,高薪招募多语言AI搜索引擎、智能体(Agent)方向开发人才,持续加码AGI与大模型落地技术,正面迎战OpenAI、Alphabet等全球科技巨头,AI赛道竞争进入白热化阶段。这并不是个别企业的动作,而是整个互联网行业的集体趋势。