简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在 [1701.06538] Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer 中,作者(也包括大名鼎鼎的 Geoffrey Hinton 和 Jeff Dean)将 MoE 引入到 LSTM 模型中,并提出了稀疏 MoE(Sparse MoE)的概念。在 Sparse MoE 中可以包含

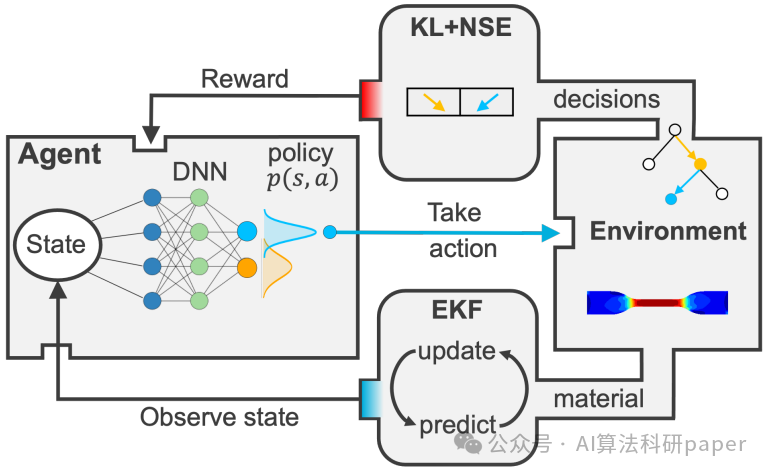

先说说这篇Nature封面,讲的是一个名为Swift的自主无人机竞速系统,通过结合强化学习和卡尔曼滤波,在无人机竞速领域实现了与人类世界冠军媲美的竞技水平,还创下了有记录以来的最快赛事时间。显而易见,这么炸裂的成果得益于这种结合的诸多优势。更具体点就是,强化学习可以利用卡尔曼滤波提供的高精度状态估计来做出更加明智和精确的决策,这样**不仅提高了决策的准确性和系统的鲁棒性,还带来了实时性和计算效率的

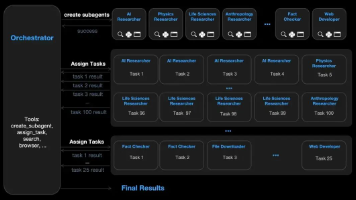

Agent技术已进入"傻瓜式操作"时代,Kimi引入的Agent集群能调度100个子Agent并行处理1500个步骤。AI应用正从"编程思维"转向"管理思维",核心竞争力从写Prompt变为定义正确问题。当AI能自动拆解复杂任务时,用户应将其视为可指挥的"部门"或"军队",才能充分利用技术红利,从执行者晋升为数字化团队的CEO。

文章全面介绍AI智能体生态系统,分析基础模型及面向不同场景的AI Agent,特别是编程与开发者Agent如文心快码、GitHub Copilot等。提供选择AI Agent的三个维度,并展望多智能体协同、垂直专业化、边缘化部署的未来趋势。

随着AI Agent兴起,传统记忆管理方式(长上下文、RAG)已无法满足需求。独立Memory层作为系统资源,通过分层管理和全局调度,实现记忆资产的可迁移、可治理、可复用。这一趋势将成为大模型和Agent发展的关键基础设施,推动AI从助手进化为真正的智能伙伴。

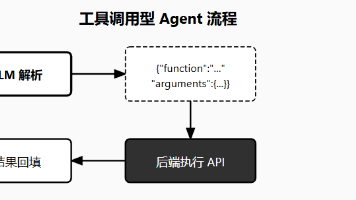

本文解析字节、阿里、腾讯等大厂落地的20种Agent架构,分为单轮执行、多轮规划、多Agent协作和垂直行业四类。从工具调用、意图路由到自主团队,系统介绍每种架构的工作原理、应用场景和设计要点。强调Agent核心是任务执行而非对话,应根据复杂度选择合适架构,避免过度设计。文末附完整代码和Prompt,可直接用于实践开发。

文章详细介绍了AI Agent记忆系统的架构与实现,包括短期记忆(会话级)和长期记忆(跨会话)的概念与区别,以及各Agent框架如何集成记忆系统。重点讲解了短期记忆的上下文工程策略和长期记忆的技术架构,以及当前行业发展趋势和产品对比,为开发者构建智能Agent提供了全面的技术参考。

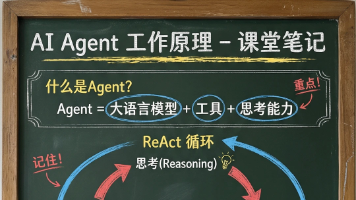

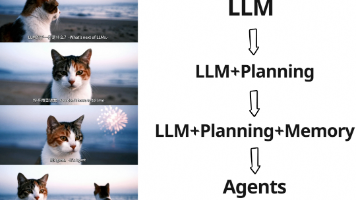

AI Agent是能理解意图并主动执行任务的智能系统,不同于传统AI仅被动回答问题。其核心工作流程是"目标→观察→行动→环境变化→循环"的闭环。Agent系统包含推理引擎、规划、记忆和工具四大组件。随着LLM发展,Agent技术已进入多智能体协作阶段,涌现出AutoGPT、Dify、LangChain等主流框架。当前Agent主要应用于AIGC内容创作、办公自动化和垂直行业知识助手等领域,但仍面临

本文详解检索增强生成(RAG)技术如何解决大语言模型的三大痛点:上下文有限、静态知识和专业领域知识缺乏。系统讲解构建知识库的完整流程,包括文档加载、文本分割、向量化及向量存储等关键组件,并提供最佳实践与性能优化建议。通过模块化设计、流式处理和统一接口,开发者可灵活构建高效的RAG系统,让大模型基于特定领域知识生成更准确回答。

谷歌云发布的10种实用AI Agent技巧,涵盖创意生成、文档处理、销售支持、代码调试等多场景应用,提供真实可用的提示词示例。从一键搜索全公司数据到代码错误修复,从个性化客户体验到HR流程简化,无论技术小白还是开发者,均可通过预置代理库、无代码设计器或Vertex AI平台快速上手,大幅提升工作效率。