简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Agent AI 的终极目标,是让机器像人类一样通过持续环境交互实现自我进化。研究者构想:未来,虚拟智能体能在元宇宙中自主创建场景,物理机器人能通过社区共享经验快速掌握新技能,而多模态交互将打破鼠标键盘的限制,实现 “语音 + 手势 + 表情” 的自然沟通。正如论文所言:“当智能体既能感知情绪,又能调整行为时,它们将不再是工具,而是与人类共生的‘数字伙伴’。”

AI Agent智能体的核心原理与应用 AI Agent是一种能自主感知、决策和执行的智能实体,区别于依赖提示词的大模型,它通过目标驱动实现任务自动化。其核心技术包括: 任务规划:利用大模型的思维链(Chain of Thought)和思维树(Tree of Thought)分解复杂任务,结合自省机制(如ReAct框架)优化决策; 记忆系统:短期记忆受限于模型上下文窗口,长期记忆通过向量数据库实现

本文介绍了如何利用LoRA技术和4位量化方法在24GB显存的普通GPU上微调DeepSeek大模型。DeepSeek凭借高效的MLA架构和低显存占用优势,成为开发者微调的热门选择。文章系统讲解了从理论原理到实战操作的全流程,包括交叉熵损失函数、数据子集策略等核心概念,重点解析了LoRA技术如何通过低秩矩阵分解将可训练参数压缩至1%以下,以及4位量化如何将内存需求降至1/8。通过IMDB情感分类任务

摘要:本文介绍了零代码本地部署大模型的完整流程,使用Ollama+DeepSeek+Dify组合方案,解决数据隐私、离线使用和成本控制三大痛点。教程详细拆解了Ollama环境安装(含路径优化)、DeepSeek模型部署(支持低配设备)、Dify可视化平台接入等关键步骤,并提供了Chatbox备选方案。特别总结了5个高频避坑点,如模型路径修改后需重启、名称需严格匹配等。最后指出该方案可应用于私域知识

【配套新书教材】《自然语言处理原理与实战》(人工智能科学与技术丛书)【陈敬雷编著】【清华大学出版社】新书特色:本书从自然语言处理基础开始,逐步深入各种NLP热点前沿技术,使用了Java和Python两门语言精心编排了大量代码实例,契合公司实际工作场景技能,侧重实战。

北京大学团队推出的Video-LLaVA与LLaVA-NeXT-Video在视频理解领域取得重大突破。Video-LLaVA通过"提前对齐"策略统一图像和视频特征处理,采用两阶段训练显著提升多模态理解能力,在多个视频问答基准测试中创下SOTA记录。LLaVA-NeXT-Video则基于LLaMA3等大模型架构,通过零样本学习和动态规划优化在视频任务中表现优异。两者分别以特征对齐

OpenAI即将推出的GPT-5或将彻底改写AI格局,深度融合多模态处理与深度推理能力,实现从"专项能手"到"全能助手"的跨越。GPT-5将整合原GPT系列的多模态优势与O系列的推理专长,并引入Operator代理的自主行动能力,为用户提供一站式解决方案。这一突破性技术有望解决用户在不同模型间频繁切换的痛点,在教育、设计、职场等多个场景实现更流畅的人机交互。

摘要: MCP(模型上下文协议)是Anthropic提出的AI工具调用统一标准,旨在解决不同模型与工具间的生态壁垒问题。通过"主机-服务器-客户端"三元架构,MCP实现了动态工具发现、跨模型兼容和双向通信,显著区别于OpenAI Function Call等封闭方案。该协议支持从Claude到本地小模型的广泛适配,已应用于企业数据整合、开发者工具复用及个人智能体开发。尽管面临安

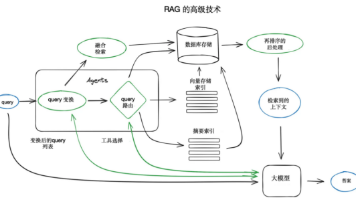

RAG(检索增强生成)技术架构详解:从基础到高级应用 本文节选自陈敬雷的新书《GPT多模态大模型与AI Agent智能体》,详细解析了RAG技术架构及其应用。RAG通过检索外部知识库辅助大模型生成答案,其基础架构包括七个关键环节:数据准备、分块与向量化、建立索引、检索过程、上下文提供、生成答案和后处理。高级技术架构则进一步引入了查询转换、聊天引擎、智能体等优化策略,使系统更加智能灵活。文章特别强调

多模态AI Agents正在重塑人机交互,通过整合文本、图像、语音等多维度信息,突破传统AI的信息割裂、场景适应和交互自然性三大瓶颈。四大核心技术支撑其发展:数据融合打破模态壁垒,联合学习实现多模态协同训练,跨模态迁移学习促进知识复用,动态推理机制增强灵活应变能力。5大核心模式构建智能"操作系统":反射模式实现自我修正,工具使用模式扩展外部能力,ReAct模式模拟人类思考-行动