简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

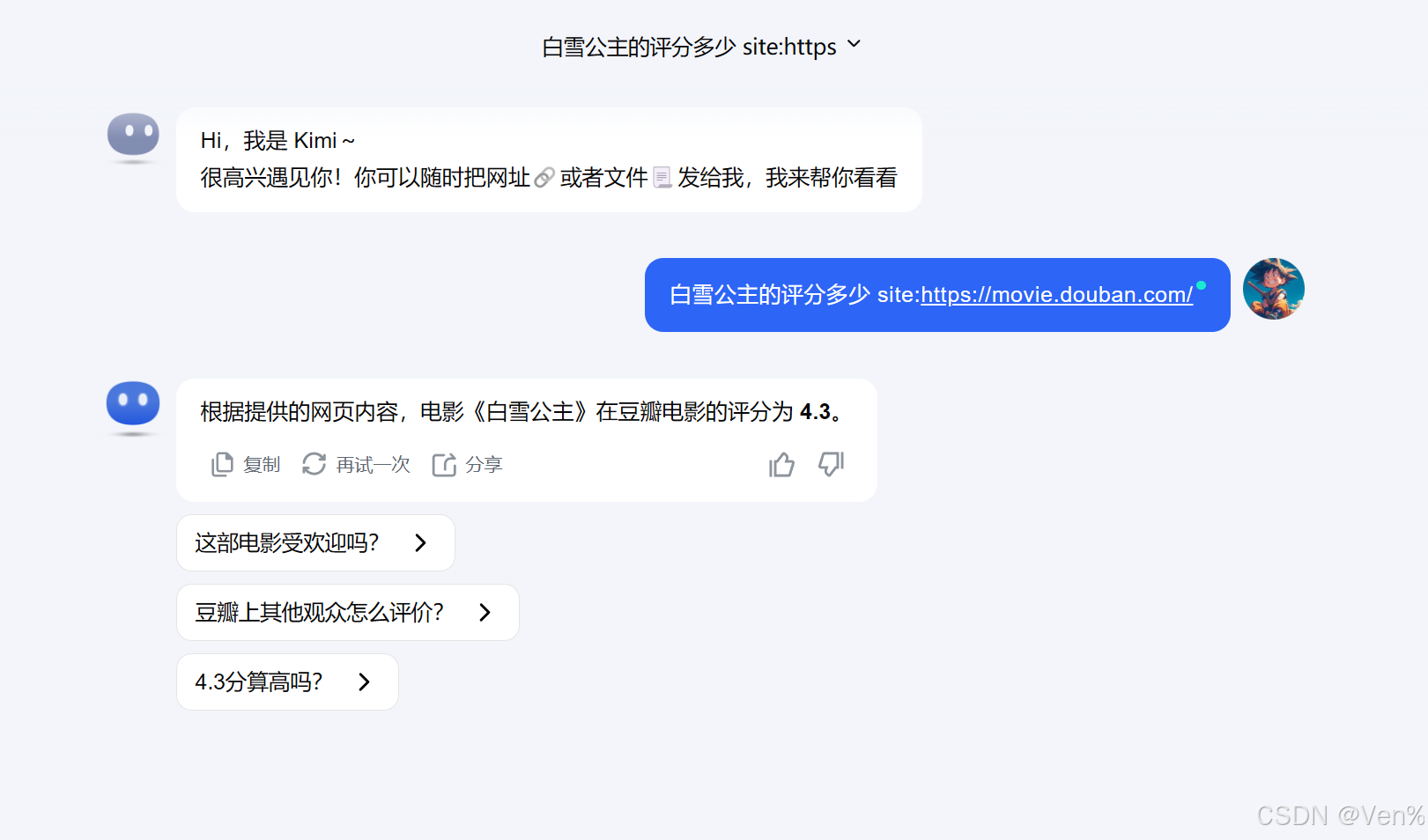

因为kimi的联网搜索,底层也是一个搜索引擎来的,因此在输入你的问题的时候再加上。使用场景:例如只让AI回答公司官网的信息,只基于某篇论文来问AI等等。这样就可以限制AI的搜索范围了。

OpenHands 以开源开放性和模块化设计,在功能上已实现对 Manus 的全面平替。多模态融合:支持图像/语音指令输入(参考 GAIA 基准 Level3 任务);强化学习微调:基于历史任务数据持续优化代理决策能力。项目地址文档:https://openhands.ai/docs/running让每个人都能拥有超级 AI 生产力——OpenHands 正将这一愿景变为现实。

要在关闭 SSH 远程连接后继续运行nohup是一个常用的工具,可以让进程在关闭终端后继续运行。

通过以上步骤,Ollama服务即可被外部服务器访问。此方法同样适用于其他需绑定公共网络接口的服务。通过修改systemd配置,强制Ollama监听所有网络接口(访问,会出现连接失败。这是因为服务未绑定到公共网络接口。若服务器启用了防火墙,需放行Ollama端口(默认。当部署Ollama服务后,默认监听地址为。),并重启服务生效。

RAGFlow升级数据备份与恢复指南 备份步骤: 查询各容器数据存储路径(MySQL、ES、MinIO、Redis) 进入/var/lib/docker/volumes/目录打包所有数据卷 使用tar命令分别备份四个数据目录 升级流程: 谨慎删除原容器(避免使用down -v) 执行git pull和checkout切换版本 重新启动项目 恢复方案: 如发现数据丢失,解压备份文件覆盖原目录 重新删

Self-Attention(自注意力机制):通过计算序列中每个位置与其他位置的关联度,捕捉长距离依赖关系。公式为:Attention(Q,K,V)=softmax(QK^T/√d_k)V。FFN(前馈神经网络):每个位置独立经过两层全连接层(通常中间维度扩大4倍),提供非线性变换能力。问题: 在圆圈中填写1-10的数字(每个数字使用一次),使每条线上数字的和为19。序列: 1, 3, 11, 4

这三种微调策略的选择取决于不同的需求和情况。Full微调适用于全面调整模型的情况,而Freeze微调适用于只关注特定任务的情况。LoRA微调则提供了一种更加灵活的方式来调整模型在不同层级上的相关性。

在深度学习和其他机器学习任务中,F1分数和F2分数是评估分类模型性能的指标,特别是在二分类问题中。它们都是基于精确率(Precision)和召回率(Recall)的,但权重不同。

java非空判断是否为null是否为" "是否为空字符串(引号中间有空格)如: ""制表符、换行符、换页符和回车一. 字符串i为空非空if(str == null || str == " ")非空if(str ! =null&&str! =" ")if(str == null || str.isEmpty())if(str != null && !str.isEmp

这是因为较大的批次大小提供了更稳定但可能较不精确的梯度估计,而较大的学习率可以帮助模型在优化过程中迈出更大的步伐。较大的数据集可能允许使用较大的批次大小,而较小的数据集可能需要较小的批次大小以确保模型能够从每个批次中学习到有效的信息。最终,确定最佳学习率和批次大小通常需要结合具体任务、数据集和模型的特点,并通过实验来不断调整和优化。:在训练过程中,可能需要使用学习率调度策略,如学习率衰减或warm