简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

深度学习入门之Batch Normalization

Batch Normalization 的算法Batch Normalization(下文简称 Batch Norm)是 2015 年提出的方法。Batch Norm 虽然是一个问世不久的新方法,但已经被很多研究人员和技术人员广泛使用。实际上,看一下机器学习竞赛的结果,就会发现很多通过使用这个方法而获得优异结果的例子。为什么 Batch Norm 这么惹人注目呢?因为 Batch Norm 有以下

机器学习-回归模型相关重要知识点

回归模型相关重要知识点

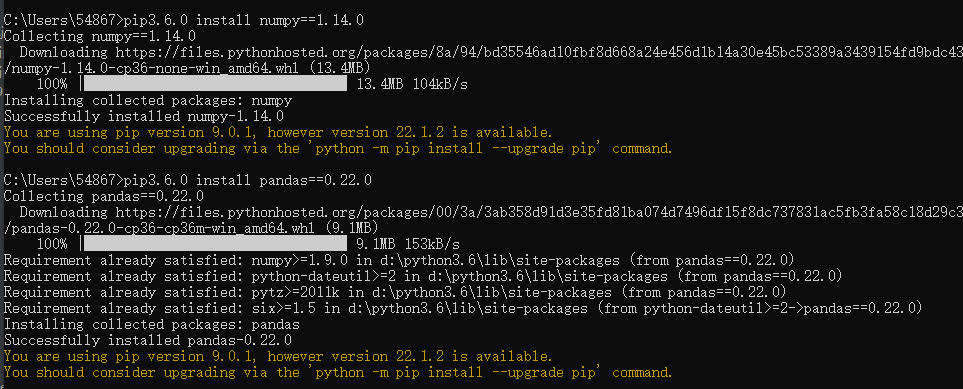

Python安装指定的版本包的方法如numpy和pandas(亲测有效)

python安装numpy和pandas

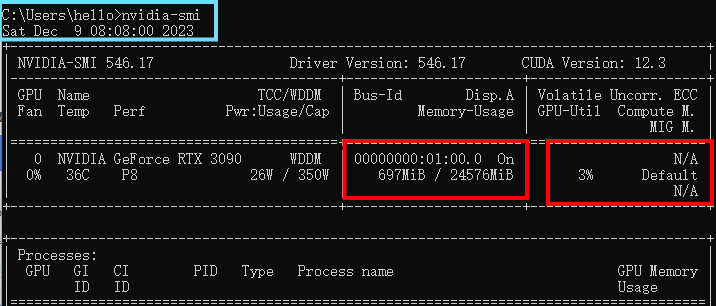

windows查看GPU信息(nvidia-smi)及tensorflow-gpu的安装

tensorflow-gpu安装

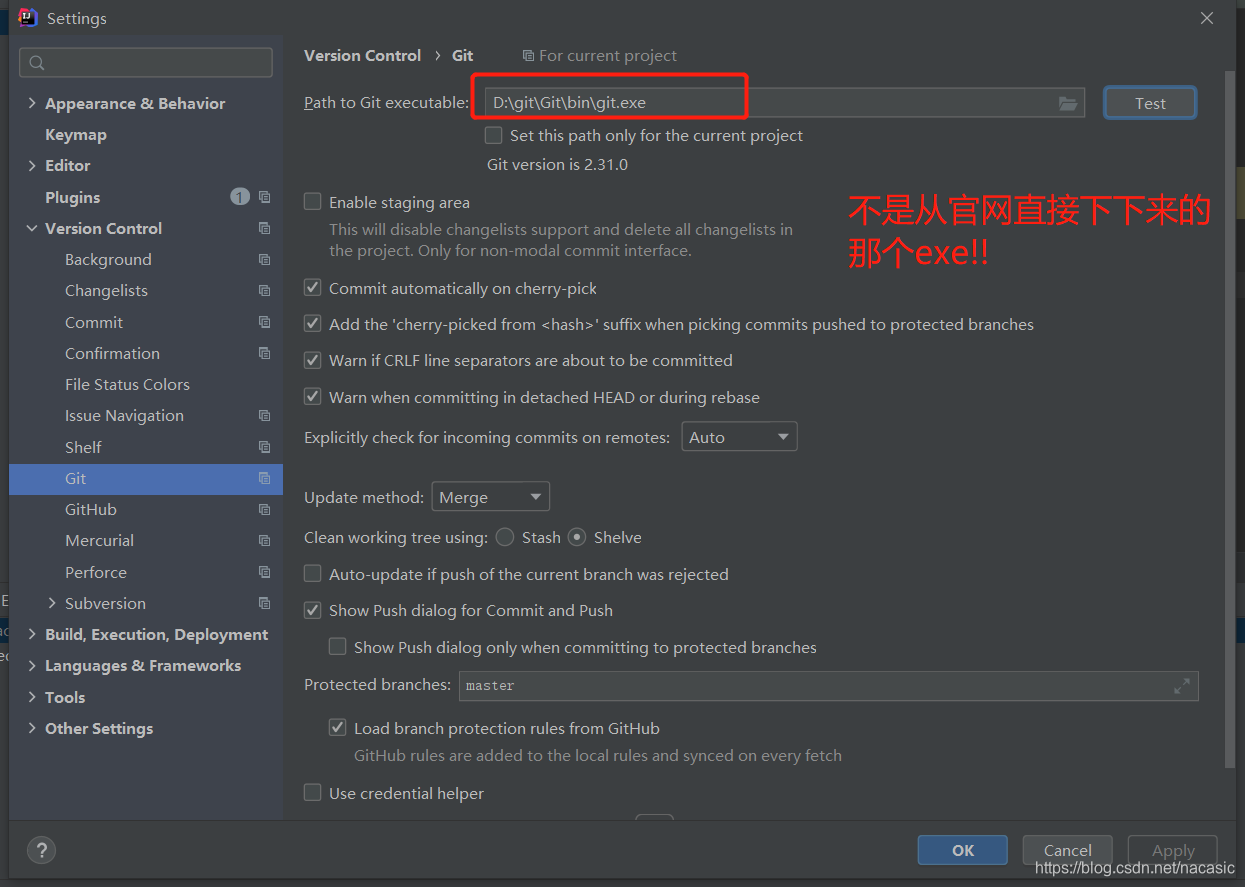

idea或pycharm出现Сannot Run Git Cannot identify version of git executable

idea或pycharm出现Сannot Run Git Cannot identify version of git executable

Python中的异常处理raise介绍

Python异常处理raise介绍

Excel表格中在原单元格数据上乘以一个数

原单元格数据上乘以一个数

EXCEL实战 第2章 数据分析

excel数据分析