简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

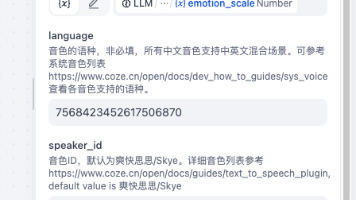

本文介绍如何在Dify平台通过Workflow工作流实现文本情感解析与语音合成的自动化流程。主要步骤包括:1)创建Workflow应用并设置用户输入节点;2)使用LLM模型解析文本情感、语速等参数;3)通过MCP语音合成插件生成MP3音频;4)最终以Markdown格式返回可播放链接。该方案适合需要集成TTS功能并实现参数自动解析的场景,支持Coze/MCP插件,可一键导入YAML配置文件快速部署

摘要: 本文详细介绍在Linux系统(Ubuntu/Debian/CentOS等)使用xfreerdp3远程连接Windows主机的方法。内容涵盖:xfreerdp3的安装(APT/DNF命令)、基础连接命令(IP/端口/账号)、实战参数(分辨率设置、剪贴板共享、全屏模式)、安全建议(避免明文密码)以及常见错误解决方案(登录失败/证书警告)。提供推荐的全参数命令模板,适用于运维开发场景,强调内网安

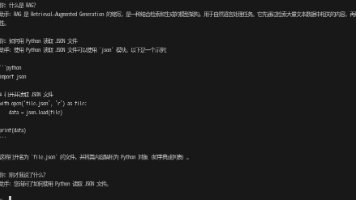

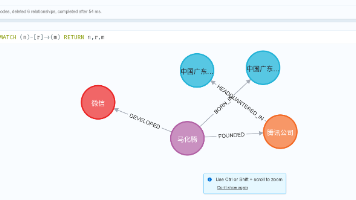

在本教程中,我们将从零开始,使用 Ollama 本地大模型(Qwen2.5:7B) + LangChain + Neo4j 图数据库,构建一个完整的中文知识图谱系统。整个流程包括:

本文以Coze Studio为例,提出了一种基于项目边界的Docker资源清理方法。通过分析Coze项目的容器和镜像命名特征(统一使用"coze"前缀),制定了一套安全清理策略:先定义保留规则(名称含"coze"的资源),再删除其他无关资源。文章详细介绍了具体操作命令,强调预览确认的重要性,并指出该方法适用于命名规范清晰的开发测试环境,但不适用于生产环境或命

本文介绍了在Coze Studio中配置古诗词插件的完整步骤。首先创建gushi.yaml文件定义接口规范,配置获取古诗词的API路径和响应格式。然后在plugin_meta.yaml中添加插件元数据,包括插件ID、版本、描述等信息,并设置无需认证的访问方式。最后通过Docker命令重启服务使配置生效。该插件通过调用"今日诗词"开放接口(https://v1.jinrishic

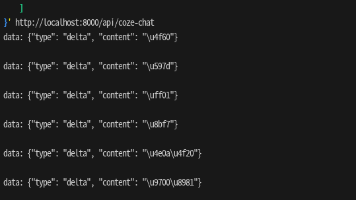

本文介绍了如何通过Coze MCP插件API调用提示词优化工具(sd_better_prompt)的完整流程。详细说明了使用curl命令发起POST请求的参数配置,包括请求头设置和JSON-RPC格式的请求体结构。重点解析了服务端返回的事件流数据,展示了优化前后的提示词对比示例。通过该接口,用户可以将简单提示词(如"1girl")转化为包含画质、细节、光照等丰富参数的高质量提示

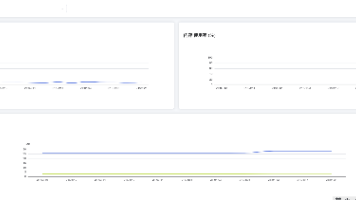

摘要 本文介绍了一个基于Python Tornado、WebSocket、Vue3和ECharts的Docker实时监控系统实现方案。系统采用前后端分离架构:后端通过Tornado框架建立WebSocket服务,实时收集Docker容器的CPU、内存、网络等性能指标;前端使用Vue3和Element Plus构建用户界面,通过ECharts图表库可视化展示监控数据。系统支持容器选择切换和鼠标悬停查

本文介绍了一个用Go语言快速搭建的Coze API流式回复模拟接口(Mock Server),用于前端开发测试。该接口完美模拟Coze的SSE流式结构,支持逐字打字机效果(50-150ms延迟)、Markdown渲染、自动发送结束标志等功能。代码简洁(不到100行),无需额外配置即可支持CORS跨域调用。开发者只需修改fullResponse变量内容,就能自定义测试各种回复场景,极大提升前端开发效

本文介绍如何使用 FastAPI 和 Coze Python SDK 实现流式聊天 SSE 接口。该方案支持实时推送聊天消息,提供打字机效果,采用标准 SSE 格式便于前端解析。文章包含完整代码示例,展示如何初始化 Coze 客户端、处理流式响应并兼容不同 SDK 版本。接口可直接通过 curl 测试,适合开发 AI 聊天应用。技术栈包括 Python 3.10+、FastAPI、uvicorn

摘要:本文介绍如何利用 Qwen2.5:7b 大模型结合 LangChain 和 Ollama 构建本地化AI助手。该方案支持多轮对话、流式输出和Token控制,适用于企业内网、开发者工具等场景。文章详细说明了环境配置、模型参数优化(如temperature=0.2提升稳定性)、流式输出实现,并提供了完整的Python代码示例,兼容最新LangChain版本。关键亮点包括动态上下文管理、实时交互体